Instagram verbindet riesiges Pädophilen-Netzwerk

Antiilluminaten TVDie Systeme der Meta-Einheit zur Förderung von Gemeinschaften haben Nutzer zu kindersexuellen Inhalten geführt; das Unternehmen sagt, es verbessere die internen Kontrollen

Geschrieben von Jeff Horwitz und Katherine Blunt

Instagram, die beliebte Social-Media-Website, die zu Meta Platforms gehört, hilft dabei, ein riesiges Netzwerk von Konten zu verbinden und zu fördern, die sich offen der Beauftragung und dem Kauf von minderjährigen sexuellen Inhalten widmen, wie Untersuchungen des Wall Street Journal und von Forschern der Stanford University und der University of Massachusetts Amherst ergeben haben.

Pädophile nutzen das Internet schon lange, aber im Gegensatz zu Foren und Dateitransferdiensten, die sich an Menschen richten, die Interesse an illegalen Inhalten haben, beherbergt Instagram diese Aktivitäten nicht nur. Seine Algorithmen fördern sie. Instagram verbindet Pädophile und führt sie über Empfehlungssysteme zu Anbietern von Inhalten, die sich dadurch auszeichnen, dass sie diejenigen miteinander verbinden, die Nischeninteressen teilen, so die Ergebnisse der Zeitschrift und der Wissenschaftler.

Obwohl sie für die meisten Nutzer der Plattform nicht sichtbar sind, zeigen die sexualisierten Konten auf Instagram schamlos ihr Interesse. Die Forscher fanden heraus, dass Instagram es den Nutzern ermöglichte, nach expliziten Hashtags wie #pedowhore und #preteensex zu suchen und sie mit Konten zu verbinden, die diese Begriffe verwendeten, um für den Verkauf von kindersexuellem Material zu werben. Solche Konten geben oft vor, von den Kindern selbst betrieben zu werden, und verwenden offenkundig sexuelle Handles mit Worten wie "kleine Schlampe für dich".

Instagram-Konten, die den Verkauf von illegalem Sex-Material anbieten, veröffentlichen es in der Regel nicht offen, sondern stellen stattdessen "Menüs" mit Inhalten ein. Einige Konten laden Käufer dazu ein, bestimmte Handlungen in Auftrag zu geben. Einige Menüs enthalten Preise für Videos von Kindern, die sich selbst verletzen, und "Bilder von Minderjährigen, die sexuelle Handlungen mit Tieren vollziehen", fanden Forscher des Stanford Internet Observatory heraus. Für den richtigen Preis sind Kinder für persönliche "Treffen" verfügbar.

Die Förderung sexueller Inhalte für Minderjährige verstößt sowohl gegen die von Meta aufgestellten Regeln als auch gegen Bundesrecht.

In Beantwortung von Fragen des Journals räumte Meta Probleme bei der Durchsetzung der Vorschriften ein und erklärte, es habe eine interne Arbeitsgruppe eingerichtet, die sich mit den angesprochenen Problemen befassen soll. "Die Ausbeutung von Kindern ist ein schreckliches Verbrechen", sagte das Unternehmen und fügte hinzu: "Wir suchen ständig nach Wegen, um uns aktiv gegen dieses Verhalten zu wehren."

Meta hat nach eigenen Angaben in den letzten zwei Jahren 27 pädophile Netzwerke aus dem Verkehr gezogen und plant weitere Löschungen. Seit Erhalt der Journal-Anfragen hat die Plattform nach eigenen Angaben Tausende von Hashtags blockiert, die Kinder sexualisieren, einige mit Millionen von Beiträgen, und ihre Systeme daran gehindert, Nutzern die Suche nach Begriffen zu empfehlen, die bekanntermaßen mit sexuellem Missbrauch in Verbindung gebracht werden. Die Plattform erklärte, dass sie auch daran arbeitet, ihre Systeme daran zu hindern, potenziell pädophilen Erwachsenen zu empfehlen, miteinander in Kontakt zu treten oder mit den Inhalten der anderen zu interagieren.

Alex Stamos, Leiter des Stanford Internet Observatory und bis 2018 Chief Security Officer von Meta, sagte, dass selbst offensichtlicher Missbrauch nur durch anhaltende Bemühungen unter Kontrolle gebracht werden kann.

"Dass ein Team von drei Akademikern mit beschränktem Zugang ein so großes Netzwerk finden konnte, sollte bei Meta Alarm auslösen", sagte er und merkte an, dass das Unternehmen über weitaus effektivere Werkzeuge verfügt, um sein pädophiles Netzwerk abzubilden, als Außenstehende es tun. "Ich hoffe, dass das Unternehmen wieder in menschliche Ermittler investiert", fügte er hinzu.

PHOTO: HELYNN OSPINA FOR THE WALL STREET JOURNAL

Aufgrund technischer und rechtlicher Hürden ist es für jeden außerhalb von Meta schwierig, das gesamte Ausmaß des Netzes genau zu erfassen.

Da die Gesetze im Zusammenhang mit kindersexuellen Inhalten extrem weit gefasst sind, ist selbst die Untersuchung der offenen Förderung dieser Inhalte auf einer öffentlichen Plattform rechtlich heikel.

Für seine Berichterstattung hat das Journal akademische Experten für die Sicherheit von Kindern im Internet konsultiert. Das Internet Observatory in Stanford, eine Abteilung des Cyber Policy Center der Universität, die sich mit dem Missbrauch sozialer Medien befasst, erstellte eine unabhängige quantitative Analyse der Instagram-Funktionen, die den Nutzern helfen, Verbindungen herzustellen und Inhalte zu finden.

Das Journal wandte sich auch an das Rescue Lab von UMass, das untersuchte, wie Pädophile auf Instagram in die größere Welt der Online-Kinderausbeutung passen. Mit unterschiedlichen Methoden konnten beide Einrichtungen schnell große Gemeinschaften identifizieren, die kriminellen sexuellen Missbrauch fördern.

Von den Forschern eingerichtete Testkonten, die ein einzelnes Konto im Netzwerk ansahen, wurden sofort mit "für dich vorgeschlagenen" Empfehlungen von angeblichen Verkäufern und Käufern von kindersexuellen Inhalten sowie von Konten, die zu plattformfremden Handelsplattformen für Inhalte verlinkten, konfrontiert. Es genügte, einer Handvoll dieser Empfehlungen zu folgen, um ein Testkonto mit Inhalten zu überfluten, die Kinder sexualisieren.

Das Stanford Internet Observatory verwendete Hashtags, die mit minderjährigem Sex in Verbindung gebracht wurden, um 405 Verkäufer von - wie die Forscher es nannten - "selbsterstelltem" kindersexuellem Material zu finden, d. h. Konten, die angeblich von Kindern selbst betrieben wurden, von denen einige angaben, sie seien erst 12 Jahre alt. Den Daten zufolge, die mit Maltego, einer Software zur Darstellung von Netzwerken, gesammelt wurden, hatten 112 dieser Verkäuferkonten zusammen 22.000 eindeutige Follower.

Die Ersteller und Käufer minderjähriger Sex-Inhalte sind nur ein Teil eines größeren Ökosystems, das sich mit sexualisierten Kinderinhalten befasst. Andere Konten in der pädophilen Gemeinschaft auf Instagram aggregieren pro-pädophile Memes oder diskutieren ihren Zugang zu Kindern. Aktuelle und ehemalige Meta-Mitarbeiter, die an Instagram-Initiativen zur Kindersicherheit gearbeitet haben, schätzen, dass die Zahl der Konten, die hauptsächlich dazu dienen, solchen Inhalten zu folgen, in die Hunderttausende, wenn nicht sogar in die Millionen geht.

Ein Meta-Sprecher sagte, dass das Unternehmen aktiv versucht, solche Nutzer zu entfernen und allein im Januar 490.000 Konten wegen Verletzung der Kindersicherheitsrichtlinien gelöscht hat.

"Instagram ist ein Sprungbrett zu Orten im Internet, an denen es expliziteren sexuellen Missbrauch von Kindern gibt", sagte Brian Levine, Direktor des UMass Rescue Lab, das die Viktimisierung von Kindern im Internet erforscht und forensische Instrumente zu deren Bekämpfung entwickelt. Levine ist Autor eines Berichts über die Ausbeutung von Kindern im Internet aus dem Jahr 2022 für das National Institute of Justice, den Forschungsarm des Justizministeriums.

Instagram, das schätzungsweise mehr als 1,3 Milliarden Nutzer hat, ist besonders bei Jugendlichen beliebt. Die Stanford-Forscher fanden ähnliche sexuell ausbeuterische Aktivitäten auf anderen, kleineren sozialen Plattformen, stellten aber fest, dass das Problem auf Instagram besonders gravierend ist. "Die wichtigste Plattform für diese Netzwerke von Käufern und Verkäufern scheint Instagram zu sein", schreiben sie in einem Bericht, der am 7. Juni veröffentlicht werden soll.

PHOTO: HELYNN OSPINA FOR THE WALL STREET JOURNAL

Instagram gab an, dass seine internen Statistiken zeigen, dass die Nutzer in weniger als einem von 10.000 angesehenen Beiträgen die Ausbeutung von Kindern sehen.

Die Bemühungen der Social-Media-Plattformen und der Strafverfolgungsbehörden, die Verbreitung von Kinderpornografie im Internet zu bekämpfen, konzentrieren sich weitgehend auf die Jagd nach bestätigten Bildern und Videos, die als Material über sexuellen Kindesmissbrauch oder CSAM bekannt sind und von denen bereits bekannt ist, dass sie im Umlauf sind. Das National Center for Missing & Exploited Children (Nationales Zentrum für vermisste und ausgebeutete Kinder), eine gemeinnützige US-Organisation, die mit den Strafverfolgungsbehörden zusammenarbeitet, unterhält eine Datenbank mit digitalen Fingerabdrücken solcher Bilder und Videos sowie eine Plattform für den Austausch solcher Daten zwischen Internetunternehmen.

Die Algorithmen der Internetunternehmen gleichen die digitalen Fingerabdrücke der auf ihren Plattformen veröffentlichten Bilder mit dieser Liste ab und melden dem Zentrum, wenn sie solche Bilder entdecken, wie es das US-Bundesgesetz vorschreibt. Im Jahr 2022 erhielt das Zentrum 31,9 Millionen Meldungen über Kinderpornografie, hauptsächlich von Internetunternehmen - 47 % mehr als zwei Jahre zuvor.

Meta, mit mehr als 3 Milliarden Nutzern in seinen Apps, zu denen Instagram, Facebook und WhatsApp gehören, ist in der Lage, diese Art von bekannten Bildern zu erkennen, wenn sie nicht verschlüsselt sind. Auf Meta entfielen 85 % der Kinderpornografie-Meldungen, die dem Zentrum übermittelt wurden, darunter etwa 5 Millionen von Instagram.

Metas automatisches Screening für bestehende Inhalte zur Ausbeutung von Kindern kann keine neuen Bilder oder Bemühungen, für deren Verkauf zu werben, erkennen. Um solche Aktivitäten zu verhindern und aufzudecken, müssen nicht nur die Meldungen der Nutzer überprüft, sondern auch pädophile Netzwerke aufgespürt und gestört werden, sagen aktuelle und ehemalige Mitarbeiter sowie die Forscher aus Stanford. Ziel ist es, es diesen Nutzern zu erschweren, miteinander in Verbindung zu treten, Inhalte zu finden und Opfer zu rekrutieren.

Diese Arbeit ist von entscheidender Bedeutung, da den Strafverfolgungsbehörden die Mittel fehlen, um mehr als einen winzigen Teil der Hinweise zu untersuchen, die beim NCMEC eingehen, so Levine von der UMass. Das bedeutet, dass die Plattformen in erster Linie dafür verantwortlich sind, zu verhindern, dass sich eine Gemeinschaft bildet und der sexuelle Missbrauch von Kindern normalisiert wird.

Meta hat mit diesen Bemühungen mehr zu kämpfen als andere Plattformen, sowohl wegen der schwachen Durchsetzung als auch wegen der Designmerkmale, die die Entdeckung von legalen und illegalen Inhalten fördern, so die Stanford-Studie.

Das Stanford-Team fand auf Twitter 128 Konten, die den Verkauf von Material über sexuellen Kindesmissbrauch anboten. Das ist weniger als ein Drittel der Zahl, die auf Instagram gefunden wurde, das eine weitaus größere Nutzerbasis hat als Twitter. Twitter empfahl solche Konten nicht in gleichem Maße wie Instagram und löschte sie viel schneller, fand das Team heraus.

Von den anderen Plattformen, die bei jungen Leuten beliebt sind, wird Snapchat hauptsächlich für Direktnachrichten genutzt und trägt daher nicht zum Aufbau von Netzwerken bei. Und TikTok ist eine Plattform, auf der sich diese Art von Inhalten nicht zu verbreiten scheint", so der Stanford-Bericht.

Twitter reagierte nicht auf Bitten um eine Stellungnahme. TikTok und Snapchat lehnten eine Stellungnahme ab.

David Thiel, Cheftechnologe am Stanford Internet Observatory, sagte: "Das Problem von Instagram liegt in den Funktionen zum Auffinden von Inhalten, in der Art und Weise, wie Themen empfohlen werden, und darin, wie sehr sich die Plattform auf die Suche und Links zwischen Konten verlässt." Thiel, der zuvor bei Meta an Sicherheitsfragen gearbeitet hat, fügte hinzu: "Man muss Leitplanken aufstellen, damit etwas, das so wachstumsintensiv ist, auch nominell sicher ist, und das hat Instagram nicht getan."

Die Plattform hat Schwierigkeiten, eine grundlegende Technologie zu überwachen: Schlüsselwörter. Hashtags sind ein zentraler Bestandteil der Entdeckung von Inhalten auf Instagram. Sie ermöglichen es den Nutzern, Beiträge zu markieren und zu finden, die für eine bestimmte Community von Interesse sind - von weit gefassten Themen wie #mode oder #nba bis hin zu enger gefassten Themen wie #stickerei oder #spelunking.

FOTO: STANFORD INTERNET OBSERVATORY

Auch Pädophile haben ihre eigenen Hashtags. Suchbegriffe wie #pedobait und Variationen von #mnsfw ("minor not safe for work") wurden verwendet, um Tausende von Beiträgen zu kennzeichnen, die Werbung für sexuelle Inhalte mit Kindern enthielten, so dass sie von Käufern leicht gefunden werden konnten, fanden die Wissenschaftler heraus. Auf Anfrage des Journals erklärte Meta, dass es dabei sei, solche Begriffe zu verbieten.

In vielen Fällen hat Instagram seinen Nutzern erlaubt, nach Begriffen zu suchen, von denen die eigenen Algorithmen wissen, dass sie mit illegalem Material in Verbindung gebracht werden können. In solchen Fällen warnte ein Pop-up-Fenster die Nutzer: "Diese Ergebnisse können Bilder von sexuellem Kindesmissbrauch enthalten", und wies darauf hin, dass die Produktion und der Konsum solchen Materials Kindern "extremen Schaden" zufügt. Der Bildschirm bot den Nutzern zwei Optionen: "Ressourcen abrufen" und "Ergebnisse trotzdem ansehen".

Als Reaktion auf die Fragen des Journals entfernte Instagram die Option, dass Nutzer Suchergebnisse für Begriffe anzeigen können, die wahrscheinlich illegale Bilder enthalten. Das Unternehmen lehnte es ab zu sagen, warum es diese Option angeboten hatte.

Die pädophilen Konten auf Instagram mischen Unverfrorenheit mit oberflächlichen Bemühungen, ihre Aktivitäten zu verschleiern, so die Forscher. Bestimmte Emojis fungieren als eine Art Code, wie z. B. das Bild einer Landkarte - eine Abkürzung für "minderjährige Person" - oder eines für "Käsepizza"(“cheese pizza,”) , das die gleichen Initialen wie "Kinderpornografie" trägt, so Levine von der UMass. Viele deklarieren sich als "Liebhaber der kleinen Dinge des Lebens".

Die Konten bezeichnen sich selbst als "Verkäufer" oder "s3ller", und viele geben in ihren Biografien ihre bevorzugte Zahlungsform an. Auf diesen Verkäuferkonten wird oft das angebliche Alter des Kindes angegeben, z. B. "ab Kapitel 14" oder "Alter 31", gefolgt von einem Emoji mit einem umgekehrten Pfeil.

Einige der Konten enthielten Hinweise auf Sexhandel, so Levine von der UMass, wie z. B. eines, das einen Teenager mit dem Wort WHORE im Gesicht zeigt.

Einige Nutzer, die behaupten, selbst produzierte Sex-Inhalte zu verkaufen, sagen, sie seien "gesichtslos" - sie bieten nur Bilder vom Hals abwärts an -, weil sie in der Vergangenheit Erfahrungen gemacht haben, bei denen sie von Kunden gestalkt oder erpresst wurden. Andere gehen das Risiko ein und verlangen einen Aufpreis für Bilder und Videos, die ihre Identität preisgeben könnten, indem sie ihr Gesicht zeigen.

Viele der Konten zeigen Nutzer mit Schnittnarben auf der Innenseite ihrer Arme oder Oberschenkel, und eine Reihe von ihnen geben an, in der Vergangenheit sexuell missbraucht worden zu sein.

Selbst ein flüchtiger Kontakt mit einem Konto in der pädophilen Community von Instagram kann dazu führen, dass die Plattform beginnt, Nutzer zu empfehlen, sich ihr anzuschließen.

Sarah Adams, eine kanadische Mutter von zwei Kindern, hat sich auf Instagram ein Publikum aufgebaut, das über die Ausbeutung von Kindern und die Gefahren des "Oversharing" in den sozialen Medien diskutiert. Angesichts ihres Schwerpunkts schicken Adams' Follower ihr manchmal verstörende Dinge, die sie auf der Plattform entdeckt haben. Im Februar, so sagte sie, schickte ihr einer eine Nachricht mit einem Konto, das mit dem Begriff "Inzest-Kleinkinder" gebrandmarkt war.

Adams sagte, sie habe das Konto - eine Sammlung von Inzest-Memes mit mehr als 10.000 Anhängern - nur für die wenigen Sekunden aufgerufen, die sie brauchte, um es an Instagram zu melden, und dann versucht, es zu vergessen. Doch im Laufe der nächsten Tage hörte sie immer wieder von entsetzten Eltern. Als sie sich Adams' Instagram-Profil ansahen, sagte sie, dass ihnen aufgrund von Adams' Kontakt mit dem Konto "Inzest-Kleinkinder" empfohlen worden seien.

Ein Meta-Sprecher sagte, dass "Inzest-Kleinkinder" gegen die Regeln des Unternehmens verstoßen und dass Instagram bei der Durchsetzung einen Fehler gemacht habe. Das Unternehmen sagte, es plane, solche unangemessenen Empfehlungen im Rahmen seiner neuen Kindersicherheits-Taskforce anzugehen.

Wie bei den meisten Social-Media-Plattformen basieren die Empfehlungen von Instagram im Wesentlichen auf Verhaltensmustern und nicht auf der Zuordnung der Interessen eines Nutzers zu bestimmten Themen. Dieser Ansatz ist effizient, um die Relevanz der Empfehlungen zu erhöhen, und er funktioniert am zuverlässigsten für Gemeinschaften, die eine enge Gruppe von Interessen teilen.

Theoretisch sollte es die enge Gemeinschaft der Pädophilen auf Instagram für Instagram einfacher machen, das Netzwerk zu kartieren und Maßnahmen zu seiner Bekämpfung zu ergreifen. Aus Dokumenten, die das Journal bereits eingesehen hat, geht hervor, dass Meta diese Art von Arbeit in der Vergangenheit geleistet hat, um Account-Netzwerke zu unterdrücken, die es für schädlich hält, wie z. B. bei Accounts, die die Delegitimierung der Wahlen in den USA nach dem Aufstand im Kapitol am 6. Januar propagierten.

Wie andere Plattformen auch, bittet Instagram nach eigenen Angaben seine Nutzer um Hilfe bei der Erkennung von Konten, die gegen die Regeln verstoßen. Aber diese Bemühungen waren nicht immer effektiv.

Manchmal blieben Meldungen von Nutzern über Nacktbilder mit Kindern monatelang unbeantwortet, wie eine Auswertung zahlreicher Meldungen ergab, die im letzten Jahr von zahlreichen Kinderschutzorganisationen eingereicht wurden.

Anfang dieses Jahres entdeckte ein Anti-Pädophilie-Aktivist ein Instagram-Konto, das angeblich einem Mädchen gehörte, das minderjährige sexuelle Inhalte verkaufte, darunter einen Beitrag, in dem es hieß: "Dieser Teenager ist bereit für euch Perverse". Als der Aktivist das Konto meldete, antwortete Instagram mit einer automatischen Nachricht, die besagte: "Aufgrund der hohen Anzahl an Meldungen, die wir erhalten, war unser Team nicht in der Lage, diesen Beitrag zu überprüfen."

Nachdem dieselbe Aktivistin einen weiteren Beitrag gemeldet hatte, der ein spärlich bekleidetes junges Mädchen mit einer grafisch sexuellen Bildunterschrift zeigte, antwortete Instagram: "Unser Überprüfungsteam hat festgestellt, dass der Beitrag [des Kontos] nicht gegen unsere Gemeinschaftsrichtlinien verstößt. Die Antwort schlug dem Nutzer vor, das Konto zu verstecken, um den Inhalt nicht zu sehen.

Ein Meta-Sprecher bestätigte, dass Meta die Berichte erhalten und nicht darauf reagiert hatte. Eine Überprüfung der Art und Weise, wie das Unternehmen mit Berichten über sexuellen Kindesmissbrauch umging, ergab, dass ein Softwarefehler die Bearbeitung eines Großteils der Nutzerberichte verhinderte und dass das Moderationspersonal des Unternehmens die Regeln der Plattform nicht richtig durchsetzte, so der Sprecher. Das Unternehmen teilte mit, dass es den Fehler in seinem Meldesystem inzwischen behoben hat und neue Schulungen für seine Moderatoren anbietet.

Selbst wenn Instagram Konten, die minderjährige sexuelle Inhalte verkaufen, entfernt, bleiben sie nicht immer verschwunden.

Nach den internen Richtlinien der Plattform werden Strafen für Verstöße gegen die Gemeinschaftsstandards in der Regel für Konten verhängt, nicht für Nutzer oder Geräte. Da Instagram seinen Nutzern erlaubt, mehrere verknüpfte Konten zu führen, macht es das System leicht, sich einer sinnvollen Durchsetzung zu entziehen. Nutzer führen regelmäßig die Handles von "Backup"-Konten in ihren Biografien auf, so dass sie einfach wieder an dieselbe Gruppe von Followern posten können, wenn Instagram sie entfernt.

In einigen Fällen unterlaufen die Empfehlungssysteme von Instagram direkt die Bemühungen der eigenen Sicherheitsmitarbeiter. Nachdem das Unternehmen beschlossen hatte, gegen Links von einem bestimmten verschlüsselten Dateitransferdienst vorzugehen, der für die Übertragung von kindersexuellen Inhalten berüchtigt ist, blockierte Instagram die Suche nach seinem Namen.

Die KI-gesteuerten Hashtag-Vorschläge von Instagram haben die Nachricht nicht erhalten. Obwohl sie sich weigerte, Ergebnisse für den Namen des Dienstes anzuzeigen, empfahl die Autofill-Funktion der Plattform den Nutzern, Variationen des Namens mit den Worten "boys" und "CP" am Ende zu versuchen.

Das Unternehmen versuchte, diese Hashtags in seiner Antwort auf die Anfragen des Journals zu deaktivieren. Doch innerhalb weniger Tage empfahl Instagram wieder neue Variationen des Namens des Dienstes, die ebenfalls zu Konten führten, die angeblich minderjährige sexuelle Inhalte verkauften.

Nachdem das Unternehmen die Konten, auf die es durch Stanford und das Journal aufmerksam gemacht wurde, zunächst gesäubert hatte, überprüfte Levine von UMass einige der verbleibenden Konten von Verkäufern minderjähriger Inhalte auf Instagram. Wie zuvor führte das Betrachten auch nur eines dieser Konten dazu, dass Instagram neue Konten empfahl. Die Vorschläge von Instagram trugen dazu bei, das Netzwerk wieder aufzubauen, das das Sicherheitspersonal der Plattform selbst gerade zu zerschlagen versuchte.

Ein Meta-Sprecher sagte, dass die Systeme zur Verhinderung solcher Empfehlungen derzeit aufgebaut werden. Levine bezeichnete die Rolle von Instagram bei der Förderung pädophiler Inhalte und Konten als inakzeptabel.

"Ziehen Sie die Notbremse", sagte er. "Sind die wirtschaftlichen Vorteile den Schaden für diese Kinder wert?"

Quelle:

In einer Zeit systematischer „Big-Tech“-Zensur und weit verbreiteter institutioneller Korruption sind wahrheitssuchende Medien und alternative Sichtweisen von entscheidender Bedeutung, und Jede Art von Unterstützung hilft mehr, als Sie denken!

Hier kannst du den Kanal unterstützen:

👉🏻 KLICK

❤️ Vielen Dank ❤️

Satanische Blutlinien: Staatsbankett oder Familientreffen?!

Krisenvorsorge - Für Krisen & Notfälle vorsorgen

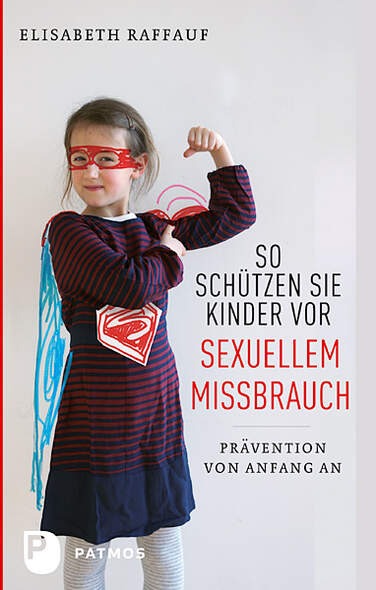

Empfohlene Lektüre:

*Bücher, die Dir die Augen öffnen

Empfohlene Artikel:

Jan van Helsing im Interview mit Daniel Prinz: Blackout, Finanzcrash und Dritter Weltkrieg

Tipps zur Vorbereitung: Überleben bei begrenztem Wasservorrat

Alois Irlmaier - 3. Weltkrieg - Ukraine - Russland - Nato

Diese natürlichen Substanzen NEUTRALISIEREN die Spike-Proteine der Covid-Impfstoffe

Insider warnt: HAARP wird "biblische Katastrophen" verursachen und eine "neue Weltordnung" einführen

Enthüllung Teil 1-3

Enthüllung Teil 1: CORONA (IMPFUNG) – Die synthetische Weiterentwicklung von BORRELIOSE?!

Enthüllung Teil 2: Die unheimlichen Experimente auf der deutschen Insel des Todes

Enthüllung (Teil 3): Babylon Berlin – Die WHO als neue Weltregierung in der NWO

Vitamin D beugt Diabetes vor: STUDIE

Folgendes passiert, wenn das Stromnetz ausfällt (plus Tipps zum Überleben)

WEF-Insider gibt zu, dass der Zusammenbruch der Silicon-Valley-Bank ein "Great Reset Scam" ist

Mehr kostenfreie Infos und Enthüllungen:

👉🏻 https://t.me/antiilluminaten

Abonniere hier meinen Notfallkanal:

🆘 https://t.me/antiilluminaten2

*Wenn ihr über diesen Link etwas kauft, entstehen euch natürlich keine zusätzlichen Kosten, ihr unterstützt dadurch meine Arbeit sehr!

♥Vielen Dank♥