El nanomundo en tus manos

2. Nanociencia y nanotecnología

Página 6 de 22

Toda la diversidad de los seres vivos está generada combinando unos pocos tipos de átomos. Lo importante es colocarlos de una manera determinada. Por tanto, imaginemos que quisiéramos emular a la vida y construir un organismo vivo en el laboratorio.

Lo más difícil no sería escoger los ingredientes adecuados. Por ejemplo, para fabricar un cuerpo humano se necesita disponer de 60 kg de agua, 20 kg de aminoácidos, unos pocos kilogramos de azúcares, lípidos y otras moléculas orgánicas, y unos 300 gramos de iones como sodio, potasio o hierro. En total, podríamos comprar todos los constituyentes moleculares de un ser humano por unos 1200 euros. El problema reside en saber cómo ensamblar cada uno de los átomos y moléculas que forman una persona o, más sencillo todavía, en cómo fabricar una primera célula gameto colocando sus constituyentes moleculares de la forma adecuada, a semejanza de un enorme puzle en el que cada pieza es una molécula. Ahora bien, si quisiésemos ponernos manos a la obra, enseguida nos encontraríamos con al menos dos dificultades. La primera, que son muchas las piezas que debemos ensamblar y la segunda, que no disponemos de herramientas que nos permitan manipularlas en tiempos razonables. Éstas son dos de las limitaciones que, mediante el uso de nuevas metodologías de fabricación ascendente (bottom-up), tenemos que superar para que la nanotecnología funcione, incluso con objetivos mucho menos ambiciosos que sintetizar un ser vivo molécula a molécula.

2.5. Seis preceptos para hacer el camino

Para conseguir ensamblar sistemas complejos, como podría ser un nuevo tipo de transistor fabricado con moléculas orgánicas, necesitamos primero entender cómo funcionan las moléculas en el mundo nanométrico: cuáles son las leyes de la naturaleza o los mecanismos físico-químicos relevantes por las que se rigen. Descubrirlos ha sido, y sigue siendo, trabajo de la nanociencia. Pero esto no acaba aquí. Una vez conseguido, tenemos que ser capaces de construir algo basado en ese conocimiento, es decir, avanzar hacia la nanotecnología. Para que la revolución «nano» pueda acontecer, las ideas deben atravesar la barrera del tamaño. El verdadero reto es traducir toda esa información que la ciencia nos suministra sobre la nanoescala, a 10−9 metros, para construir una tecnología que funcione en nuestro mundo métrico. Ahora podemos ver más clara la diferencia entre nanociencia y nanotecnología. La primera nos enseña cómo funciona el mundo «allá abajo» y la segunda nos permite construir aparatos u objetos que tengan nuestro tamaño y puedan interaccionar con nosotros «aquí arriba». Esta idea es tan fascinante que la ciencia ficción se ha apoderado del campo hace ya muchos años, sugiriendo un sinfín de nuevas e imaginativas posibilidades; un mundo lleno de nanorrobots, nanomáquinas, nanodispositivos o nanosubmarinos propuestos desde la ingeniería y que muy probablemente no existirán nunca. Por desgracia, como se comenta en el Capítulo 8, estos objetos soñados por los autores de novelas, películas, cómics y videojuegos se han convertido en la imagen más extendida que la sociedad tiene sobre la nanotecnología.

La verdadera estrategia para que se pueda desarrollar nanotecnología a partir de los descubrimientos básicos de la nanociencia emana de un conocimiento profundo de las leyes de la física y la química. Todavía no existen muchos procedimientos contrastados para ensamblar materiales o construir nuevos objetos desde sus componentes más elementales, pero algunas ideas de cómo y cuáles deben de ser estas estrategias están claras. Podemos exponerlas como un «sexálogo» de principios que nos permitan encontrar auténticas soluciones nanotecnológicas y que nos ayuden, por tanto, a pasar de la ciencia a la tecnología.

El primer precepto es construir de manera ascendente, es decir, uniendo de la manera adecuada cada uno de sus ladrillos constituyentes para formar el nanobjeto que busquemos fabricar, como ya hemos explicado. Un anexo de este precepto es evitar la construcción en serie. No podemos construir el puzle como lo haríamos nosotros, una pieza tras otra, pues una cadena de producción en serie a nivel molecular o atómico sería inabordable debido al elevado número de piezas. Así por ejemplo, para construir la Figura 1.1 que, recordemos, estaba formada por únicamente diez moléculas, se necesitaron dos horas, y eso una vez que todo el experimento estaba ya optimizado. Si consiguiésemos ser muy eficientes y tardásemos, por ejemplo, un segundo por molécula, tardaríamos once días completos para colocar un millón de ellas, que todavía son muy pocas si lo que se desea es construir un dispositivo. Una estrategia alternativa, y mucho más inteligente, sería utilizar las leyes químicas, intrínsecas a las propias moléculas, para que ellas mismas hagan el trabajo y se autoordenen o autoensamblen sin nuestra intervención directa, aunque de la forma que nosotros deseemos.

El segundo precepto es el de la cooperación y está basado en la unión de los esfuerzos individuales de cada nanodispositivo para generar un efecto resultante global. Recordemos que el producto final generado debe funcionar en nuestro mundo macroscópico. Imaginemos que conseguimos colocar sobre una superficie unas moléculas capaces de rotar a modo de motores o engranajes dentados. La fuerza individual de cada una de ellas sería pequeñísima y por tanto inútil en nuestro mundo. Otro ejemplo, los cuellos de algunos virus son nanomotores moleculares que utilizan éstos para empaquetar el genoma ejerciendo fuerzas del orden de piconewtons. Estas fuerzas son muy elevadas en el mundo «nano», pero resultan insignificantes en el nuestro. Sólo si lográsemos disponer de millones de estos motores trabajando colectivamente y de la misma manera, al unísono, sus esfuerzos se sumarían y podríamos disponer de máquinas operativas en nuestro mundo. Tales movimientos colectivos o, mejor, cooperativos, son un concepto importante que muy pocas veces es discutido en los trabajos publicados por los especialistas en este campo. Este precepto está relacionado con la necesidad de conocer los métodos de integración e interconexión de nanodispositivos en estructuras de mayor tamaño.

El tercero de los preceptos para trabajar en nanotecnología es el de la simplicidad. En efecto, buscar estrategias muy complejas para crear nuevos dispositivos es inoperante y normalmente estos diseños no dan resultado. Lo ideal es simplificar el problema y quedarnos con lo verdaderamente esencial, con las leyes mínimas necesarias para que funcione. En este sentido, observar la naturaleza también supone una ayuda y fuente de inspiración.

El cuarto precepto es el de la originalidad. Es decir, hemos de buscar soluciones diferentes, evitando copiar ideas que ya existen en nuestro mundo macroscópico, simplemente reduciendo sus dimensiones hasta el tamaño nanométrico. Una aproximación desde la ingeniería consistiría en pensar que podemos fabricar robots como los que existen en las películas de ciencia ficción, pero de tamaño pequeñísimo. Este planteamiento se olvida de uno de los principios fundamentales de la propia ingeniería: el volumen de un objeto escala con su longitud elevada al cubo y la superficie con la longitud al cuadrado. Veamos un par de ejemplos tomados de la biología, donde se conoce como «alometría» al conjunto de leyes que estudian los cambios de dimensión relativa de las partes corporales de un ser vivo en relación con los cambios en su tamaño total. ¿Una hormiga tendría la misma forma si su cuerpo midiese un metro en lugar de un centímetro? Sin duda su morfología sería muy distinta ya que, por ejemplo, necesitaría disponer de unas patas que soportasen el enorme aumento de su peso. ¿Podríamos encontrarnos con un gorila del tamaño de King Kong? Evidentemente no, entre otras cosas porque moriría colapsado por su peso y además se asfixiaría ya que sus pulmones no tendrían capacidad suficiente para enviar aire a todo su cuerpo. Volviendo al ámbito de los materiales, hay magnitudes que dependen de su volumen (como el peso o la resistencia mecánica) y otras de la superficie (como el transporte eléctrico) y, por tanto, no podemos escalar directamente un objeto y esperar que funcione como el original. Por ejemplo, si quisiéramos transportar medicinas por la sangre, no deberíamos construir un nanosubmarino utilizando el mismo tipo de piezas e instrumentación que en el mundo macroscópico, aunque pudiéramos reducirlas hasta el tamaño deseado. Además de contradecir los preceptos primero y tercero que acabamos de plantear, dicho nanosubmarino no aguantaría la presión a la que estaría sometido en el torrente sanguíneo. La solución debe ser completamente distinta a la que nos mostró el cine en la película Viaje alucinante. Por ejemplo, podríamos recubrir una nanopartícula con biomoléculas para que el organismo no la identifique como intrusa y, a la vez, hacer que transporte un medicamento en su superficie. O bien utilizaríamos la cápsida de un virus, desprovisto de su genoma, como nanotransportador. Estas soluciones son mucho más simples y económicas, y es más probable que den buen resultado, como de hecho ya se está comprobando.

El quinto precepto es la interdisciplinariedad. La nanotecnología requiere el uso de una nueva y muy compleja instrumentación y, por tanto, la necesidad de combinar expertos en distintas técnicas y áreas científico-técnicas. Hoy en día la división vertical del conocimiento en disciplinas compartimentadas (como la física, la química, la biología o la ingeniería) está llegando a su fin y se debe tender a una formación horizontal e interdisciplinar. Pongamos como ejemplo un biólogo que quiere construir un motor molecular basándose en el que poseen algunos virus. Para ello, deberá conocer técnicas de imagen y manipulación propias de la física, y también entender las interacciones moleculares que rigen la química del sistema. Finalmente, para construir un dispositivo funcional tendrá que manejar conceptos de ingeniería. Así pues, el desarrollo de la nanotecnología requiere no sólo la utilización de técnicas de fabricación, visualización y caracterización muy precisas, sino también una aproximación multidisciplinar que reúna a físicos, químicos, biólogos, tecnólogos y teóricos trabajando juntos y utilizando el mismo lenguaje. De esta manera el nanotecnólogo deberá, en cierto modo, comportarse como un hombre del Renacimiento, que no sólo dibujaba o pintaba, también escribía novelas, ensayos o diseñaba nuevos aparatos. Sin embargo, y a diferencia de lo que ocurría en aquella época, hoy en día el grado de especialización para fabricar dispositivos nanotecnológicos es tan elevado que resulta muy difícil aunar en una misma persona las nociones científico-técnicas de varias áreas del conocimiento que son necesarias. Este problema puede soslayarse formando equipos de trabajo interdisciplinares, donde los conocimientos de una persona se complementen con los de otra.

El sexto y último precepto, ya comentado con anterioridad, es la observación de la naturaleza. Se ha dicho en muchas ocasiones que la vida es la musa de la nanotecnología, pues es el único sistema conocido que funciona utilizando exclusivamente los preceptos de ésta. Existen muchos ejemplos de cómo imitar a la naturaleza para producir nuevos dispositivos, como podrían ser los motores moleculares. Para ello podríamos fijarnos en la kinesina, una molécula que, como ya hemos visto, transporta macromoléculas desde un punto a otro de la célula dando pequeños «pasos» nanométricos sobre un microtúbulo (ver Figura 6.6). Esos pasos se realizan transformando la energía química que se libera al degradar una molécula, llamada ATP, en energía mecánica.

No obstante, conviene hacer una precisión importante a este precepto. La biología ha optimizado el camino para construir seres vivos desde planteamientos que podemos considerar nanotecnológicos después de miles de millones de años de evolución. Para encontrarlo ha probado cientos de miles de rutas posibles mediante el método de prueba y error, sin un diseño previo ni una finalidad preestablecida. Los resultados de esa diversidad de soluciones se han ido adaptando, por selección natural, a las condiciones ambientales concretas. Muchas de ellas no han funcionado y por tanto se han extinguido, mientras que otras han perdurado y evolucionado. Pero, como hemos apuntado, esta solución no tiene por qué ser única. La evolución podría haber seguido muchas trayectorias alternativas, aunque sabemos que los seres vivos que constituyen la biodiversidad que nos rodea están aquí porque «funcionan suficientemente bien». Puede que haya otras que, aunque nunca se hayan explorado ni optimizado, sean viables. Nosotros, aunque nos inspiremos en las soluciones naturales, podemos explorar rutas diferentes a las existentes que nos permitan construir otro tipo de dispositivos. Solo tenemos que mantener la mente suficientemente abierta como para saber encontrarlas.

Una vez repasados estos seis preceptos, es evidente que a día de hoy tenemos muy pocos ejemplos (o quizá ninguno) de nueva tecnología que funcione siguiéndolos todos a la vez. Las aplicaciones disponibles utilizan alguna de estas ideas pero estamos todavía lejos de poder construir tecnología sofisticada basada exclusivamente en estos principios. Tal vez el campo donde más se apliquen sea en temas relacionados con la salud y la medicina, donde actualmente se están probando nuevas terapias basadas en nanotecnología y, por tanto, estarán disponibles para la sociedad en algo menos de diez años. La transición desde la nanociencia a la nanotecnología es un campo abierto y fascinante, que constituye una de las áreas de estudio más atractivas para jóvenes motivados.

Una pregunta que nos hacemos para finalizar este apartado es si estarán listas las administraciones, instituciones y empresas para implementar y valorar las actuaciones que requiere la implantación de la nanotecnología. Por ejemplo, el precepto de interdisciplinariedad choca de frente con la formación tan especializada que se imparte en nuestras universidades, así como con el encajonamiento de los proyectos de investigación. Un proyecto en la frontera entre la física y la biología es normalmente mal evaluado por ambas áreas y, de igual manera, proyectos a largo plazo o de riesgo elevado por la novedad de las ideas son difícilmente financiados ya que se catalogan como sueños irrealizables. El lector podrá comprobar dentro de diez años si las administraciones dentro y fuera de España han ayudado a dar el paso desde la nanociencia a la nanotecnología y si los científicos han tenido la valentía e imaginación para dar ese salto. Por otra parte, no podemos olvidar que la mayor parte de los métodos de fabricación que se utilizan en las empresas son aún descendentes y existe un inercia natural para seguir usándolos. El paso hacia aproximaciones más radicales, como podría ser la implementación de mecanismos de autoensamblado o ascendentes, es difícil de introducir en los procesos de producción. Nuevamente se requiere valentía y alto riesgo, pero esta vez desde el ámbito empresarial.

2.6. Las bases del mundo «nano»: el pasado

La nanotecnología no es una disciplina cerrada que haya sido postulada por uno o varios científicos en un momento dado. Es más bien el resultado de un cúmulo de ideas y conceptos que han surgido a lo largo del último siglo y se han ido perfilando principalmente durante las dos últimas décadas. Esto hace que su historia sea tan apasionante como difícil de contar.

Podríamos decir que la historia del mundo «nano» comienza con el modelo atómico y la mecánica cuántica, otra verdadera revolución sobre el conocimiento de la materia. Fue en esa época, en los años veinte, cuando se sentaron las bases para describir los átomos y moléculas, los ladrillos de la nanotecnología. Sin embargo, parece demasiado oportunista remontarse tan atrás en el tiempo y, por tanto, situaremos el origen de la nanociencia en el momento en que se comenzaron a discutir las ideas de fabricación ascendente.

Parece claro que la primera persona que habló de fabricación ascendente, «uniendo ladrillo a ladrillo», y por tanto de la nanotecnología tal como la entendemos hoy en día (aunque sin pronunciar esta palabra) fue Richard Feynman, científico norteamericano que ganó el Premio Nobel de Física en 1965 por sus aportaciones a la física de partículas, un campo que no tiene nada que ver con la nanotecnología. Feynman tuvo una vida profesional y personal muy variada: participó en el proyecto Manhattan para la construcción de la bomba atómica durante la Segunda Guerra Mundial, fue un gran divulgador de la ciencia, y casi al final de su vida formó parte de la comisión para la investigación del accidente del transbordador espacial Challenger. Fue en 1959, años antes de ganar el Premio Nobel, cuando pronunció una conferencia en el Instituto de Tecnología de California que versó sobre el problema de la manipulación de objetos a pequeña escala. En ella afirmó que podría haber muchas oportunidades tecnológicas «jugando» con átomos y moléculas. Concluyó que no había ninguna ley física que lo prohibiese y que, por tanto, conseguirlo era solo una cuestión de tiempo, el necesario para que se inventasen las herramientas adecuadas. De él es la famosa frase que se utiliza habitualmente como un símbolo de la nanotecnología: «there is plenty of room at the bottom» («hay mucho espacio libre al fondo»). En aquel momento su discurso no tuvo una gran repercusión, pero hoy en día resulta asombroso comprobar cómo se han cumplido sus predicciones.

Sin embargo, Feynman no trabajó nunca en esta nueva disciplina, ni siquiera conoció su nombre, ya que el término «nanotecnología» lo introdujo por primera vez el profesor N. Taniguchi de la Universidad de Ciencia de Tokio en un artículo titulado «On the Basic Concept of “Nanotechnology”» en 1974, que se presentó en una conferencia de la Sociedad Japonesa de Ingeniería de Precisión. En dicho artículo se hablaba de la nanotecnología como la tecnología que nos permitiría separar, consolidar y deformar materiales átomo a átomo o molécula a molécula.

Estas ideas fueron publicadas a mediados de los años setenta pero nadie pensó cómo podrían materializarse, es decir, de qué forma podría construirse algún material o dispositivo desde sus constituyentes más elementales. Se requirió más de una década para que en 1986 Eric Drexler publicase un libro titulado Engines of Creation en el que describía cómo las nanomáquinas podrían ser capaces de construir, de manera autónoma, desde ordenadores hasta maquinaria pesada, ensamblando molécula a molécula. Para Drexler los encargados de realizar esa labor de montaje serían nanorrobots ensambladores, con un funcionamiento parecido al que desde siempre han realizado los ribosomas y otros agregados moleculares en las células de nuestro cuerpo. Estos nanorrobots, además, serían capaces de construirse a sí mismos y autorepararse cuando fuese necesario. La descripción realizada por Drexler se corresponde con el funcionamiento de los motores moleculares, en los que la naturaleza ha generado un engranaje de moléculas de manera tal que unas hacen moverse a otras, lográndose un verdadero efecto mecánico. Drexler también vislumbró la posibilidad de desarrollar nanosubmarinos que podrían desplazarse por las venas buscando antígenos, como hacen los leucocitos.

Esta visión mecánica de la nanotecnología, en la que los nanorrobots ensambladores moleculares son los encargados de crear nuevos dispositivos a partir de átomos y moléculas, fue duramente rebatida por R. E. Smalley, científico conocido por el descubrimiento de una importante molécula en nanociencia, el fullereno, lo que le valió el Premio Nobel de Química en 1996. En el año 2001 Smalley publicó un artículo en la revista Scientific American (en España, Investigación y Ciencia, septiembre 2001) titulado «Química, amor y nanorrobots» («Of Chemistry, Love and Nanobots») en el que acusaba a Drexler de proponer modelos incompatibles con las leyes fundamentales de la química. Además, le culpaba de generar un ambiente apocalíptico que podía predisponer al gran público contra el nacimiento real de la nanotecnología. Este último punto se ha cumplido pues, como indicábamos en el Capítulo 1, personajes tan mediáticos como el príncipe Carlos de Inglaterra han alertado sobre un posible ataque futuro de nanorrobots descontrolados. Smalley criticaba las ideas de Drexler con un bonito ejemplo. Cuando dos personas se enamoran se suele decir que entre ellos hay buena química, pero para que surja el amor no basta simplemente con que ambos se pongan en contacto. Sin embargo, cuando ha surgido esta «química», la atracción es tan fuerte que no hay quien pueda separarlos. No les vale otra persona, tiene que ser el objeto de su amor y si pudiesen permanecerían juntos hasta el final. Esto mismo les pasaría a los átomos que constituyen el robot ensamblador: si quisiesen colocar a otros átomos para formar un dispositivo, bien los ignorarían, porque «no hay química», o bien se unirían a ellos en una reacción tan fuerte que los inutilizaría para continuar buscando o moviendo otros. Ésta es la teoría conocida con el nombre de «dedos pegajosos». La respuesta de Drexler no se hizo esperar y junto con otros nanotecnólogos como R. Freitas contraatacó a Smalley, haciéndole saber que los ribosomas hacen este mismo trabajo y no sufren la enfermedad de los «dedos pegajosos». Este debate siguió en varios medios y revistas científicas mediante el intercambio de cartas abiertas y no acabó con un vencedor claro.

Hoy en día, con el tiempo, el punto de vista de los científicos que trabajan en el tema es más cercano al de Smalley que al de Drexler. Por nuestra parte, podríamos argumentar que los engranajes ensambladores moleculares de Drexler no cumplen con casi ninguno de los preceptos expuestos en el apartado anterior. Ni son simples, ni trabajan de forma colectiva y, además, son una copia a escala reducida de los motores actuales. En definitiva, a través de las páginas de Engines of Creation, nos hace soñar con objetos imaginados, de la misma manera que Julio Verne hizo soñar a nuestros abuelos con viajes a la Luna o al centro de la Tierra. El hombre finalmente pisó la Luna pero nunca llegó (ni llegará) al centro de la Tierra. De igual manera, es muy probable que casi ninguno de los objetos descritos y patentados por Drexler entren a formar parte de nuestras vidas y pasarán a la historia como una mera imaginación o especulación.

Sin embargo, el verdadero valor de los trabajos de Drexler fue el de proporcionarnos imágenes mentales del nanomundo, aunque hasta entonces seguía sin haber forma de acercarse a él. En el mismo año que Drexler publicó su libro, 1986, dos investigadores, G. Binnig y H. Rohrer, de los que hablamos al principio de este capítulo, recibieron el Premio Nobel de Física por la invención del llamado microscopio de efecto túnel (STM, del inglés Scanning Tunneling Microscope), una herramienta simple que nos permitió ver realmente cómo eran los objetos en la nanoescala. También en este mismo año surgió una variante del STM bautizada como microscopio de fuerzas atómicas (AFM, del inglés, Atomic Force Microscope). Estos dos tipos de microscopios supusieron una forma nueva de mirar al mundo nanométrico: habían nacido «los ojos de la nanotecnología». Estas técnicas, como se verá en el próximo capítulo, se basan en la suave interacción entre una punta afiladísima y una superficie. La punta, que puede llegar a acabar en un solo átomo, se «pasea» por encima de una superficie «sintiendo» sus átomos de forma similar a cuando se pasa un dedo por el teclado de un ordenador (ver Figura 2.6) o sobre un texto escrito en lenguaje Braille. STM y AFM, junto con alguna otra variante que surgió en los años noventa, se conocen hoy en día como microscopios de campo cercano (SPM, del inglés, Scanning Probe Microscope).

El trabajo con objetos tan pequeños entraña una gran dificultad y, de hecho, fue algo prácticamente imposible hasta que se desarrollaron los microscopios de campo cercano. Estas novedosas herramientas permiten hoy en día no sólo la visualización de moléculas, átomos u otros objetos de tamaño nanométrico, sino también su manipulación. Mediante su uso en determinadas condiciones podemos mover a nuestro antojo átomos, moléculas inorgánicas u orgánicas, proteínas, fragmentos de ADN, ribosomas, fullerenos, nanotubos, nanopartículas y un largo etcétera. Aunque quizá no parezca que ésta sea una labor tan asombrosa, tenemos que darnos cuenta de lo que significa en realidad ver o manipular entidades tan pequeñas como un átomo. Comenzábamos este capítulo con la inquietud y el asombro de un veterano investigador francés ante una técnica capaz de mostrarle cómo son realmente los átomos. De hecho, era común en los años ochenta, cuando se estudiaba bachillerato, que un profesor de física enseñara: «los átomos ni se ven, ni se podrán nunca llegar a ver». Para estos profesores, ver un átomo suponía irradiarlo, bombardearlo con electrones, con fotones o con otros átomos. Por tanto, nunca sería posible ver un átomo en su estado natural, sino un átomo modificado por la interacción con las partículas (sondas) que se le envían. Sin embargo, no se imaginaban que mientras ellos explicaban física desde las aulas, otros científicos estaban desarrollando un tipo de microscopio que no necesita irradiar la materia, sino que simplemente detecta la nube de electrones que rodea a un material, gracias a una propiedad cuántica llamada «efecto túnel».

FIGURA 2.6.

A la izquierda, analogía del funcionamiento de un microscopio de campo cercano o SPM: una afiladísima punta se pasea sobre una superficie sin prácticamente tocarla, como podemos hacer con el dedo sobre el teclado de un ordenador. A la derecha, fotografía obtenida con un microscopio electrónico de barrido de una punta de tungsteno utilizada para realizar imágenes con un STM.

Las microscopías de campo cercano se perfeccionaron enormemente durante los años noventa, junto con las técnicas de cálculo numérico, que permitían simular y comprender muchos de los experimentos que se realizaban en los laboratorios. En la última década del siglo XX y principios del XXI se dieron varios pasos importantes que perfilaron la nanociencia y nanotecnología como las conocemos hoy en día. En esta década se descubrieron los fullerenos, las nanopartículas, los nanotubos de carbono y el grafeno. Estos nuevos tipos de materiales despertaron un fervor inusitado ya que acercaban las ideas «nano» a las aplicaciones tecnológicas. Al mismo tiempo, las administraciones, conscientes de la potencialidad de esta nueva ciencia y de las posibles repercusiones en la sociedad, crearon algunos programas de investigación para fomentar los trabajos en nanociencia y nanotecnología, ayudando a convertir estas palabras en la realidad que son actualmente.

Por otra parte, hace algunos años comenzó a hablarse de bionanotecnología y bionanomedicina, áreas que muy pronto se han convertido en campos muy pujantes dentro del mundo «nano». En gran parte, el auge es debido al fuerte desarrollo del AFM, técnica que permitió obtener imágenes de alta calidad del delicado material biológico en medio líquido. La estructura de bacterias, virus o biomoléculas cambia según el medio en el que se encuentren y en la mayor parte de los casos se deforma irremediablemente en el aire. Con esta herramienta es posible ver e interaccionar con distintas estructuras biológicas dentro de su propio medio, lo que supone una gran ventaja respecto de los microscopios electrónicos, que son muy dañinos para la materia blanda y deben operar en condiciones de vacío.

Otro avance importante llevado a cabo durante los últimos años ha sido la mejora de las técnicas de fabricación y caracterización de materiales. Así, se han desarrollado grandes equipos de fabricación descendente de uso compartido, englobados en lo que se han llamado plataformas de usuarios. Estos equipos, aunque de tecnología descendente, han logrado producir haces de electrones o iones de pocos nanómetros de diámetro, que pueden ser utilizados, por ejemplo, para crear y visualizar estructuras donde posteriormente ensamblar, de manera ascendente, distintos nanobjetos.

En definitiva, desde que Feynman y Taniguchi sentaron las bases teóricas de la nanotecnología, ha habido un fuerte desarrollo experimental en los laboratorios. La combinación de técnicas de microscopía con nuevos sistemas de fabricación y de caracterización ha hecho que la síntesis y el uso de los materiales «nano» hayan crecido exponencialmente. Muchos centros de investigación han partido de estas ideas para diseñar no tanto dispositivos concretos, sino experimentos que demuestren las posibilidades para desarrollar esa «nueva» tecnología. Esto ha desembocado en la puesta a punto de diferentes programas de investigación, así como de diversas iniciativas para fomentar que los conocimientos generados por la ciencia tengan una traducción en la tecnología, y generen a corto plazo aplicaciones reales que puedan mejorar la calidad de vida de la sociedad. Algunas de ellas se describen en el apartado siguiente.

2.7. Áreas de estudio y aplicación: el presente

En las siguientes líneas, y a modo de breve resumen, expondremos algunas de las áreas de estudio y aplicación de la nanociencia y la nanotecnología que se desarrollarán en detalle en los capítulos siguientes. Sin embargo, debemos dejar claro que ninguna de estas áreas corresponde a un campo cerrado y muchas veces la clasificación es un tanto caprichosa o artificial. El «precepto» de interdisciplinariedad es particularmente válido en este caso y hace que un mismo nanobjeto pueda estudiarse desde varias áreas de especialización. Un ejemplo de esta dificultad son las nanopartículas. Veremos que tanto los químicos como los físicos pueden fabricarlas (cada uno con unas herramientas diferentes) con una precisión asombrosa en su tamaño y forma. Los químicos y biólogos las usan como sensores, los médicos como elementos para la detección precoz de enfermedades o para diversas terapias y algunos ingenieros estudian su uso como materiales para el almacenamiento de información o para reforzar estructuras mecánicas. En cualquier caso, parece claro que el uso de las nanopartículas requerirá el esfuerzo combinado de científicos que las fabriquen, otros que definan su utilización en un dispositivo o en un entorno dado e ingenieros que finalmente escalen el proceso hacia una producción en masa. Otro ejemplo donde queda patente la interdisciplinariedad es el de los biosensores. Un diabético sería feliz si tuviese insertado un pequeño dispositivo que midiese de manera continua la concentración de glucosa en su sangre y que en caso necesario liberase la cantidad correspondiente de insulina. La fabricación de un dispositivo de estas características se consigue mediante la utilización combinada de distintas técnicas químicas que permiten inmovilizar sobre una superficie una biomolécula capaz de detectar la presencia de glucosa. Pero para operar con dicho biosensor necesitaremos utilizar métodos químico-físicos que nos permitan saber si la biomolécula depositada en la superficie no ha perdido su capacidad de reconocimiento de la glucosa durante el proceso de inmovilización sobre la superficie, técnicas bioquímicas para trabajar en medio biológico, herramientas de ingeniería para construir un dispositivo utilizable y biocompatible, y criterios médicos para probarlo en pacientes.

Veremos que el desarrollo de la nanotecnología ha venido de la mano de las nuevas «nanoherramientas» (Capítulo 3). Por ellas entendemos novedosas técnicas tanto de producción de nanobjetos como de caracterización de los mismos. Las altas prestaciones de las nuevas técnicas microscópicas para visualizar y manipular la materia, así como la potencia de las técnicas espectroscópicas y electroquímicas actuales para detectar pequeñas concentraciones de un determinado compuesto han sido clave para describir infinidad de procesos que ocurren en la nanoescala.

Los nuevos nanomateriales (Capítulo 4), entre los que destacan los basados en carbono, prometen numerosas aplicaciones en nuestra vida cotidiana y son una de las grandes promesas para el desarrollo de la nanotecnología. Estos materiales se han desarrollado para ser utilizados en muchos campos, entre ellos la electrónica, la mecánica o la medicina. Tal vez los más prometedores sean los nanotubos de carbono y el grafeno. Los primeros son tuberías formadas únicamente por átomos de carbono enlazados entre sí y que tienen un diámetro de pocos nanómetros. Su estructura es la de un plano atómico de grafito (los átomos colocados formando hexágonos, como en un panal de abeja) enrollado sobre sí mismo. Estos tubos son seis veces más ligeros que el acero y cien veces más resistentes. Además, presentan propiedades semiconductoras o metálicas según cómo se hayan formado: si son tubos rectos presentan unas propiedades electrónicas y si están «retorcidos» (es decir, con una cierta forma helicoidal) poseen otras. Esta variedad de propiedades en un mismo material hace que se esté estudiando su uso tanto como elementos electrónicos (tipo diodos) o bien como pequeñísimos hilos conductores. Uno de los problemas que presentan para su aplicación tecnológica es la dificultad para seleccionarlos de manera controlada, de forma que todos tengan las mismas propiedades. Así, en muchos centros de investigación intentaban construir dispositivos electrónicos basados en nanotubos y para ello necesitaban que fuesen homogéneos, de la misma longitud y helicidad, y esto no parecía posible con las técnicas de síntesis disponibles en los años noventa. Para solventar este problema, en el prestigioso instituto americano de investigación Laboratorio tecnológico de Georgia para nuevos materiales electrónicos decidieron inhibir su helicidad desplegando los nanotubos en una banda formada por un solo plano atómico de carbono: una lámina de grafeno. Así, en el año 2001, este instituto comenzó a investigar sobre las propiedades electrónicas que presentan estrechas bandas bidimensionales de grafeno. De momento, todavía no se ha conseguido construir un dispositivo con las características necesarias para su comercialización, pero resulta curioso saber que el intento de construir nuevos dispositivos con nanotubos fue decisivo para el desarrollo del grafeno.

En nanoquímica (Capítulo 6) se estudian diversos procesos y mecanismos simples, como el reconocimiento molecular o la química supramolecular que, cumpliendo los preceptos que hemos descrito anteriormente, nos permiten construir nuevos tipos de nanoestructuras. Estos mecanismos se basan en utilizar las propiedades de las moléculas para que ellas mismas se organicen en estructuras más complejas capaces de desempeñar la función deseada. Por ejemplo, pueden fabricarse hoy en día láminas de moléculas orgánicas mediante autoensamblado que imiten los procesos de fotosíntesis de las plantas y desarrollar así hojas de plantas artificiales capaces de transformar la luz en energía. Sabemos que en un día soleado llegan millones de fotones por segundo a la superficie de cada hoja de un árbol y que esa energía solar se transforma en energía química gracias una molécula llamada porfirina (contenida en la clorofila, el pigmento responsable del color verde de las hojas de las plantas). Pues bien, en un laboratorio estas porfirinas pueden colocarse en forma de láminas delgadas o microtubos para realizar un proceso de fotosíntesis artificial similar al que se produce en las plantas o en las algas verdes. Si consiguiésemos optimizar y escalar la fabricación de estos materiales podríamos disponer de un sistema nanotecnológico de producción de energía que no generase contaminación. Una fuente que, nunca mejor dicho, podríamos calificar como «energía verde».

Sin duda, el campo en el que más esperanzas se han depositado es el de la nanobiotecnología y la nanomedicina (Capítulo 7), por el papel clave que esta nueva tecnología podría desempeñar en la lucha contra enfermedades de difícil curación, como el cáncer. La importancia social que puede tener el uso de nanopartículas para detectar o eliminar tumores, el empleo de carcasas de virus para transportar fármacos, el desarrollo de nuevos materiales que posibiliten implantes o la manipulación de ADN, ha ocasionado que muchos científicos vuelvan su mirada hacia este campo emergente. También se ha desarrollado mucho el campo de los biosensores y nanobiosensores, hasta llegar a niveles de integración que permiten incluso tener «un laboratorio dentro de un chip». Éstos son dispositivos de unos pocos milímetros que integran un chip capaz de analizar las concentraciones de diversos analitos como azúcares, proteínas o glóbulos rojos en volúmenes muy pequeños, del orden de unos pocos picolitros. Si llevásemos con nosotros uno de estos laboratorios portátiles, en poco tiempo podríamos hacernos un análisis completo con una simple gota de nuestra sangre. Sin embargo, a pesar de su popularidad entre los científicos, este campo sigue siendo uno de los más complejos ya que necesita la combinación de disciplinas muy diferentes. Suelen necesitarse físicos trabajando en equipo con químicos y médicos, y esta mezcla es verdaderamente difícil debido al uso de diferentes metodologías e incluso lenguajes científicos. Además, cuando la nanotecnología tiene aplicación en salud humana y farmacología debe trabajarse con un elevadísimo nivel de exigencia, disponiendo de protocolos claros de control. Ante el rigor que caracteriza el avance en estas disciplinas, resulta cuanto menos sorprendente cómo en el imaginario popular se vislumbra un futuro poblado por extraños nanosubmarinos y nanorrobots que, extraídos directamente de la ciencia ficción, se pretende que circulen por nuestras venas para curar enfermedades o convertirnos en superhumanos.

No obstante, el campo más conocido para el ciudadano y uno de los primeros que exploró la aproximación «nano» es el de la nanoelectrónica (Capítulo 5). Como ya hemos comentado, la tecnología actual ha seguido una ruta hacia la miniaturización que tarde o temprano llegará a su fin. El concepto de bit, la unidad de información, quiere reducirse lo más posible, hasta que sea tan pequeño como un átomo o una molécula individual. Además, han entrado en escena nuevos tipos de materiales que pretenden ser los sustitutos del silicio, hasta ahora el material por excelencia en el campo de la electrónica. El principal de ellos es el grafeno, que como hemos visto es una lámina bidimensional de átomos de carbono, con la que recientemente se han construido pantallas planas y los primeros prototipos de transistores. Hoy en día existe un gran interés científico por estudiar este material, mejorar su síntesis y conocer mejor sus propiedades. Éste es un buen ejemplo de cómo ciencia y tecnología se han ido apoyando y complementando en los últimos años. En este campo cabe también destacar los materiales orgánicos, con los que se pretende aportar un nuevo tipo de compuestos fotosensibles para ser utilizados como captadores de luz solar o diodos altamente eficientes en un futuro cercano.

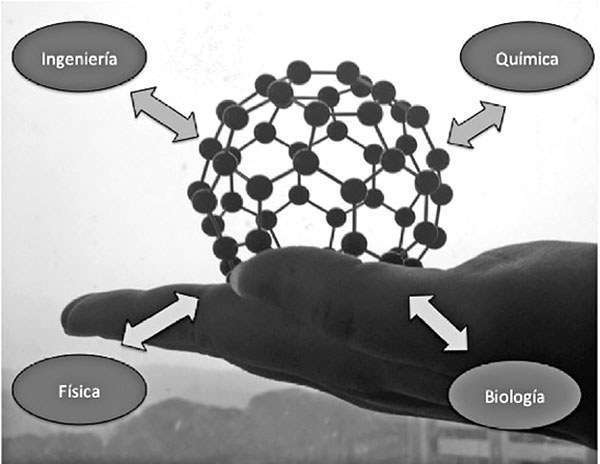

FIGURA 2.7. Sólo la combinación de diversas áreas del conocimiento podrá ayudarnos a tener el nanomundo en nuestras manos.

2.8. El camino hacia la tecnología: el futuro

La lista de campos en los que la nanotecnología intenta contribuir aportando nuevos dispositivos o materiales es muy amplia, y se extiende desde la aeronáutica hasta la cosmética pasando por ámbitos tan dispares como la construcción o la alimentación. Es, por tanto, difícil escribir sobre las aplicaciones de la nanotecnología sin quedar rápidamente desactualizado. Seguramente, antes de que se publique esta obra habrán surgido nuevas aplicaciones o productos basados en los conocimientos sobre nanociencia que este libro expone. Además, existe otra dificultad adicional a la hora de referirnos a las aplicaciones. Como hemos indicado, se abusa sin pudor del prefijo «nano» pues muchos productos fabricados convencionalmente lo añaden a su nombre como un sello de calidad o modernidad. Por tanto estas aplicaciones, aunque catalogadas como nanotecnológicas, en realidad están muy lejos de pertenecer a este campo. En este apartado revisaremos brevemente algunos de los productos más prometedores que ya están o pronto estarán en los mercados. Es importante tener en cuenta que por aplicaciones no nos referimos al prototipo de fabricación, sino al producto final que el lector podría comprar, como se expondrá con más detalle en el Capítulo 8.

Las aplicaciones derivadas de los conceptos «nano» que están disponibles actualmente son aún muy simples (cremas solares, recubrimientos protectores, equipamiento deportivo…), y raras veces cumplen los preceptos que hemos expuesto anteriormente. De hecho muchos de estos productos ya existían anteriormente y ahora simplemente se les ha dado un nuevo enfoque mejorado o más atractivo. Este tipo de aplicaciones pueden clasificarse como aplicaciones pasivas y, en todas ellas, el material nanoestructurado es utilizado por sus propiedades físicas o mecánicas para mejorar las prestaciones de otros materiales convencionales. Por ejemplo, se empiezan a comercializar camisas fabricadas con tejidos hidrofóbicos, en las que el material textil tiene una nanoestructura que hace que no se moje bajo la lluvia, que el vino no la manche o que se pueda lavar más fácilmente. Otra de las aplicaciones pasivas de gran importancia tecnológica es la fabricación de recubrimientos duros y muy delgados que, convenientemente depositados sobre una herramienta, hacen que ésta mejore sus prestaciones y durabilidad.

Podemos esperar que aplicaciones como las que hemos indicado, en las que el elemento «nano» tiene un papel completamente pasivo, vayan dando paso a productos o materiales en los que el elemento «nano» sea cada vez más activo, como pueden ser nuevos tipos de biosensores más eficientes que incluyan nanopartículas. También en esta categoría entraría la fabricación de novedosos dispositivos electrónicos, tanto de almacenamiento de información como transistores más rápidos, o instrumentos que permitan captar la energía del sol de manera más eficiente. La evolución de sistemas pasivos a activos es el camino que se está recorriendo en la actualidad y será necesario al menos acabar la presente década para que algunos de estos nuevos productos se puedan encontrar en los mercados, de forma que la nueva tecnología se instale en la sociedad.

La siguiente etapa en la senda de la implantación de la nanotecnología consiste en pasar de materiales activos a sistemas moleculares complejos, en los que se combinen varios de los que hemos denominado preceptos de la nanotecnología. Éste sería el tránsito más difícil, pero al mismo tiempo el que puede desembocar en una revolución tecnológica de mayor calado. Para dar este paso es necesario controlar las herramientas de autoensamblado de forma que nos permitan crear nuevas estructuras a medida. En este campo necesitaremos todavía más de quince años de estudio antes de conseguir los primeros prototipos de nuevos dispositivos que puedan trabajar en nuestro mundo.

Aunque al principio de este capítulo establecíamos una diferencia entre ciencia y tecnología y marcábamos una secuencia temporal entre ambas, es necesario precisar que hoy en día el tiempo que transcurre entre la aparición de un nuevo material en el laboratorio y su comercialización puede llegar a ser muy corto. Consideremos el ejemplo del grafeno, uno de los materiales más estudiados en la actualidad. Aunque su origen es natural y se conocía desde hacía varias décadas como un subproducto indeseado, fue en 2004 cuando se descubrió cómo aislarlo de manera efectiva. Se comprobó que era un material inerte, estable en aire y puramente bidimensional al estar formado por una sola lámina de átomos. Posteriormente, en el año 2010, el grupo de investigación que puso de manifiesto sus asombrosas propiedades electrónicas ganó el premio Nobel de física. En el año 2011, la empresa Samsung junto con otros grupos de investigación consiguieron un primer prototipo de una pantalla plana de grafeno de 30 pulgadas. IBM ya está investigando acerca de la formación de grafeno sobre carburo de silicio, como una forma de integrarlo fácilmente en las cadenas actuales de producción de dispositivos electrónicos. Éste es un ejemplo de la eficiencia y rapidez actual en la transferencia de conocimientos básicos al mundo tecnológico. Sin embargo, en otros sectores esta capacidad de tránsito desde el laboratorio a la producción se ve disminuida por la aplicación de una estricta normativa de seguridad que hace necesaria la realización de múltiples ensayos y controles, como ocurre en sanidad y alimentación.

Existen otros nanomateriales cuya utilización generalizada puede vislumbrarse en un futuro muy cercano. Uno de ellos son las nanopartículas, conglomerados de átomos que pueden usarse en diversos ambientes y presentan multitud de aplicaciones además de un coste muy reducido. Como hemos comentado, en el campo de la nanomedicina existen varias aplicaciones en fases avanzadas de estudio. A pesar de los problemas potenciales de toxicidad o de manipulación derivados de su pequeño tamaño, parece claro que seguirá aumentando su presencia en los mercados. Otro ejemplo son los nanotubos de carbono, que ya se utilizan como refuerzo para aplicaciones mecánicas y cada vez se avanza más en su uso en electrónica. Por último, podemos citar los materiales orgánicos para crear captadores eficientes de luz solar. Las primeras celdas solares basadas en este tipo de materiales comercializadas muy recientemente presentan valores para su eficiencia similares a los obtenidos con celdas convencionales basadas en silicio.

Pero dejemos volar la imaginación para ir un poco más allá. Imaginemos las aplicaciones que existirán en 20 o 30 años derivadas de estos conceptos. Los cambios industriales más profundos que han tenido lugar en la historia han estado ligados a la convergencia de tecnologías. Cuando dos o más disciplinas científico-técnicas interactúan entre sí pueden producir una nueva tecnología que permite avanzar de forma más rápida que con la simple suma de conocimientos de cada una de ellas por separado. En estos casos se dice que se produce sinergia entre tecnologías. Por ejemplo, de la convergencia de la electrónica y las telecomunicaciones surgió el fenómeno de la sociedad de la información, la era digital, en la que todos estamos conectados e intercambiando información de forma instantánea y global. En estos momentos asistimos a un nuevo proceso de convergencia tecnológica en el que se están aglutinando conocimientos y metodologías que provienen de la nanotecnología, la biotecnología, las omnipresentes tecnologías de la información y telecomunicaciones, y las llamadas ciencias cognitivas incluyendo las neurociencias. Esta convergencia se ha denominado «convergencia NBIC», cuyas siglas se refieren a la combinación de los prefijos «Nano», «Bio», «Info» y «Cogno». En cada una de estas ramas científico-técnicas existen unas unidades de trabajo fundamentales que son bien conocidas: en el área «nano» las unidades de trabajo son los átomos y las moléculas, en el área «bio» las unidades son los genes y las proteínas, en el área «info» la unidad son los bits y, finalmente, las neuronas son las unidades básicas del área «cogno». Como vemos, la convergencia NBIC abarca parte del macro-, micro- y nanomundo.