Как ИИ меняет войну

The Economist

Генеральный штаб с искусственным интеллектом может оказаться важнее роботов-убийц.

В конце 2021 года Королевский военно-морской флот обратился к Microsoft и Amazon Web Services, двум американским технологическим гигантам, с вопросом: существует ли лучший способ ведения войны? Точнее, можно ли теоретически обеспечить более эффективную координацию между ударной группой в Карибском море и ракетными системами фрегата? Технологические фирмы сотрудничали с BAE Systems, крупнейшим производителем оружия, и Anduril, более мелким новичком, а также с другими военными подрядчиками. В течение 12 недель (что непостижимо быстро для мира оборонных закупок) консорциум собрался в британском Сомерсете для демонстрации того, что было названо StormCloud.

Морские пехотинцы на земле, беспилотники в воздухе и множество других датчиков были соединены в "ячеистую" сеть передовых радиостанций, которые позволяли каждому из них видеть, что происходит в другой точке мира, что уже позволило морским пехотинцам обходить гораздо более крупные силы на предыдущих учениях. Собранные данные обрабатывались как на "краю" сети, на борту небольших надежных компьютеров, пристегнутых к машинам спецназа при помощи тросов, так и на удаленных облачных серверах, куда они отправлялись через спутник. Командно-контрольное программное обеспечение следило за заданным районом, решало, какие дроны куда должны лететь, идентифицировало объекты на земле и предлагало, каким оружием нанести удар по той или иной цели.

Результаты были впечатляющими. По словам офицера, участвовавшего в эксперименте, StormCloud - это "самая продвинутая в мире цепь поражения". Речь идет о сети датчиков (например, беспилотников) и оружия (например, ракет), соединенных цифровыми сетями и программным обеспечением для осмысления данных, поступающих туда и обратно. По его словам, даже два года назад эта система сильно опережала по скорости и надежности человеческих офицеров в обычных штабах.

Инструменты и оружие с поддержкой ИИ используются не только на учениях. Они все чаще используются в точках реальных боевых действий, таких как Газа и Украина. Вооруженные силы видят удивительные возможности. Они также боятся остаться позади своих противников. Расходы быстро растут (см. график 1). Но юристы и специалисты по этике опасаются, что ИИ сделает войну более быстрой, непрозрачной и менее гуманной. Разрыв между этими двумя группами становится все больше, даже когда перспектива войны между великими державами становится все более реальной.

Единого определения ИИ не существует. То, что когда-то называлось этим термином, например, навигация по местности ракет "Томагавк" в 1980-х годах или возможности по обнаружению танков ракет "Бримстоун" в начале 2000-х годов, сейчас рассматривается как обычное программное обеспечение. А многие передовые возможности, называемые ИИ, не связаны с "глубоким обучением" и большими языковыми моделями, лежащими в основе таких сервисов, как Chatgpt. Но в разных обличьях ИИ проникает во все аспекты войны.

Без особой фантазИИ, но незаменим в использованИИ

Все начинается со скучных вещей: технического обслуживания, логистики, персонала и других задач, необходимых для того, чтобы армии были укомплектованы, накормлены и обеспечены топливом. Недавнее исследование аналитического центра Rand Corporation показало, что ИИ, предсказывая время, когда потребуется техническое обслуживание военных самолетов A-10c, может сэкономить американским ВВС 25 млн долларов в месяц, предотвратив поломки и перерасход запчастей (хотя с запчастями, которые редко выходили из строя, ИИ справлялся хуже). Логистика - еще одна перспективная область. Например, армия США использует алгоритмы, чтобы предсказать, когда украинским гаубицам понадобятся новые стволы. ИИ также начинает проникать в сферу вооруженных сил. Армия использует модель, обученную на 140 000 личных дел, чтобы оценивать солдат для дальнейшего продвижения по службе.

Другой крайностью являются острые ситуации. И Россия, и Украина спешно разрабатывают программное обеспечение, чтобы сделать беспилотники способными автономно ориентироваться и наводиться на цель, даже если помехи нарушат связь между пилотом и дроном. Обе стороны обычно используют для этих целей небольшие чипы, которые могут стоить всего 100 долларов. На видеозаписях ударов беспилотников на Украине все чаще можно увидеть, как вокруг объектов появляются "ограничительные рамки", свидетельствующие о том, что беспилотник идентифицирует и фиксирует цель. Технология еще не доработана, алгоритмы наведения на цель сталкиваются со многими из тех же проблем, что и беспилотные автомобили, например, с препятствиями и непонятными объектами, а также с некоторыми уникальными для поля боя факторами, такими как дым и ложные цели. Но она быстро совершенствуется.

Между ИИ на внутреннем уровне и ИИ внутри боеприпасов - огромное поле для инноваций, экспериментов и технологических достижений. По мнению Клинта Хинота, отставного генерала американских ВВС, и Мика Райана, отставного австралийского генерала, беспилотники сами по себе лишь нарушают ход войны, а не трансформируют ее. Но в сочетании с "оцифрованными системами командования и управления" (вспомните StormCloud) и "новыми сетями гражданских и военных датчиков" получается "преобразующая троица", которая позволяет солдатам на передовой видеть и действовать на основе информации в реальном времени, которая раньше хранилась только в далеком штабе.

ИИ - необходимое условие для этого. Начните с сетки датчиков. Представьте себе данные с беспилотников, спутников, из социальных сетей и других источников, разбросанные по военной сети. Их слишком много, чтобы обрабатывать их вручную. Тамир Хайман, генерал, возглавлявший израильскую военную разведку до 2021 года, указывает на два больших прорыва. По его словам, "фундаментальный скачок" произошел восемь или девять лет назад в программном обеспечении для преобразования речи в текст, что позволило искать ключевые слова в перехваченной речи. Другой - в компьютерном зрении. Проект Spotter британского министерства обороны уже использует нейронные сети для "автоматического обнаружения и идентификации объектов" на спутниковых снимках, что позволяет "автоматически следить за местами 24/7 на предмет изменений в активности". По состоянию на февраль частная компания нанесла метки на 25 000 объектов для обучения модели.

Том Копингер-Саймс, британский генерал, заявил в прошлом году в Палате лордов, что такие системы "все еще находятся на ранних стадиях исследований и разработок, а не в стадии полномасштабного развертывания", хотя он указал на использование коммерческих инструментов для выявления, например, скоплений гражданских лиц во время эвакуации Великобританией своих граждан из Судана в начале 2023 года. Америка, похоже, продвинулась дальше. В 2017 году она начала реализацию проекта Project Maven, чтобы справиться с огромным количеством фотографий и видео, сделанных беспилотниками в Афганистане и Ираке.

В мае директор Национального агентства геопространственной разведки, которое руководит проектом, отметил, что Maven "уже производит большие объемы компьютерных изображений для нужд боевых действий". Заявленная цель Maven - "соответствовать или превосходить человеческие показатели обнаружения, классификации и отслеживания". Пока это еще не так: система с трудом справляется со сложными случаями, такими как частично спрятанное оружие. А вот система отслеживания пожаров, связанных с войной на Украине, разработанная журналом The Economist, основана на машинном обучении, полностью автоматизирована и работает в масштабах, с которыми не могут сравниться журналисты. Она уже обнаружила 93 000 вероятных пожаров, связанных с войной.

ИИ может обрабатывать не только телефонные звонки или фотографии. В марте Королевский военно-морской флот объявил, что его подразделение по поиску мин завершило годичные эксперименты в Персидском заливе с использованием небольшого автономного катера Harrier, чья буксируемая гидролокационная система может искать мины на морском дне и оповещать другие корабли или подразделения на суше. А Майкл Хоровиц, сотрудник Пентагона, недавно сообщил сайту Defense News, что Америка, Австралия и Великобритания в рамках своего пакта "АУКУС" разработали "трехсторонний алгоритм", который может быть использован для обработки акустических данных, полученных с помощью сонобуев, сбрасываемых с самолетов P-8, охотящихся за подводными лодками каждой страны.

В большинстве случаев ИИ выявляет сигнал среди шума или объект среди беспорядка: Это грузовик или танк? Якорь или мина? Траулер или подводная лодка? Идентификация людей, участвующих в боевых действиях, возможно, более сложна и, конечно, более спорна. В апреле израильский журнал +972 Magazine утверждал, что Армия обороны Израиля (ЦАХАЛ) использует инструмент ИИ, известный как Lavender, для идентификации тысяч палестинцев в качестве целей, а операторы-люди лишь бегло изучают результаты работы системы, прежде чем отдать приказ о нанесении удара. ЦАХАЛ ответила, что Lavender - это "просто база данных, цель которой - перекрестное сопоставление разведывательных источников".

На практике Lavender, скорее всего, представляет собой то, что эксперты называют системой поддержки принятия решений (decision-support system, DSS) - инструмент для объединения различных данных, таких как телефонные разговоры, спутниковые снимки и другие разведданные. Использование Америкой компьютерных систем для обработки акустических и обонятельных данных с датчиков во Вьетнаме можно считать примитивной системой поддержки принятия решений. Так же, по мнению Руперта Барретта-Тейлора из Института Алана Тьюринга в Лондоне, можно считать и программное обеспечение, используемое американскими шпионами и спецназом в войне с терроризмом, которое превращало телефонные разговоры и другие данные в огромные паутинные диаграммы, визуализирующие связи между людьми и местами, с целью выявления повстанцев или террористов.

В полном разрушенИИ или в солгласИИ?

Отличие заключается в том, что современное программное обеспечение пользуется большей вычислительной мощностью, более сложными алгоритмами (прорыв в области нейронных сетей произошел только в 2012 году) и большим количеством данных благодаря распространению датчиков. Результат - не просто более мощный или более совершенный интеллект. Это размывание границ между разведкой, наблюдением и рекогносцировкой (ISR) и командованием и управлением (C2) - между осмыслением данных и действиями на их основе.

Рассмотрим украинское программное обеспечение GIS Arta, которое собирает данные о российских целях, как правило, артиллерийских батареях. Оно уже может генерировать списки потенциальных целей "в соответствии с приоритетами командиров", как сообщают генералы. По словам официальных лиц, одна из причин, по которой наведение на цели России на Украине улучшилось в последние месяцы, заключается в том, что российские системы С2 стали лучше обрабатывать информацию с беспилотников и передавать ее на орудия. "По некоторым оценкам, - пишет Артур Холланд Мишель в документе для Международного комитета Красного Креста (МККК), гуманитарной организации, - поиск, распознавание и анализ цели, на которые раньше уходили часы, могут быть сокращены... до нескольких минут".

ВВС США недавно обратились в корпорацию Rand с просьбой оценить, могут ли средства ИИ предоставить "космическому бойцу" варианты действий в случае возникновения угрозы для спутника. В результате был сделан вывод, что ИИ действительно могут рекомендовать "высококачественные" ответы. Аналогичным образом, Управление перспективных исследовательских проектов Министерства обороны США (DARPA) работает над программой, получившей название "Стратегический двигатель хаоса для планирования, тактики, экспериментов и отказоустойчивости" (SCEPTER) , которая призвана вырабатывать рекомендации для командиров во время "ведения военных действий на высокой скорости". По сути, система может генерировать новые военные планы на лету.

"Многие из методов, которые используются" в SCEPTER и подобных проектах DARPA, "не существовали даже два-пять лет назад", - говорит Эрик Дэвис, руководитель программы в агентстве. Он приводит в пример теорию Купмана, старую и малоизвестную математическую модель, которая позволяет анализировать сложные и нелинейные системы, подобные тем, что встречаются на войне, в терминах простой линейной алгебры. Недавние прорывы в ее применении сделали ряд проблем ИИ более решаемыми.

Какова цена такой инновацИИ и какие возникают претензИИ

Результатом всего этого стала растущая интеллектуальная пропасть между теми, чья работа заключается в ведении войны, и теми, кто стремится ее укротить. Эксперты в области права и этики утверждают, что растущая роль ИИ в войне чревата опасностями. "Системы, которые мы имеем сейчас, не могут распознать враждебные намерения", - утверждает Ноам Любелл из Эссекского университета. "Они не могут отличить низкорослого солдата с настоящим оружием от ребенка с игрушечным пистолетом... или раненого солдата, лежащего, склонившись над винтовкой, от снайпера, готового выстрелить". Такие алгоритмы "не могут использоваться на законных основаниях", - заключает он. Нейронные сети также можно слишком легко обмануть, говорит Стюарт Рассел, специалист по информатике: "Можно взять совершенно невинные предметы, например фонарные столбы, и нанести на них узоры, которые убедят оружие, что это танк".

Сторонники ИИ в военной сфере возражают, что у скептиков слишком радужный взгляд на войну. Ударный беспилотник, охотящийся за конкретным объектом, может не распознать, не говоря уже о том, чтобы принять попытку сдаться, признает бывший британский офицер, занимающийся вопросами политики в области ИИ. Но если альтернативой является интенсивный обстрел, то "в таких обстоятельствах сдаваться нельзя". Кит Дир, бывший офицер Королевских ВВС, ныне работающий в японской компании Fujitsu, рассуждает шире. "Если... машины выдают меньше ложных положительных и ложных отрицательных результатов, чем люди, особенно под давлением, то было бы просто неэтично не делегировать полномочия", - утверждает он. "Мы провели различные тесты, в которых сравнили возможности и достижения машины с возможностями и достижениями человека", - говорит генерал Хейман из IDF. "Большинство тестов показали, что машина намного, намного, намного точнее... в большинстве случаев это не сравнить".

Одно из заблуждений связано с экстраполяцией на антитеррористические кампании 2000-х годов. "Будущее - это не распознавание лиц и стрельба в человека с высоты 10 000 футов", - утверждает Палмер Лаки, основатель компании Anduril, одной из фирм, участвующих в StormCloud. "Речь идет о попытке сбить флот десантных кораблей в Тайваньском проливе". Если объект обладает визуальными, электронными и тепловыми характеристиками ракетной установки, утверждает он, "вы просто не можете ошибиться... он настолько невероятно уникален". Предвоенное моделирование еще больше снижает неопределенность: "99 % того, что вы видите в китайском конфликте, было многократно проработано в симуляторе, - говорит Лаки, - задолго до того, как это когда-либо произойдет".

"Проблема в том, что когда машина совершает ошибки, это ужасные ошибки", - говорит генерал Хейман. "Если их допустить, они приведут к травматическим событиям". Поэтому он выступает против того, чтобы выводить человека "из цикла" и автоматизировать нанесение ударов. "Это очень заманчиво", - признает он. "Вы значительно ускорите процедуру. Но вы можете нарушить международное право". Лаки признает, что ИИ будут наименее уместны в "грязной, муторной, ужасной" работе в условиях городской войны в стиле Газы. "Если люди думают, что будут роботы-терминаторы, которые будут искать нужного Мухаммеда и стрелять в него... все будет не так".

Со своей стороны, Международный Комитет Красного Креста предупреждает, что системы ИИ потенциально непредсказуемы, непрозрачны и предвзяты, но признает, что они "могут способствовать более быстрому и широкому сбору и анализу имеющейся информации... минимизируя риски для гражданского населения". Многое зависит от того, как использовать эти инструменты. Если Армия обороны Израиля использовала Lavender, как сообщалось, это говорит о том, что проблема заключалась в чрезмерно жестких правилах ведения боевых действий и нерадивых операторах, а не в патологии самого программного обеспечения.

В течение многих лет эксперты и дипломаты спорят в Организации Объединенных Наций о том, следует ли ограничить или запретить автономные системы вооружений (AWS). Но даже дать им определение сложно. По мнению Международного комитета Красного Креста (ICRC), к таким системам относятся те, которые выбирают цель на основе общего профиля - скажем, любой танк, а не конкретный. К ним относятся многие беспилотники, используемые на Украине. Международного комитета Красного Креста выступает за запрет на использование автономных систем, которые нацелены на людей или ведут себя непредсказуемо. Британия возражает, что "полностью" автономное оружие - это то, которое идентифицирует, выбирает и атакует цели без "соответствующего контексту участия человека", что является гораздо более высокой планкой. Пентагон придерживается аналогичной точки зрения, подчеркивая "соответствующий уровень человеческого суждения".

Определить это, в свою очередь, чудовищно сложно. И дело не только в летальном исходе, но и в том, что предшествует ему. Может показаться, что высокоавтономному ударному беспилотнику не хватает человеческого контроля. Но если его поведение хорошо изучено и он используется в районе, где, как известно, есть законные военные цели и нет гражданских лиц, то проблем с ним не возникнет. И наоборот, инструмент, который просто предлагает цели, может показаться более надежным. Но командиры, которые вручную утверждают отдельные цели, предложенные инструментом, "без когнитивной ясности или осознания", как выражается группа по защите интересов Article 36, - бездумное нажатие красной кнопки, другими словами, - отказываются от моральной ответственности перед машиной.

Проблема может усугубиться по двум причинам. Первая заключается в том, что ИИ порождает ИИ. Если одна армия использует ИИ для более быстрого обнаружения и поражения целей, другая может быть вынуждена прибегнуть к ИИ, чтобы не отставать. Так уже происходит с противовоздушной обороной, где передовое программное обеспечение стало необходимым для отслеживания приближающихся угроз с самого начала компьютерной эры. Другая причина заключается в том, что человеку будет сложнее понять поведение и ограничения военных систем. Современное машинное обучение пока не очень широко используется в "критических" системах поддержки принятия решений, отмечает Холланд Мишель. Но оно будет использоваться. И эти системы будут решать "менее математически определённые задачи", - отмечает он, - например, предсказывать будущие намерения противника или даже его эмоциональное состояние.

Поговаривают даже об использовании ИИ в принятии решений по ядерным вопросам. Идея состоит в том, чтобы страны могли не только объединять данные для отслеживания входящих угроз (как это происходит с 1950-х годов), но и автоматически принимать ответные меры, если политическое руководство будет убито в результате первого удара. Советский Союз работал над подобной концепцией "мертвой руки" во время холодной войны в рамках своей системы "Периметр". Она по-прежнему используется, но, по слухам, теперь в ней используются программы, управляемые ИИ, отмечает Леонид Рябихин, бывший офицер советских ВВС и эксперт по контролю над вооружениями. В 2023 году группа американских сенаторов даже представила новый законопроект: "Акт о блокировании ядерных запусков с использованием искусственного интеллекта". Естественно, это секретная область, и мало что известно о том, как далеко хотят зайти разные страны. Но этот вопрос достаточно важен, поэтому в прошлом году он занимал одно из первых мест в повестке дня президентских переговоров между Джо Байденом и Си Цзиньпином.

Сохранять позицИИ

На данный момент в обычных войнах "почти всегда есть время, чтобы кто-то сказал "да" или "нет", - комментирует британский офицер. "Нет никакой автоматизации всей цепочки поражения, которую требуется наладить или которая уже налажена". Так ли это будет в войне высокой интенсивности с Россией или Китаем, не так ясно. В книге "The Human Machine Team" ("Человек с машиной заодно"), опубликованной под псевдонимом в 2021 году, бригадный генерал Йосси Сариэль, глава элитного израильского подразделения военной разведки, пишет, что "команда человек-машина" с помощью ИИ может генерировать "тысячи новых целей каждый день" во время войны. "По его мнению, "существует узкое место в человеческой коммуникации, как для поиска новых целей, так и для принятия решений по их утверждению".

На практике все эти дебаты отходят на второй план в связи с происходящими событиями. Ни Россия, ни Украина не обращают особого внимания на то, является ли беспилотник "автономной" системой вооружения или просто "автоматизированной". Их приоритетом является создание оружия, способного избегать помех и уничтожать как можно больше вражеской техники. Ложные срабатывания не являются большой проблемой ни для российской армии, которая на сегодняшний день разбомбила более 1000 украинских объектов, ни для украинской армии, которая борется за свое выживание.

Страны НАТО знают, что им, возможно, придется столкнуться с российской армией, которая после окончания войны будет иметь большой опыт создания оружия на базе ИИ и испытания его на поле боя. Китай тоже стремится использовать многие из тех же технологий, что и Америка. Китайские фирмы производят подавляющее большинство беспилотников, продаваемых в Америке, будь то потребительские или промышленные товары. В ежегодном докладе Пентагона о военной мощи Китая отмечается, что в 2022 году Народно-освободительная армия (НОАК) начала обсуждать "многодоменную точную войну": использование "больших данных и искусственного интеллекта для быстрого выявления ключевых уязвимых мест" в американских военных системах, таких как спутники или компьютерные сети, которые затем могут быть атакованы.

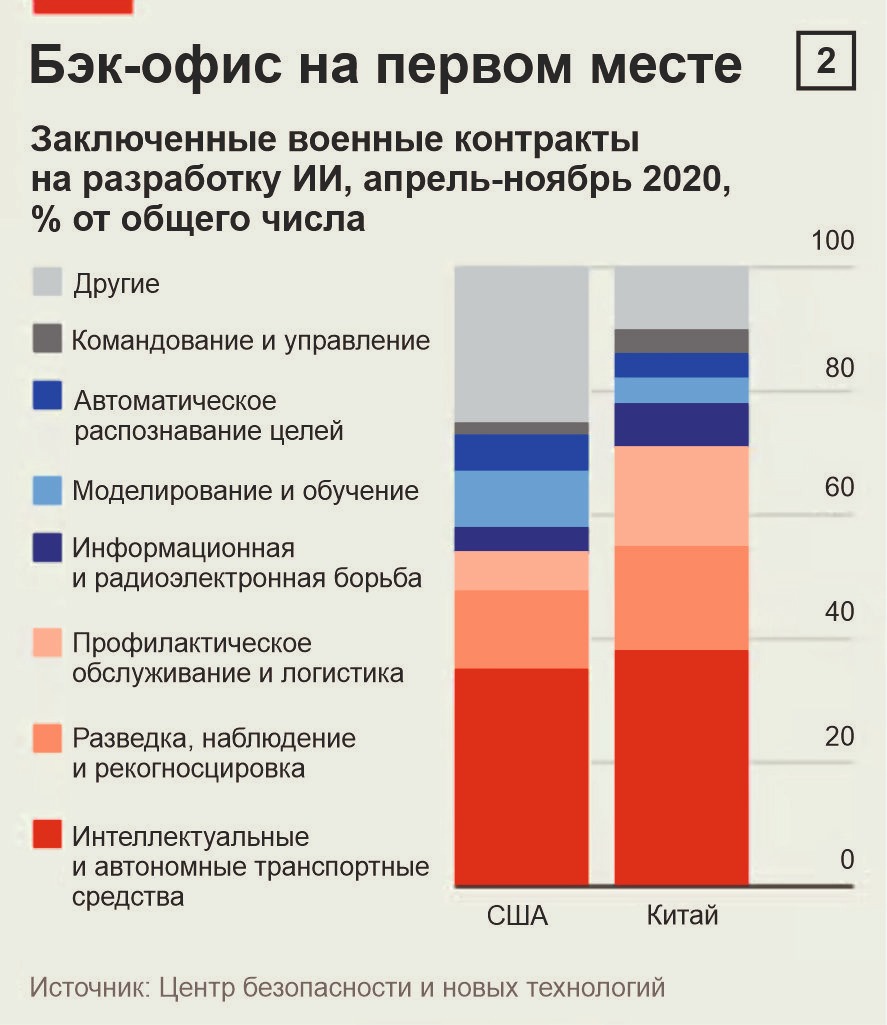

Вопрос в том, кто одержит верх. Американские чиновники в свое время опасались, что нестрогие правила конфиденциальности и контроль над частным сектором в Китае дадут плану доступ к большим и лучшим данным, что приведет к созданию лучших алгоритмов и оружия. Сейчас эти опасения развеялись. Недавнее исследование данных о закупках, проведенное Центром безопасности и новых технологий (CSET) при Джорджтаунском университете, показало, что Америка и Китай "уделяют сопоставимое внимание схожему набору приложений для ИИ" (см. график 2).

Более того, Америка вырвалась вперед в создании передовых моделей, отчасти благодаря ограничениям на производство чипов. По данным компании Epoch AI, в 2023 году она произвела 61 выдающуюся модель машинного обучения, а Европа - 25. Китай произвел 15. Это не те модели, которые используются в нынешних военных системах, но они будут использоваться в будущих. "Китай сталкивается с серьезными препятствиями в области... военного применения ИИ", - утверждает Сэм Бресник из CSET. По его словам, неясно, хватит ли у страны технических талантов для создания систем мирового класса, а централизованное принятие решений может помешать ИИ участвовать в этом процессе. Многие китайские эксперты также опасаются "ненадежных" систем ИИ. "НОАК обладает огромной смертоносной военной мощью, - отмечает Джейкоб Стоукс из другого аналитического центра CNAS, - но на данный момент ни одна из них не обладает достаточным уровнем автономности, обеспечиваемым ИИ".

Очевидная медлительность Китая является частью более широкой закономерности. Некоторые, например Кеннет Пейн из Королевского колледжа Лондона, считают, что ИИ изменит не только ведение войны, но и ее сущность. "Слияние машинного и человеческого интеллекта станет предвестником действительно новой эры принятия решений на войне", - предсказывает он. "Возможно, это будет самое революционное изменение со времен открытия письменности несколько тысяч лет назад". Но даже несмотря на то, что подобные заявления становятся все более правдоподобными, трансформация во многих отношениях остается упрямо далекой.

"Ирония заключается в том, что мы говорим, будто ИИ повсюду в обороне, в то время как его почти нигде нет", - отмечает сэр Крис Деверелл, британский генерал в отставке. "Уровень внедрения ИИ в Министерстве обороны Великобритании почти нулевой... Там очень много экспериментальных разработок". Высокопоставленный чиновник Пентагона говорит, что ведомство добилось серьезного прогресса в совершенствовании инфраструктуры данных - каналов, по которым перемещаются данные, - и в создании беспилотных летательных аппаратов, которые работают вместе с боевыми самолетами с экипажами. Тем не менее Пентагон тратит менее 1% своего бюджета на программное обеспечение - эту статистику часто приводят руководители оборонных технологических стартапов. "Что уникально для Пентагона, так это то, что наша миссия связана с применением силы, поэтому ставки высоки", - говорит чиновник. "Мы должны внедрять ИИ быстро и безопасно".

Тем временем британская система StormCloud становится "все лучше и лучше", - говорит офицер, участвующий в ее разработке, - но проект продвигается медленно из-за внутренней политики и волокиты, связанной с аккредитацией новых технологий. Финансирование второй версии проекта составило мизерные 10 миллионов фунтов стерлингов - карманные деньги в мире обороны. Планируется использовать его на нескольких учениях в этом году. "Если бы мы были Украиной или действительно беспокоились о том, что скоро начнем войну, - говорит офицер, - мы бы потратили более 100 миллионов фунтов стерлингов и развернули бы его через несколько недель или месяцев".