Индексатор URL Google по API

ДмитрийВсем доброго, как обещал пишу инструкцию (гайд, мануал, называете как хотите) по решению проблемы с индексацией страниц в ПС Google.

Немного флейма или вступление (несколько предложений как обычно J )

Кто хоть раз занимался продвижением сайтов, либо настраивал SEO, сталкивался (особенно в последнее время) с проблемой индексации сайта поисковой системой Google.

Не стоит путать – SEO это не продвижение, это оптимизация для поиска, продвижение – это уже комплекс действий, который так или иначе позволяют с сайта получать прибыль.

Большинство моих прошлых проектов были направлены на внутренний рынок с русскоязычным контентом, по-простому – на Россию. А по данному региону рулит Яндекс, как минимум (статистика взята не с чужих проектов, а со своих, когда-то продвигаемых), так вот как минимум 70% трафика шло с ПС Яндекс. В принципе это всех устраивало, и с Яндексом мороки практически всегда не было, так как продвигали в основном контентом, а не ссылками.

Многие проекты до сих пор гребут трафик, несмотря на то что давно не занимаемся их продвижением – но это уже полемика… к сожалению, они чужие.

За последние 5 лет я делал попытки развить самостоятельное направление, чтобы потом получать пассивный доход на автомате… ну или почти пассивный… такая мечта не только у меня думаю…

Так вот, не буду описывать сколько тысяч баксов я на это потратил, но эффекта не было к сожалению, проекты только жрали бабло не давая результаты. Половина проектов кстати, описана на канале (так если что, вдруг станет интересно), половину я не публиковал, так как они имели коммерческое направление и имели эксклюзивный контент.

Ну да ладно, давайте уже ближе к делу

Последний проект дал хороший результат, и я продолжаю вкладывать в него свои усилия.

Даже к своему удивлению он превысил ожидание примерно раз в десять. Но это не суть.

Суть в том, что я «Хочу больше трафика!!!» как и все, наверное, трафик — это деньги, тут не поспоришь. Итак, где взять доп трафик? – естественно в Google. Тока вот незадачка – гугл упорно игнорирует проект, и в индексе держит всего 20% страниц от количества опубликованных.

Разница между индексацией Google и Яндекс колоссальная. Яндекс жрёт новые страницы каждый день (с нового 2022 года настроил публикацию так, что каждый день появляется 3-7 новый страниц с контентом).

Итог – за 3 месяца трафик поднялся на 70%, ну опять же с Яндекс, а Google даёт всего 6-10%.

Вот и думаю, проблема связанна с самим Google, или проблема в сайте? Стал копать, нашёл ошибку в сайтмап, поправил, в итоге Гугл увидел сайтмап и вместо ~ 400 стр., уведомил (статистика) что добавлены ~ 1600 стр. Я уже потирал руки и готовился на Бали ехать на своём Бугатти. Прошла неделя, ещё одна, потом ещё….

Су… а……… Жаль не могу тут вставить смайлики, но вы понимаете моё разочарование, то есть гугл страницы с сайтмап взял, а в индекс их просто не добавляет…

Так как я ужасно ленивый J решил пробить старый метод – пингатор – то есть пропинговать страницы через кучу сервисов (прогу выкладывать не буду, так как это не помогло). В итоге пинганул на примерно 900 ресурсов – получил какой-то трафик левый со стран 3-го ТИРа (ну типо Мозамбика, Гватемала, Сальвадор, ну понимаете откуда). Вообще ХЗ, может и не с пингацией связано, но сейчас оттуда трафика нет. И то, повышение это было в количестве нескольких процентов, так на общей статистике не отразилось.

Пошёл дальше – решил написать типо ручного индексатора, использовав «божественную» J программу Зеннопопстер (ну да, ржу)… Написать то я написал (минут за 20 наверное), по после 10-той страницы добавления в индекс мне Гугл выдал «Ваш лимит на сегодня закончился» … Шооо???

Потом я забил на всё, написал на канале телеги «Как я люблю Гугл» и пошёл играть, или в мастерскую, или жрать… короче свалил чтобы не взорваться J.

Спасибо что в чате есть адекватные товарищи, написали, подсказали, дали ссылки (спасибо уже сказал лично, вы знаете кому адресовано). Пришлось курить тему, читать форумы, чаты телеграмм.

В итоге я пришёл к тому практически, с чего и начинал, то есть к индексированию по API самого Google.

(я не написал про это, но индексатор по API я уже встретил недели 3 назад, но мне показался он тогда сложный в настройке, и забил на него).

Я знаю вы устали, от моего словоблудия, давайте уже к делу J…

Получаем URL, которые нужно проиндексировать в Google

Итак, что нужно чтобы «Добавленные страницы» попали в индекс Google, а не болтались просто в Добавленных.

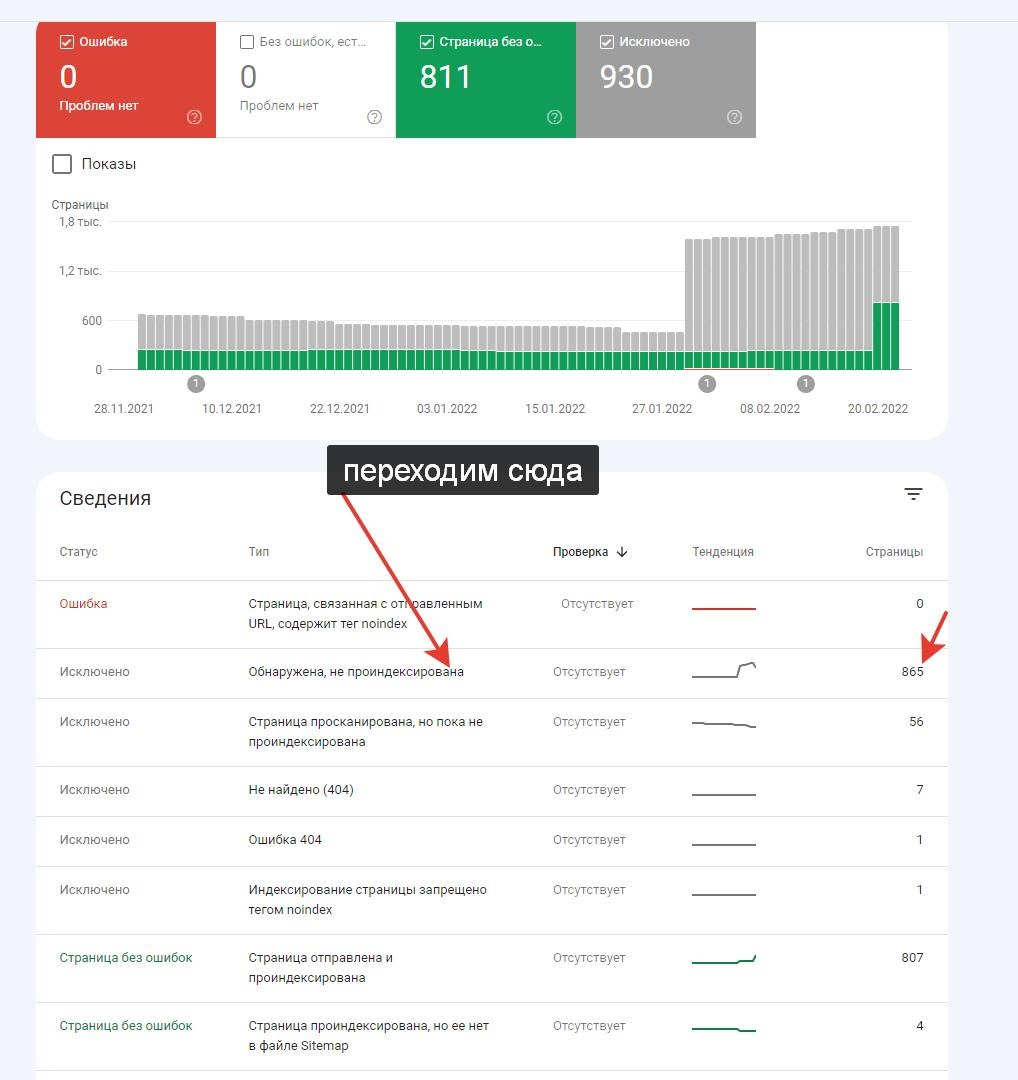

Во-первых, заберём все страницы, которые не добавлены роботом в поиск:

Естественно, у вас должен быть аккаунт в GSC (гугл серш консоль), если нет, регистрируйте и ждите минимум 3-7 дней (хотя думаю, если вы это читаете, то у вас есть это).

Нам нужно собрать все не проиндексированные страницы (как пишет Гугл – Страницы обнаружены, но не проиндексированы).

Просто авторизуйтесь в Гугл (почта, либо вебмастер напрямую):

https://www.google.com/webmasters/verification/home

и переходите по ссылке:

https://search.google.com/search-console

Выбираем свой проект, переходим:

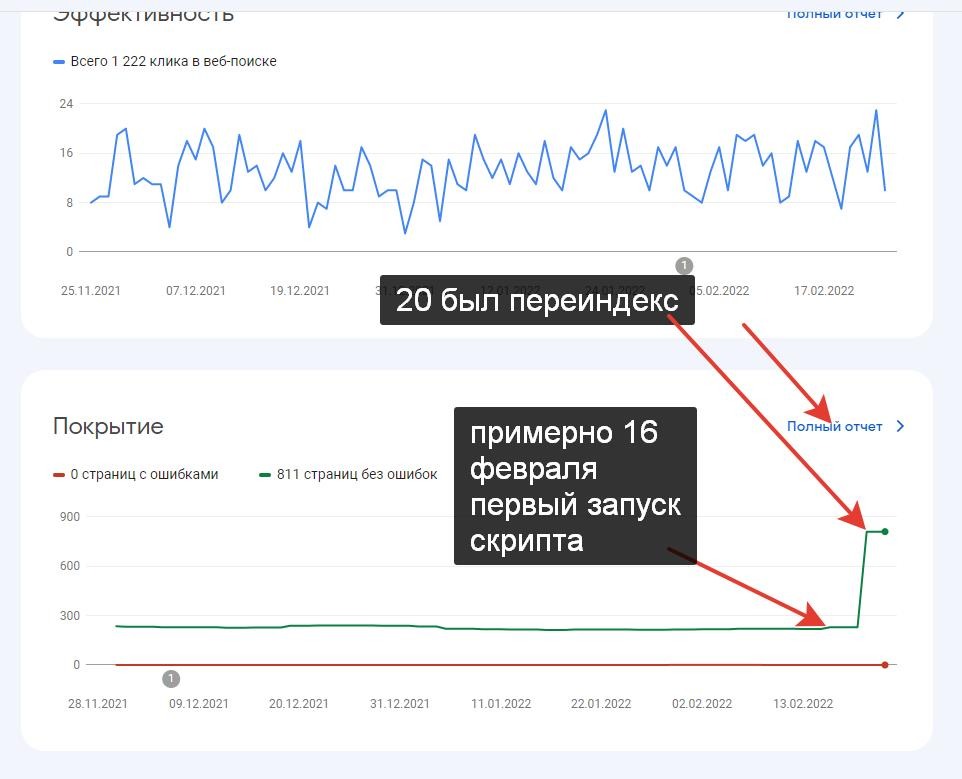

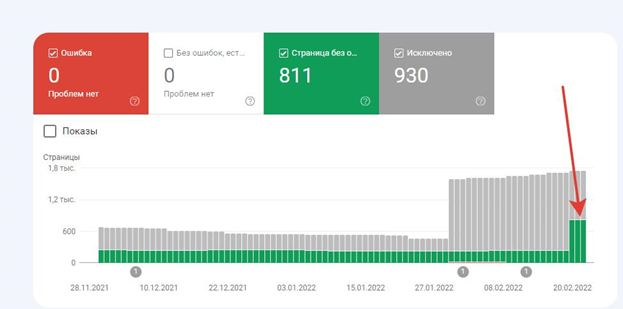

(очевидно вы сразу заметите спойлер – это результаты попадания в индекс спустя неделю запуска скрипта)

Переходим на «Полный отчёт»

Где исправлен Сайтмап – видно по взлёту серых столбиков J

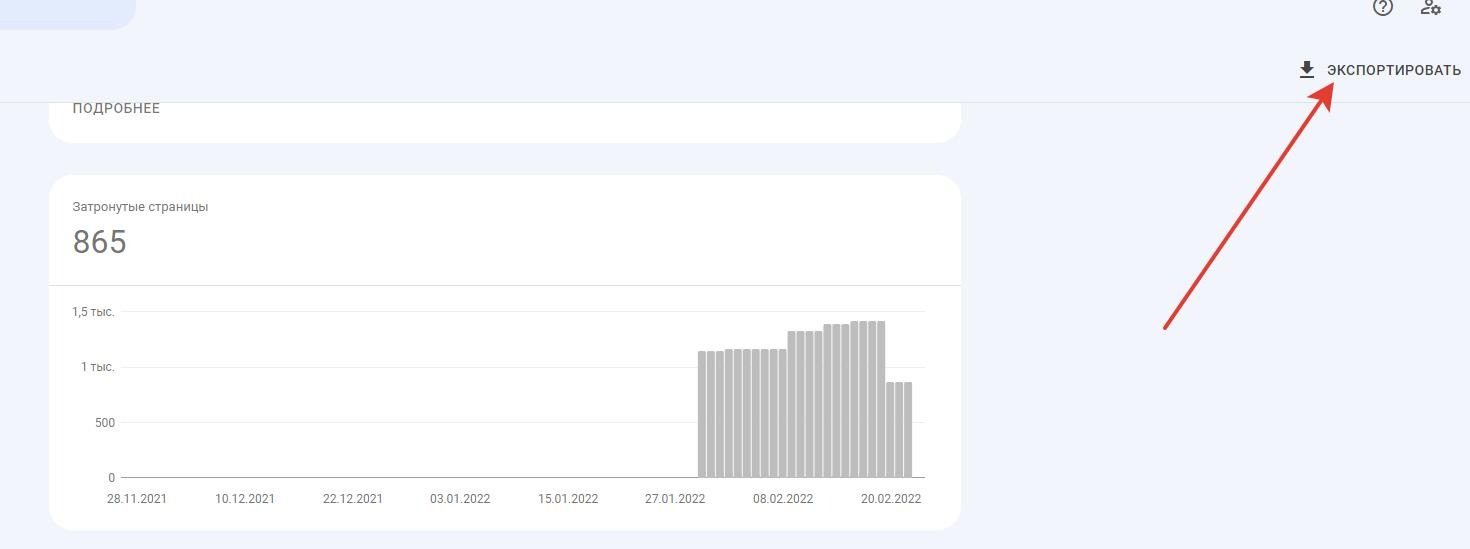

И экспортируем наши ссылки, сохраняем допустим в файле noindex.txt

(экспорт вы получите в logs.csv, поэтому просто скопируйте данные ссылки из CSV и перенесите в текстовый документ, обратите внимание, что кодировка нового TXT должна быть обязательно в UTF-8).

Как и обещал вы реально увидите индексацию после работы скрипта.

(Спойлер – по факту на картинке выше – вы видите как раз часть страниц уже попало в индекс – около 600 новых).

Сайт добавлен в GSC более года назад, проблема сайтмапа возможно была первой причиной, что Гугл не охотно хотел добавлять сайт в индекс, и на графиках это видно. Но исправление ошибки не дало результата даже спустя 1,5 месяца…То есть страницы сайта добавлены, но не проиндексированы.

Получаем JSON ключ API

Теперь вам нужно получить ключ API. Я тут не буду описывать полный цикл добавления ключа, так как полно в сети таких инструкций, дам просто ссылку.

По мне - вот тут написано более-менее понятно:

https://ppcseo.com/articles/google-indexing-api-indeksiruem-sajt-bystree

доходите до получения ключа (кстати, если у вас Wordpress то там есть плагин, который добавляет новые страницы по API, читеры блин J).

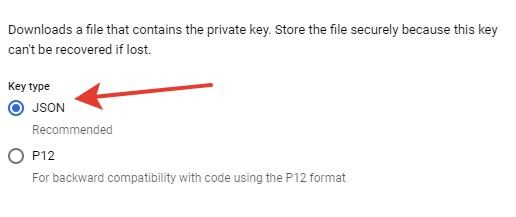

Только обратите обязательно внимание, что ключ нужен не текстовый, а JSON (.json).

В процессе регистрации для получения ключа увидите типо такой записи, вот я про это:

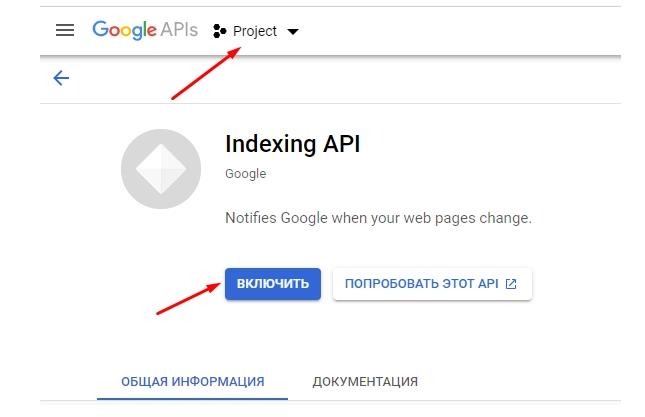

Так же покликайте на странице и проверьте, включён ли API, если нет – включите:

Как тока создали ключ JSON появляется окно с сохранением его на компе, сохраняем.

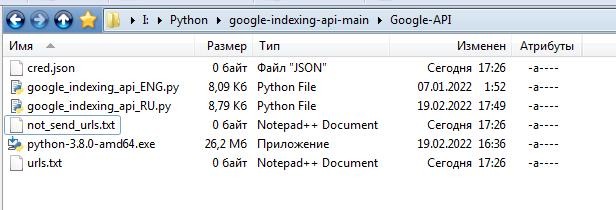

Создаём в любой директории у себя папку (допустим):

Google-API

Распаковываем туда архив (ищите в приложении).

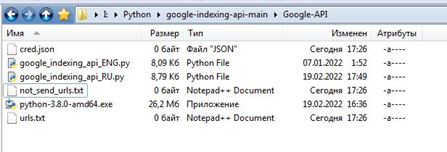

После распаковки моего архива получаете это (все файлы вы можете открыть в Notepad++ и посмотреть содержимое, так же ссылки на все оригинальные фалы будут в конце описания):

Скрипт написан на Python (приложен в архиве на Windows 64). Если хотите с первоисточника – вот ссылка, крутите вниз страницы, там выбираете нужную версию ОС (МАС, винда, битность 32-64, ну соображайте сами уже – «Windows x86-64 executable installer» то что я выбирал):

https://www.python.org/downloads/release/python-380/

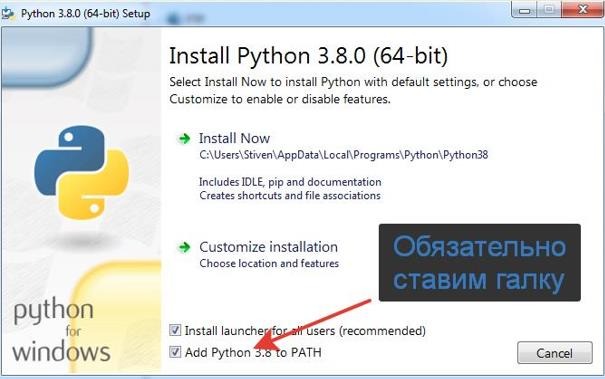

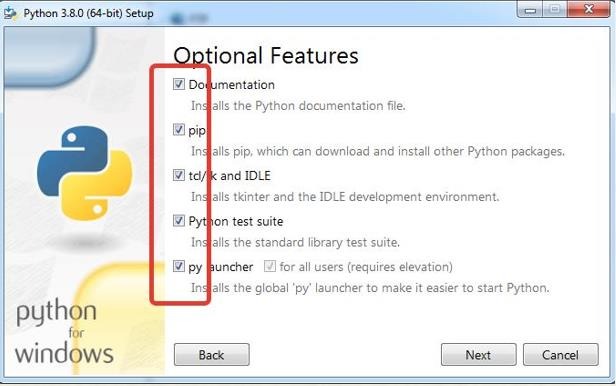

Устанавливаем Python 3.8

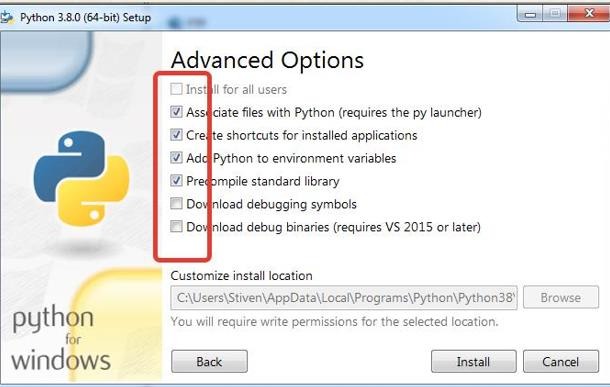

Устанавливаем Python, обязательно при установке ставим галочки:

Если уже ставили, или забыли поставить где-то галочки, можно заново запустить установщик и выбрать переустановку, и в активных окнах указать недостающие (забытые) галочки.

Вообще всё очень просто, даже проще чем я сам думал…

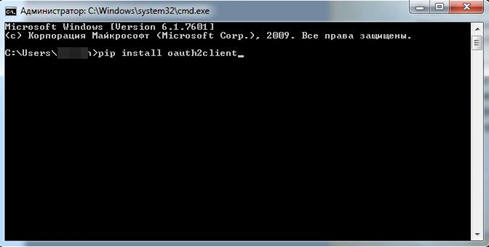

После установки Питона J (мне нравиться так ласково называть его) ставим дополнительную библиотеку:

Вызываем «чёрную CMD»:

В панели задач, слева снизу - Иконка Виндовс – Поиск – cmd.exe

В Windows 7 запускаем «НЕ от имени Администратора», в Windows 10 запускать «От имени Администратора». Так как у меня всегда Винда идёт с одним пользователем (Админ) то есть администратора, то вот у меня так. Возможно у вас будут другие учётки с другими правами…

Главное - смотрите, чтобы строка начиналась с C:\Users\

Копируем текст, наводим в окне - правой кнопкой – Вставить и Enter

pip install oauth2client

Ждём как установиться библиотека……

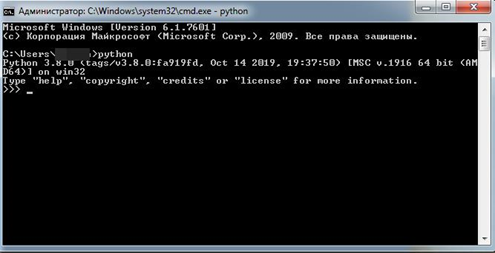

Закрываем CMD, открываем снова и проверяем, установился ли Python (можно проверить это и раньше, сразу после установки Питона):

Вводим – python

Если Python установился (видим всё ок – 3.8), идём дальше. В принципе установка Питона и библиотек закончена. CMD можно закрыть, больше не понадобиться.

Готовим файлы

Создаём файл (всё будет в приложении, файлы внутри я оставлю пустые).

urls.txt

В этот файл вставляем все ссылки, которые ранее экспортировали с GSC Google (то есть ссылки на не проиндексированные страницы).

Есть лимиты на API Google в 200 запросов в сутки, как их обойти напишу ниже.

Забегу вперёд – вы можете добавлять не все ссылки, а только 200 (то есть скопируйте 200 ссылок, вставьте их в файл urls.txt, и удалите скопированные из общего документа). А можете добавить ВСЕ ссылки, скрипт автоматом возьмёт только первые 200…

· Итак, мы имеем файл со всеми ссылками noindex.txt (файл просто как резервный с вашими ссылками).

· Файл с ссылками urls.txt (200 шт, либо все, как удобно).

· Два скрипта Pythone на английском и на русском (пояснительные записи русские, русский я перевёл сам, пару мест кривовато, но на функциональность не влияет).

google_indexing_api_ENG.py

google_indexing_api_RU.py

· Файл not_send_urls.txt (появится после первого отработанного скриптом цикла), я просто добавил для комплекта. Файл перезаписывается самим скриптом.

· Ключ cred.json (естественно он пустой, не забудьте переименовать свой ключ, когда получите\скачаете с API Google).

Повтор

В принципе всё.

Запускаем индексатор URL на Python

Теперь запускаем английский .PY либо русский (если с английским языком сильно не дружите).

· Либо этот google_indexing_api_ENG.py

· Либо этот google_indexing_api_RU.py

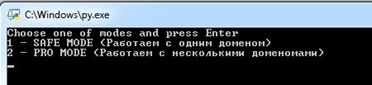

Первое что видим – это запрос на выбор индекса по доменам – один домен или много.

Я не буду рассматривать тут многодоменную индексацию, так как использовал только один сайт (домен):

Пишем 1 – и жмём Enter.

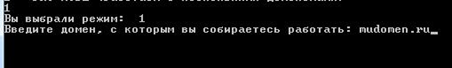

Далее пишем наш Домен (именно домен!):

Далее жмём Enter.

Обратите внимание – если окно CMD закрывается после этого – то что-то пошло не так (смотрите, набрали неправильно домен, не сохранили файл с ключом cred.json, использовали русскую раскладку клавиатуры, установлена другая версия Питона).

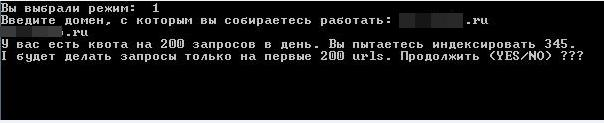

Далее скрипт посчитает сколько URL у вас в файле, если их более 200 (я взял для примера 345) сообщит, что будет добавлено только 200, (а остальные будут сохранены в файле not_send_urls.txt)

!!! Тут важно - пишите YES (можно строчными yes) !!! не Y, и не y, а именно yes .

Так как с ключом всё ок – просто жмёт далее Enter.

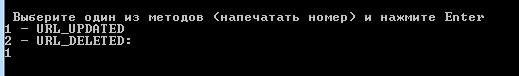

Далее выбираем что хотим сделать – «Добавить» страницы либо «Удалить» из индекса (да, удаление бывает необходимо, когда, допустим, вырвали хороший дропдомен, но новая тематика сайта расходиться со старыми проиндексированными страницами):

Выбираем 1 и жмём Enter – ВСЁ, индекс пошёл.

Окно CMD закроется самостоятельно спустя 3-4 минуты.

Так, теперь пройдёмся по тонкостям

После добавления первых 200 страниц у вас появиться новый файл not_send_urls.txt (в случае если в файле индекса было более 200 строк с URL).

Как я делаю – открываю файл urls.txt, удаляю всё внутри, далее открываю файл с остатками not_send_urls.txt, копирую оттуда всё и вставляю в файл urls.txt . Там проще, не надо следить сколько и где я там что-то сохранял. В итоге в остатке в файле not_send_urls.txt у нас всегда будут только не добавленные URL). Через сутки беру остатки с файла not_send_urls.txt и копирую их в заранее очищенный файл urls.txt и повторно запускаю скрипт.

С ОДНОГО ключа API запускать скрипт можно только раз в сутки – лимит на 200 запросов. Второй раз через сутки…

Вам никто не мешает зарегистрировать вторую, третью – десятую учётку в Гугле и взять ещё один два… 100 ключей.

Просто копируем папку с набором скриптов, кидаем туда второй (другой) ключ cred.json и запускаем скрипт с новым ключом (и новым набором URL). То есть если вы хотите добавить в индекс страницы с сайта боле 200 шт. за один день – то поможет только новый, дополнительный ключ.

Читал в сети что делали по 50 ключей и скрипт – который автоматом перебирает все ключи и с каждого делает по 200 запросов. Ну типо в итоге загоняют в индекс по 10000-20000 страниц за один раз, так сказать.

Ну сорян, я тут не буду рассматривать настройку других скриптов (там посложнее малость, да и автоматизация мне такая была без надобности).

Итог, результаты

Я запускал скрипт 5 раз за 5 дней, в итоге был переиндекс в Google после 4-го запуска скрипта (повезло мне). – в итоге это видно в статистике. Далее я запускал скрипт ещё раз, то есть всю выборку в 1000 URL я успешно добавил в индекс. Теперь подожду неделю-другую, до следующего индекса от Google, выберу остатки непроиндексированных URL и уже их добью.

На, примерно, 3-м запуске (на скринах видно, что не в индексе изначально было около 1460 страниц, но по какой-то причине в файле URL было скопировано около 1000 L ).

Но попадание в индекс на 3-тий день уже радует! На канале я писал уже, что первые страницы появились в индексе спустя 10 минут (заморачиваться с анализом логов по гуглботу я не стал, просто руками проверил несколько страниц).

На трафик пока это не как особо не отразилось. То есть добавление страниц в Google не особо улучшило его поведение относительно сайта. Хотя я не унываю. В проекте добавление на сайт английского языка и возможно добавление дополнительных доменов (Типо сателитов COM INFO, но это не точно…)

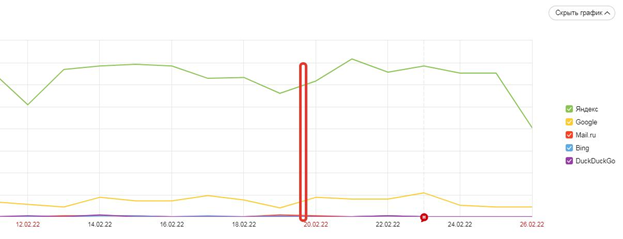

Разграничил примерно попадание новых страниц в индекс Google. Ниже скрин с ЯндексМетрики.

Напомню – на сайт не покупаются ссылки, только контент, поэтому всё движение трафика вверх или вниз – всё основано на чистом SEO. Естественно в проекте развивать далее продвижение, может куплю пару пакетов ссылок, но пока не решил. Сайт по факту это личный долгосрочный проект на пассивный заработок.

Ссылки на оригиналы файлов и инструкций

Гугл вебмастер

https://www.google.com/webmasters/verification/home

GSC Google:

https://search.google.com/search-console

Python 3.8:

https://www.python.org/downloads/release/python-380/

Оригинал скрипта (я в нём ничего не менял, русская версия просто русифицирована):

https://github.com/drkwng/google-indexing-api

Получить ключ Google API (ссылка на инструкцию, инструкция не моя, но я пользовался похожей, таким же образом регистрировал ключ) тут написано даже лучше:

https://ppcseo.com/articles/google-indexing-api-indeksiruem-sajt-bystree

Google Cloud

https://console.cloud.google.com/

Статистика использования API

https://console.cloud.google.com/apis/dashboard

Спасибо что читали

Если есть какие вопросы – можете обсуждать в чате. Недели 2 спустя постараюсь на канал кинуть новые данные по статистике, возможно там что-то измениться.

Надеюсь было как-то полезно.

Спасибо что читали, хотя я любитель налить воды, ну сорян….

Тут канал в Телеге https://t.me/ikipiki

Тут группа https://t.me/joinchat/E1oq5A5X3wNEWqcb3HXIZA

Кому надо, подписывайтесь.

Отвечаю всем по возможности.

=============================================

Автор - Дмитрий.

Актуально на 26.02.2022