Индексация

@traffic_lead Телеграм-канал - "Траффик"1. Проверка индексации каждой страницы сайта

Индексация особенно важна для больших проектов. Если в индекс попадают мусорные страницы (дубликаты, страницы с ошибками, пустые страницы), важные страницы (продвигаемые) получают меньше статического веса. Если в индекс не попадают важные страницы, сайт недополучает трафик.

- Составление списка всех важных страниц сайта (выгрузка из БД, ручное составление, Screaming Frog)

- Составить список всех страниц сайта (программы page-weight или xenu, Screaming Frog)

- Проверить все ссылки с помощью запросов url:http://www.site.ru/page/ и url:http://site.ru/page/, используя автоматический парсер ПС (программа a-parser, https://www.rush-analytics.ru/)

- Составить 4 списка: все проиндексированные важные страницы, все проиндексированные мусорные страницы, все непроиндексированные важные страницы, все непроиндексированные мусорные страницы

2. Составление списка непроиндексированных страниц, посещенных роботом

В некоторых случаях, после посещения робота, страница не попадает в индекс. Важно отличать такие страницы, от страниц, которые не в индексе и робот их не посещал, поскольку технология индексации таких страниц отличается.

- При помощь анализа логов составляется список страниц, которые посещал робот

- Получить список важных непроиндексированных страниц, не посещенных роботом и список важных непроиндексированных страниц, посещенных роботом

- Изучить список непроиндексированных страниц, которые не посещал робот ПС, это будет список страниц, на которые необходимо привести робота, чтобы они попали в индекс

- Изучить список непроиндексированных страниц, которые посетил робот ПС, это будут страницы, которые имеют проблему с дублями или статическим весом

3. Проверка возможности индексации важных областей на flash и ajax сайтах

При продвижении творческих проектов важно изучить индексацию областей, при написании которых использовались технологии Flash, Ajax или другие, с индексацией которых могут возникнуть проблемы.

- Необходимо по матрице сайта открыть текстовую сохраненную копию всех типов страниц и найти там тексты, выложенные с помощью этих технологий, если текст найти удалось – значит блок индексируется

- В редких случаях даже при отсутствии flash и ajax, на сайте может быть настолько кривая верстка, что текст не попадет в текстовый индекс

4. Проверка возможности индексации всех страниц сайта при текущих инструкциях robots.txt

После корректировки robots.txt необходимо проверить, что все важные доступны для индексации.

- Проверка осуществляется сервисом http://webmaster.yandex.ru/robots.xml;

Посмотреть в Screaming Frog блокировку cтраниц

5. Проверка целесообразности использования <noindex>, nofollow, meta noindex, meta nofollow, SEOHide

Ошибки в инструкциях индексации могут привести к выпадению важных страниц из индекса и существенным потерям трафика.

- По матрице сайта делается проверка (сервисы RDS-bar, СайтРепорт)

- Необходимо найти не закрытые <noindex> <!—noindex à <!—/noindex à

- Необходимо изучить, какие внутренние ссылки закрыты в nofollow

- Необходимо изучить, какие внешние ссылки закрыты в nofollow

- Необходимо изучить, какие страницы закрыты в meta noindex

- Необходимо изучить, какие страницы закрыты в meta nofollow

- Необходимо изучить, есть ли на сайте SEOHide и корректно ли он внедрен

6. Проверка корректности использования <noindex>, nofollow, SEOHide

После составления списка страниц, на которых используются инструкции по скрытию индексации, необходимо изучить списки на предмет ошибок. Контрольные точки:

- Не закрытый <noindex> - RDS Bar

- Индексируемый SEOHide – Проверка по сохраненной копии сайта

- Проверка корректности SEOHide с помощью плагина FireBug

- Важные страницы с meta nofollow, meta noindex – Screamig Frog -> Directives

- Rel=»Nofollow» на внутренних ссылках

7. Поиск ошибок (сравнение индексов по категориям и типам страниц)

Необходимо подробно изучить сайт на предмет ошибок. Один из способов это сделать – сравнить списки проиндексированных страниц в разных поисковых системах по тем разделам и типам страниц, где их количество в индексе различается.

- Изучаются области сайта, где в одной ПС страниц меньше, чем в другой

- Открываются страницы из списка проиндексированных, изучаются

- Изучаются те страницы, которых нет в индексе одной из поисковых систем, но есть в другой поисковой системе

- Изучаются страницы в Google, помеченные как supplemental – показать скрытые результаты

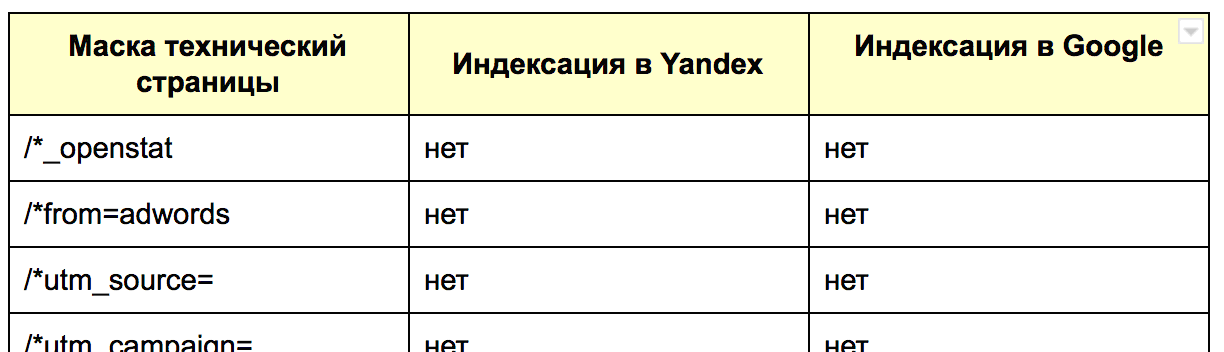

8. Поиск в индексе технических страниц

Приведены популярные типы технических страниц, которые рекомендуется закрывать от индексации, а так же некоторые варианты идентификации их через оператор inurl:

§ Файлы статистики /*_openstat

§ Страницы контекстной рекламы или меток /*from=adwords, /*utm_source=, /*utm_campaign=, /*utm_content=, /*utm_term=, /*utm_medium=

§ Корзина /cart/, /order/

§ Страницы сортировки /*sort, asc, desc, list=*

§ Страницы поиска /search/

§ Страницы авторизации /auth/

§ Версия для печати /*printable, /print

§ Напоминание пароля /remind_password/

§ Регистрация /register/

§ Административный раздел - /administrator/

§ Кэш страниц /cache/

§ Модули, подгружаемые на страницы /components/, /plugins/

§ Файлы инсталяции CMS /installation/, /installer/

§ Логи /logs/

§ Файлы /files/

§ Скрипты, таблицы стилей /ajax/, /java/, /css/

Аккаунты пользователей /user/

9. Анализ динамики индексации сайта

Динамика индексации сайта может указать на слабые места и проблемы проекта.

- Сведение статистики по списку проиндексированных страниц, собранных с параметром &how=tm позволяет нам узнать возраст страниц и изучить динамику индексации сайта

10. Проверка robots.txt на ошибки

Из-за ошибки в robots.txt весь сайт может быть исключен из индекса.

- С помощью сервиса http://webmaster.yandex.ru/robots.xml проверяем закрывает ли robots все ненужные страницы и не находит ли валидатор ошибок

- Проверяем, что robots.txt соответствует правилам http://help.yandex.ru/webmaster/?id=996567

11. Проверка robots.txt на наличие директив для всех поисковых систем

Яндекс и Google используют различные директивы в robots.txt, инструкции для них следует писать отдельными.

- User-Agent: Yandex + User-Agent: * обязательно, опционально User-Agent: Google

12. Проверка sitemap.xml на ошибки

С помощью sitemap.xml можно управлять индексацией своего сайта. Для того, чтобы поисковые системы доверяли рекомендациям и корректно обрабатывали их, необходимо исправить ошибки.

- Ссылка на sitemap.xml есть в robots.txt

- Атрибуты дат страниц расставлены корректно

- Приоритеты расставлены правильно

- Исключены уже проиндексированные страницы

- Нет страниц, закрытых от индексации в robots.txt

- Нет нарушений валидности составления sitemap.xml (сервис http://webmaster.yandex.ru/sitemaptest.xml)

- Дополнительная информация по sitemap.xml - http://www.sitemaps.org/ru/faq.html#faq_xml_schema

Для ускорения индексации страниц сайта поисковыми системами, необходимо создать файл карты сайта sitemap.xml. Общие рекомендации по созданию файла Sitemap:

Файл Sitemap необходимо составлять в виде XML файла, который должен соответствовать стандарту разметки XML тегов (http://www.sitemaps.org/ru/protocol.php), а так же ряду требований:

- Данный файл должен содержать ссылки на главную страницу, страницы категорий, подкатегорий, страницы вида категория+бренд, теговые страницы, страницы пагинации, а так же на страницы товаров;

- Файл не должен содержать URL-адреса, ответ сервера которых отличен от HTTP/1.1 200 OK;

- Файл не должен содержать URL-адреса, закрытые от индексации в файле robots.txt директивами Disallow и Clean-param и закрывающие Meta name;

- URL адреса страниц необходимо указывать полностью, включая префикс «http://» и включая префикс «www», если в качестве главного зеркала выбран домен с www;

- В файле необходимо использовать кодировку UTF-8;

- Каждый файл может содержать не более 50 000 URL, и его размер не должен превышать 10 МБ (10 485 760 байт). Если сайт включает более 50 000 URL, его можно разделить на список на несколько файлов и передать каждый файл отдельно;

- Файл должен автоматически обновляться не реже чем 2 раза в месяц;

- Должны быть прописаны следующие приоритеты: Главная=1; Страницы категорий, подкатегорий и тегов=0,6; Страницы товаров=0,4; Страницы пагинации=0,2;

- Для всех новых страниц прописывать приоритет = 0,8 (Раз в месяц приоритеты 0,8 должны обновляться согласно правилам по типам страницДля добавления в карту сайта страниц мобильной версии сайта требуется использование тега alternate, если мобильная версия на субдомене типа m.site.ru