El nanomundo en tus manos

3. Herramientas para construir el nanomundo

Página 8 de 22

— 3 —

HERRAMIENTAS PARA CONSTRUIR EL NANOMUNDO

Los «años de aprendizaje» del STM se han acabado. Sus bases han sido establecidas, y los «años de viaje» han comenzado. No nos gustaría ser especulativos hacia dónde nos llevarán finalmente, pero creemos, de una manera honesta, que la belleza de las estructuras atómicas puede ser un estímulo para aplicar la técnica a esos problemas que serán exclusivamente de gran beneficio de la humanidad: la ilusión de Alfred Nobel y la de todos nosotros.

G. BINNIG y H. E. ROHRER, Discurso de la ceremonia de entrega del Premio Nobel, 8 de diciembre de 1986.

3.1. Necesidad de nueva instrumentación

La necesidad de construir herramientas ha existido desde el principio de la humanidad. El hombre primitivo golpeaba unas piedras contra otras para obtener lascas afiladas con las que cortar las pieles de los animales que cazaba. A través de la experiencia descubrió que unos guijarros eran más duros que otros y que según el tipo de piedra que utilizase podía obtener herramientas más o menos afiladas o quebradizas. Así, mediante un método experimental de prueba y error y con una idea clara de sus necesidades, que en ese momento estaban vinculadas a su supervivencia, fue conociendo las propiedades de las rocas de su entorno, perfeccionando las herramientas de corte e incluso fabricando utensilios que le permitían crear otros más afilados o con mejores capacidades. Anaxágoras, un filósofo griego que vivió en el siglo V a. C. dijo: «el hombre es inteligente porque tiene manos». No es que la inteligencia resida en los dedos o en las palmas de nuestras manos, pero se manifiesta a través de ellas, permitiéndonos construir lo que ideamos. Los animales también tienen una cierta inteligencia, pero no poseen manos tan sofisticadas como las nuestras. Es esta combinación, entre el intelecto y la habilidad manual, la que ha influido de manera decisiva para hacer del hombre un animal diferente al resto ya que vive en un entorno que él mismo ha modificado. No sólo puede pensar en abstracto o crear una nueva teoría científica, sino que también puede materializarla construyendo nuevos objetos o utensilios. A su vez, la construcción de un nuevo instrumento ayuda a aumentar el conocimiento ya que posibilita experiencias que conducen hacia nuevos pensamientos. Este camino de doble dirección (desde la idea hacia nuevas herramientas y desde esas herramientas a nuevas ideas) ha sido determinante para el desarrollo intelectual de la sociedad. En el caso concreto de la nanociencia, el enorme avance científico que ha experimentado en los últimos años ha venido sin duda motivado por el desarrollo de nuevas herramientas que han permitido a los investigadores observar, comprender y manipular la nanoescala. De esta manera, no sólo modificamos el entorno que habitamos, sino que también somos capaces de modificar los paisajes del nanomundo.

Las técnicas para obtener información del mundo «nano» se desarrollaron posteriormente a las técnicas de análisis convencional. Éstas últimas permiten conocer las propiedades o composición de los materiales, aunque la mayor parte de ellas ofrecen al investigador información global, es decir, de los átomos y moléculas que lo conforman en su interior. Por ejemplo, la difracción de rayos X, una técnica que ha permitido clasificar los materiales desde hace más de un siglo, nos dice cómo están colocados los átomos dentro del material, ya que los rayos X al incidir sobre él penetran varias micras en su interior. Además, puesto que los objetos del nanomundo están formados por estructuras separadas por unos pocos nanómetros, las técnicas de análisis útiles en este caso deben tener resolución lateral suficiente para identificarlas. Así por ejemplo el microscopio electrónico de barrido (conocido como SEM, del inglés Scanning Electron Microscope) tiene una resolución lateral de unos 20-100 nm y es, por tanto, muy útil para describir objetos que midan en torno a la micra, como puedan ser células o granos de polen. Así, a pesar de que la difracción de rayos X y el SEM son técnicas importantes y muy populares entre los investigadores, ninguna de ellas puede ser usada para obtener información de objetos individuales que midan unos pocos nanómetros, como pueda ser una pequeña nanopartícula o una única molécula de ADN. Es decir, la sensibilidad de las técnicas más comunes que se utilizan en un laboratorio convencional está varios órdenes de magnitud por debajo de la que se necesita para estudiar el nanomundo. Para estudiar objetos tan pequeños hacen falta nuevas técnicas con capacidad para ofrecer al investigador información química, estructural o morfológica de muy pocos átomos o distinguir dos puntos que disten entre sí unos pocos nanómetros. Dicho de otra manera, las técnicas útiles para caracterizar los nanobjetos deben tener alta sensibilidad y/o una elevada resolución lateral.

Uno de los motivos por los que la nanociencia ha alcanzado su madurez es porque desde los años ochenta del siglo pasado se han desarrollado nuevas técnicas experimentales que permiten distinguir distintos materiales, fabricar nuevas estructuras o visualizar y manipular diferentes objetos de tamaño nanométrico. Aunque las técnicas disponibles hoy en día son numerosas y muy especializadas, vamos a ofrecer al lector una visión general de las posibilidades que nos ofrece su uso. Haremos especial hincapié en describir aquellas que involucran instrumentación compleja, sin entrar de manera muy profunda en las bases de su funcionamiento, ya que esto requiere unos conocimientos de física o ingeniería muy especializados.

Una idea importante que hay que tener en cuenta para entender las técnicas experimentales de las que vamos a hablar a continuación es que no es posible cazar moscas con una red para mariposas, ni pescar tiburones con un anzuelo para sardinas. Para obtener información sobre un objeto individual y de dimensiones nanométricas, la sonda o partícula que se utilice para su estudio debe ser de su tamaño o inferior. Por ejemplo, si mis dedos estuviesen dentro de una manopla nunca podría escribir en mi ordenador. Para hacerlo, mis dedos deben ser del tamaño de las teclas o más pequeños. Así, si estudiamos un objeto enviándole partículas de un tamaño mayor que él, sólo podremos obtener una información colectiva o promedio de todos los que abarque la sonda, pero nunca individual. Recordemos que la nanotecnología pretende un estudio individualizado de los objetos nanométricos. Este concepto delimita el tamaño de las sondas y, por tanto, las técnicas experimentales que pueden ser utilizadas para estudiar el mundo nanométrico. En primera aproximación, podemos afirmar que la resolución es del tamaño de la sonda utilizada para estudiar la materia. Una posible sonda que se puede utilizar es la radiación electromagnética cuyo «tamaño» característico se puede asemejar a la mitad de su longitud de onda. ¿Cuál es, entonces, la resolución de un microscopio óptico? La de la longitud de onda de la luz con la que incidimos en la muestra, es decir, de micras para la luz visible. Por tanto, con un microscopio óptico nunca podremos obtener información sobre las moléculas ni los átomos que forman un material o nanoestructura, por mucho que mejoremos su sistema óptico.

Otra idea general, que no hay que olvidar cuando describimos las técnicas de fabricación, es que éstas no deben trabajar de una manera secuencial, sino que los productos deben poder obtenerse de manera paralela. Ya discutimos en el «sexálogo» de preceptos del Capítulo 2 que los tiempos de procesamiento pueden llegar a ser infinitos si pretendemos fabricar un dispositivo de manera secuencial. Por desgracia la «paralelización» de muchas de las técnicas que vamos a describir en este capítulo está en entredicho. Ésta es una de las causas por las que muchas de ellas se encuentran actualmente en un estadio de uso en laboratorio, ya que el escalado industrial para poder aplicarlas en paralelo y poder generar nanotecnología con ellas es todavía un reto o una asignatura pendiente.

Las técnicas más utilizadas en la nanoescala pueden clasificarse en técnicas de fabricación, de caracterización, de manipulación y microscopías. Cuando se habla de ellas se utiliza un amplio repertorio de siglas para nombrarlas. Normalmente éstas se corresponden con sus iniciales en inglés. Esto, que es muy práctico en el ámbito profesional, puede confundir terriblemente al lector inexperto o principiante. No obstante, debido a su uso tan extendido, utilizaremos esta terminología en los casos más habituales.

3.2. Técnicas de fabricación

Como ya hemos mencionado en el capítulo anterior, las técnicas experimentales de fabricación de nanoestructuras pueden clasificarse como descendentes (top-down) o ascendentes (bottom-up). En sentido metafórico decíamos que las primeras utilizan un cincel para fabricar objetos más pequeños, mientras que las segundas unen los ladrillos o estructuras fundamentales para formar objetos de mayor tamaño. Aunque la nanotecnología propugna el uso de técnicas de fabricación ascendentes, la falta de metodologías para construir de esta manera y la disminución del tamaño de las sondas utilizadas en las técnicas de fabricación descendentes hace que éstas últimas sean actualmente las más empleadas y continúen perfeccionándose.

Entre las técnicas descendentes, destacan las llamadas técnicas litográficas, que pretenden adelgazar el material, perfilándolo hasta su forma final como lo haría un escultor. Es importante hacer notar que por el término litografía entendemos el dibujo en relieve de estructuras sobre la superficie de un material, procedimiento que es diferente al empleado en impresión para reproducir obras de arte y que es conocido con el mismo nombre. En tecnología se parte de un material (en el caso de la fabricación de componentes electrónicos puede ser un disco u oblea de silicio de 10 cm de diámetro) y se utilizan cinceles del tamaño adecuado para tallar o dibujar sobre su superficie los motivos deseados. Así se fabrican los circuitos impresos y los componentes de microelectrónica que son el corazón de todos los ordenadores. Un escultor utilizaría los cinceles más pequeños de los que dispusiese para esculpir los rasgos más delicados. En nanotecnología éstos son esencialmente los haces de fotones (luz), electrones o iones, que están formados por grupos de partículas que viajan juntas como si se tratase de un fino chorro de materia y que son enviados, con alta energía, hacia el bloque de material que se quiere pulir.

Hoy en día se ha disminuido enormemente el tamaño de los haces, llegándose a conseguir de manera rutinaria tamaños muy por debajo de los 50 nm. Recordemos que los tamaños de las estructuras litografiadas para la fabricación de chips son de unos 20 nm y se realizan mediante esta metodología. La ventaja de estas técnicas es que pueden ser integradas fácilmente dentro de las cadenas industriales de producción existentes. El hecho de que tanto los electrones como los iones tengan una carga neta hace que sea posible (y relativamente fácil) su guiado y focalización en un punto de la muestra mediante el uso de campos electromagnéticos. Sin embargo, si se trabaja con fotones ultravioleta (UV) no es sencillo focalizarlos, de manera que se irradia todo el material. En este caso, el patrón que se desea dibujar se transfiere interponiendo entre la sonda y el objeto una máscara de sombra con la geometría adecuada. Así se consiguen fabricar, por ejemplo, estructuras sobre materiales poliméricos con un tamaño inferior a 200 nm.

Los electrones pueden focalizarse de manera fácil y eficiente, es decir, es posible lograr que la punta del cincel sea casi tan fina como queramos; además, como su longitud de onda es muy pequeña, el tamaño de las estructuras litografiadas es muy inferior al obtenido utilizando fotones UV. Aunque los electrones se comportan normalmente como partículas, también presentan características ondulatorias tal como explica la mecánica cuántica, por lo que no debemos extrañarnos de hablar de la longitud de onda de un electrón.

Para muchas aplicaciones en lugar de electrones se utilizan haces de iones, ligeros e inertes, como pueden ser el He++, Li+, Be++. Éstos también se guían y se focalizan con facilidad mediante campos electromagnéticos y presentan la ventaja de que, al tener una masa mucho mayor que la del electrón, erosionan la muestra con mayor facilidad. En general, a las herramientas de fabricación que utilizan haces de iones se las conoce como FIB (del inglés Focused Ion Beam). La resolución máxima que se puede alcanzar utilizando electrones o iones está limitada por varios procesos físicos y es, en la actualidad, inferior a unos 20 nm.

Generalmente el proceso industrial es una combinación de todas estas técnicas. En muchas ocasiones se comienza por el dibujo de una máscara de sombra, con la estructura impresa que queramos obtener. Esta máscara se fabrica mediante litografía de electrones o iones y se usa posteriormente para «revelar» con luz ultravioleta, de manera que, como si se tratase de una imprenta, el dibujo pueda replicarse en materiales poliméricos. El uso de máscaras para escalar la fabricación, conocido como nanoimpresión es una solución de muy bajo coste y alto interés tecnológico.

La desventaja de estas técnicas de fabricación descendentes o litográficas es que necesitan una instrumentación muy precisa y compleja, integrada dentro de equipos de vacío altamente especializados. Además, son procesos lentos y secuenciales, que sólo permiten fabricar una pieza detrás de otra. Sin embargo están muy extendidos entre los grupos de investigación, ya que es una forma sencilla de conseguir estructuras que pueden utilizarse en un laboratorio. En la Figura 3.1 se muestra un curioso ejemplo de estructura conseguida mediante técnicas litográficas.

FIGURA 3.1. Imagen de microscopía electrónica obtenida en el Laboratory of Advanced Science and Technology for Industry and Graduate School of Material Science, Universidad de Hyogo (Japón). El profesor Matsui creó esta estructura tridimensional (nanogimnasio) usando instrumentos del tipo FIB. Está formada por hilos con una anchura de 80 nm cada uno sobre la superficie de un pelo humano.

Tal como se discutió en el capítulo anterior, la adaptación y búsqueda de nuevas técnicas y metodologías para que la aproximación ascendente permita crear nuevas estructuras sigue siendo un reto. Muchas de las técnicas de fabricación ascendente utilizan sencillas metodologías químicas que son adaptadas para cada tipo de material que se quiere obtener, siendo por ello difícil referirse a ellas de manera general. Vamos a centrarnos en las páginas siguientes en describir aquellas que utilizan grandes equipos, como las denominadas PVD (Physical Vapor Deposition), MBE (Molecular Beam Epitaxy) o CVD (Chemical Vapor Deposition) y que permiten fabricar nuevos materiales sobre todo en forma de lámina delgada, con espesores que varían desde una capa atómica hasta 100 nm. La técnica de CVD se basa en la obtención de átomos a partir de la descomposición de las moléculas que forman un gas. Los átomos obtenidos se reordenan en una superficie para formar otro material diferente. Por ejemplo, si queremos producir una capa de carbono amorfo, podemos descomponer el gas metano (CH4) de manera que quede libre el carbono para transferirse a una superficie y formar una capa. Cuando estas técnicas se utilizan para fabricar láminas con espesores de pocos átomos se necesitan ambientes muy limpios para evitar que el oxígeno o el nitrógeno atmosférico se incorporen a la película. Por tanto estos procesos deben realizarse en complejos entornos de alto y ultraalto vacío (UHV, Ultra High Vacuum), según la pureza que se desee obtener en la capa. En las técnicas de PVD o MBE los átomos que forman la capa no se obtienen de la descomposición de un gas, sino que directamente se subliman desde un volumen grande de un material. Por ejemplo, se pueden evaporar unos pocos átomos de la superficie de un trozo de hierro sobre otro material, de manera que se genere una pequeña lámina delgada de hierro que lo cubra y le aporte nuevas propiedades magnéticas debido a su espesor reducido.

Un ejemplo de material que se ha obtenido empleando diversas metodologías, algunas de ellas anteriormente citadas, es el grafeno. El grafeno fue aislado por primera vez mediante un procedimiento muy rudimentario que consistía en pegar una cinta adhesiva sobre la superficie de un trozo de grafito y posteriormente tirar para arrancarla. Puesto que el grafito está formado por láminas de grafeno débilmente unidas entre sí, este método separa unas capas de otras. Repitiendo el proceso indefinidamente, al final, se llega a obtener una sola capa de átomos, prácticamente inapreciable a simple vista. Sin embargo, esta metodología, que da un resultado excepcional en el laboratorio por su bajo coste, presenta un grave inconveniente para la producción industrial debido a que es una metodología difícilmente escalable. Así comenzó la búsqueda de nuevos métodos de preparación. Uno de estos nuevos procedimientos consiste en utilizar métodos químicos para alejar los planos atómicos de grafito unos de otros, de manera que en el proceso de expansión algunos planos atómicos lleguen a separarse. El número de métodos de preparación, físicos o químicos, de capas de grafeno es enorme. De todos ellos, el que mejor resultado está dando es el de descomponer gases (normalmente hidrocarburos, como acetileno) mediante CVD. En este caso, el grafeno se forma gracias a las propiedades catalíticas de ciertos metales que ayudan a descomponer la molécula de acetileno (C2H2) en sus átomos de carbono constituyentes. Éstos, una vez en la superficie del metal se encuentran y recombinan entre ellos para formar grafeno. Posteriormente, mediante un ataque químico se disuelve el metal que ha servido de soporte, obteniéndose así una lámina aislada que flota sobre la disolución. Mediante esta metodología, se ha conseguido crear láminas puras de grafeno en extensiones suficientemente grandes como para ser utilizadas en la fabricación de pantallas planas y táctiles.

FIGURA 3.2. Fotografía de un equipo de ultraalto vacío utilizado para crecimiento MBE. Imagen tomada en el Departamento de Instrumentación del Centro de Astrobiología (CSIC-INTA).

Por último, no debemos acabar esta sección sin mencionar las técnicas de autoensamblado molecular. Aunque las estructuras que podemos conseguir con ellas se mostrarán en el Capítulo 6, para introducirlas diremos aquí que utilizan la propia capacidad de reconocimiento que tienen las moléculas estableciendo enlaces no covalentes (por ejemplo, puentes de hidrógeno) entre sí, y ensamblándose hasta formar compuestos superiores o capas ordenadas sobre superficies. El control sobre estos procesos de autoensamblado es un camino importante para la aproximación ascendente y para la implantación de la nanotecnología.

3.3. Técnicas de microscopía

Aunque una parte importante de la sociedad todavía asocia el término nanotecnología únicamente a los nanorrobots, hay ya muchas personas que relacionan esta palabra con imágenes de átomos y moléculas sobre superficies, formando fantásticos paisajes del nanomundo. Estas imágenes han sido tomadas con las llamadas microscopías de campo cercano, a las que se ha llamado los ojos de la nanotecnología.

Se puede afirmar que fue la invención del microscopio de efecto túnel, o STM, lo que sugirió que las ideas de Feynman eran correctas y que realmente los átomos eran los ladrillos más pequeños que estaban a nuestro alcance. El llamado efecto túnel tiene su origen en una propiedad muy básica de la materia que emana de las ecuaciones fundamentales de la mecánica cuántica. Gracias a este efecto, un electrón puede atravesar una barrera de potencial. Esta afirmación puede no sorprendernos, pero es algo así como si un hombre pudiese cambiar de un valle a otro de los Alpes de manera instantánea y sin pasar por la cumbre. Es curioso cómo una idea aparentemente tan abstracta, derivada de complejas ecuaciones de la mecánica cuántica, pudo concretarse en un aparato simple que permitió ver la superficie de los materiales con una resolución sin precedentes. La primera vez que se utilizó este microscopio para visualizar escalones de un solo átomo de altura en una muestra de oro o las posiciones de los átomos de silicio en una superficie fue algo tan increíble para el mundo académico que muchos investigadores se negaban a creer que realmente fuese así o que la técnica pudiese desarrollarse aún más. Sin embargo, su extraordinaria sencillez, su tamaño tan reducido y su capacidad para trabajar en cualquier ambiente han convertido esta técnica en un referente actual.

Las imágenes obtenidas con un microscopio tipo STM nos muestran multitud de paisajes atómicos de extraordinaria belleza, que nos cuesta comprender en su totalidad. Para que nos hagamos a la idea de lo que supone en realidad ver un átomo, tenemos que pensar que el nivel de amplificación necesario es similar al que necesitaríamos para, sentados en la Luna, con un aparato mirar a la Tierra y ver los tornillos de la Torre Eiffel. O al revés, como si dispusiésemos de un telescopio que desde la Tierra nos mostrase el mástil de la bandera que dejó el Apolo XI sobre la superficie lunar.

FIGURA 3.3. Paisaje molecular. Imagen tomada con un STM que muestra moléculas orgánicas autorganizadas sobre una superficie. Estas capas pueden ser los constituyentes principales de nuevos dispositivos electrónicos, más rápidos y flexibles que los actuales, basados en silicio. Gentileza del grupo de investigación ESISNA (ICMM-CSIC).

Con el nombre genérico de SPM (del inglés Scanning Probe Microscope, microscopía de campo cercano), se conoce no sólo al STM, sino a toda una serie de técnicas similares entre las que podemos destacar el AFM (Atomic Force Microscope). Todas ellas se basan en la misma idea: una punta afiladísima se «pasea» por la superficie de un material, siendo capaz de «sentir» su morfología. Esta metodología tan simple permite, sin embargo, obtener resultados asombrosos, ya que si la punta acaba en un solo átomo puede llegar a sentir los átomos de los materiales. Es como si pasásemos a ciegas un dedo por el teclado de un piano y tratásemos de adivinar cómo son y dónde están situadas las diferentes teclas; o dicho de otra forma, como si interpretásemos el mundo que nos rodea leyendo en lenguaje Braille. De esa misma manera, midiendo las subidas y bajadas que realiza una punta al pasearse sobre la superficie de un material, es posible visualizar la forma de los átomos o nanobjetos que encuentra en su camino.

Como ya se ha comentado, la punta (sonda de las técnicas SPM) debe ser del tamaño de los objetos que se deseen detectar. Si queremos ver átomos debería acabar en un solo átomo, como es el caso del STM. Si la punta es más amplia o roma y acaba, no en uno sino en un grupo de átomos, como en el caso del AFM, la resolución es menor y en lugar de átomos podemos estudiar nanopartículas, macromoléculas o cualquier nanobjeto de ese tamaño.

La forma de producir estos «dedos» o sondas tan afiladas es muy curiosa. La punta en el STM es un trozo de hilo metálico que se afila por métodos electroquímicos hasta conseguir que acabe en un solo átomo. Este proceso, aparentemente complicado, es en realidad muy sencillo y poco costoso, aunque a su vez incontrolado e impredecible (unas veces acaba en un átomo, otras no). En el caso del AFM la punta consiste en una pirámide de un material (normalmente silicio) que es fabricada, combinando técnicas litográficas y ataque químico, directamente sobre una plataforma similar a los trampolines que se utilizan en las piscinas. Imaginemos una plataforma de un trampolín en cuyo extremo hay un saltador agarrado a la parte inferior, y que la palanca oscila como si quisiese librarse de él. Ese saltador sería la punta (ver Figura 3.4). De manera análoga, la punta del AFM está montada sobre una palanca rígida (conocida como micropalanca o por su nombre inglés cantilever) de dimensiones aproximadas de 120 μm × 40 μm × 5 μm, que al estar sujeta por un extremo puede oscilar verticalmente hasta 20 nm (figura 3.4).

Como curiosidad, si aumentamos proporcionalmente estos valores escalándolos hasta los de un típico trampolín de salto olímpico, vemos que la relación longitud/espesor es similar.

FIGURA 3.4. Fotografías de microscopía electrónica de barrido de una punta hecha de wolframio y afilada electroquímicamente para utilizarse en un microscopio STM (izquierda) y de una micropalanca de un AFM (derecha). Las líneas de escala en las imágenes son 200 μm (izquierda) y 20 μm (derecha).

Una vez que sabemos cómo fabricar una punta afilada nos surge otra pregunta para entender el funcionamiento de estas técnicas: ¿cómo es posible desplazar la punta con la precisión lateral necesaria para ver un único átomo? Para ello la punta debe moverse en intervalos mucho más pequeños que la distancia interatómica. Muchos ingenieros podrían sorprenderse al saber que se puede mover un objeto con una precisión superior a 0,1 Å (0,01 nm). La solución es relativamente simple y consiste en sujetar la punta a unos tubitos construidos de materiales piezoeléctricos. Estos materiales tienen la propiedad de que al aplicar un voltaje determinado se estiran o se encojen una cierta longitud y, como la punta va unida a uno de ellos, se desplaza esa misma cantidad. Los valores típicos del movimiento de la punta son del orden de 0,1 nm por voltio, es decir, aplicando un voltaje se coloca la punta sobre un átomo y aumentándolo en un voltio la movemos hasta el átomo vecino. Hoy en día las fuentes de alimentación se pueden construir con una precisión y estabilidad asombrosas y, por tanto, podremos posicionarnos sobre una superficie con precisión atómica. Se puede afirmar que, al igual que en una factoría de vehículos un brazo robotizado es capaz de moverse en las tres dimensiones del espacio con una precisión milimétrica, en los laboratorios los investigadores son capaces de mover las puntas y palancas de estos microscopios con precisión subatómica.

En un microscopio SPM se desplaza la punta por la superficie midiendo la interacción (corriente eléctrica, fuerza…) entre ambas y mediante un sistema electrónico, que permita subir y bajar la punta, se sigue la topografía de la superficie. La metodología que utilizan estos microscopios para funcionar es algo así como sobrevolar un paisaje con un helicóptero manteniendo una altura constante. El movimiento vertical, arriba y abajo, que debería realizar el helicóptero para conservar fija la distancia al suelo, corresponde con una línea del perfil de la topografía.

La microscopía electrónica había sido hasta el boom de los SPMs la técnica microscópica más importante y extendida entre la comunidad científica. De hecho, prácticamente todos los centros de investigación relacionados con el área de materiales o biología cuentan con algún tipo de microscopio electrónico. Sin embargo, en la actualidad esta tendencia se va tornando a favor de los microscopios de campo cercano. Es indudable que los SPMs ofrecen una serie de ventajas que los hacen imbatibles de una manera global. Por ejemplo: su precio. Hasta cincuenta veces más baratos que un microscopio electrónico. Además, los SPMs pueden trabajar en cualquier ambiente: en líquidos, en vacío o en aire. El hecho de poder estudiar objetos en el interior de una celda líquida, utilizando por ejemplo condiciones fisiológicas, ha convertido a estas técnicas en una herramienta única en biología. Los microscopios electrónicos requieren introducir la muestra en vacío, teñirla o recubrirla de una capa metálica y someterla a una elevada irradiación electrónica, tratamientos que sin duda alteran la morfología o integridad del material estudiado. Por último, es importante destacar que, mientras que en las imágenes de microscopía electrónica la altura de un objeto no tiene un valor determinado ya que se corresponde con cambios de contraste en la imagen, en los SPMs esta cantidad tiene un valor absoluto. Recordemos que éstos producen la imagen mediante el movimiento vertical de la punta que «sobrevuela» un objeto muy cerca de su superficie a una distancia constante. La altura del objeto no es más que lo que ha tenido que subir o bajar la punta para pasar por encima de él, sin variar su distancia a la superficie.

En honor a la verdad, no todo son ventajas en el mundo de los SPMs, sino que también presentan algunos inconvenientes o aspectos que tienen que mejorarse en los nuevos diseños. Uno de ellos es la dificultad para situar la punta en una zona concreta con precisión o para encontrar una zona particular de la muestra en estudio a partir de un punto que se reconozca a simple vista. Pensemos que encontrar una nanoestructura cuadrada de 10 nm de lado sobre la superficie de un material de 1 mm × 1 mm es como encontrar una motocicleta en un desierto del tamaño de la provincia de Cáceres. En este sentido, la facilidad con la que los microscopios electrónicos lo consiguen es inmejorable. La punta es la segunda desventaja de estas técnicas, principalmente en el caso del STM, donde ésta debe acabar en un solo átomo y ser estable. Hoy en día la punta es el talón de Aquiles de los SPMs, ya que es un factor verdaderamente incontrolado e impredecible, pues fácilmente puede perderse ese átomo durante la medida o también puede adherírsele otro proveniente de la superficie o del gas residual (sobre todo cuando se toman imágenes de moléculas orgánicas). Estos procesos dan lugar a pérdidas y cambios bruscos en la resolución durante el proceso de medida. Un problema que aparece frecuentemente durante la adquisición de imágenes es la aparición de puntas dobles, que generan dos (o varias) imágenes superpuestas.

De todo esto se deduce que el verdadero caballo de batalla de estas técnicas es la fragilidad y la forma incontrolada de las puntas. Ante este problema, el AFM se ha especializado en entornos en los que no se requiere tanta resolución lateral, es decir, el AFM renuncia a obtener imágenes con resolución atómica para poder trabajar con puntas más anchas que le permitan tener una mayor estabilidad. Esta facilidad del AFM para estudiar distintos entornos de manera estable es la responsable de que se haya convertido en pocos años en una herramienta muy importante en ciencia de materiales o en biología. En el caso del STM, puesto que la resolución máxima depende de la forma de la punta, se están realizado experimentos que consistan en depositar átomos o moléculas simples de manera controlada sobre la punta, como hidrógeno o monóxido de carbono (CO). De esta manera los investigadores pueden estar seguros de que la punta acaba en un solo átomo, y saber cuál es ese átomo. Las imágenes obtenidas por algunos grupos de investigación con esta metodología son verdaderamente impresionantes.

Una característica de estas técnicas, principalmente del AFM, es la capacidad de realizar un trabajo en un punto muy específico, por ejemplo, mediante la aplicación de fuerza (apretando) sobre un átomo, una molécula o una proteína concreta, de manera controlada y, a la vez, midiendo el valor de esa fuerza. Este tipo de experimentos nos permite obtener un mapa de las propiedades elásticas de los objetos que nos encontramos en el nanomundo. Además, la punta puede funcionalizarse, es decir, modificarse con la inclusión de ciertas moléculas para que reaccionen con otras en la superficie y medir el valor de las fuerzas involucradas. Como veremos en el siguiente apartado, la funcionalización de la punta ha abierto un nuevo camino a la manipulación en la nanoescala.

En el campo de la microscopía de alta resolución (aunque sería mejor hablar de nanoscopía) cabe destacar que en los últimos años se han desarrollado enormemente las capacidades de los microscopios de transmisión electrónica (TEM, del inglés Transmission Electron Microscope), mediante el uso de complejos y carísimos instrumentos en los que los electrones se aceleran hasta 400 kV dentro de tubos de vacío de varios metros de longitud. Estas enormes energías hacen que la longitud de onda de los electrones sea muy pequeña, alcanzándose mayor resolución. Esto ha permitido observar con gran nitidez los átomos de algunos materiales. Estos microscopios, debido a su elevadísimo coste, se utilizan como grandes instalaciones abiertas a cualquier usuario que tenga un proyecto de investigación interesante. En estos momentos España cuenta con media docena de estos microscopios que son considerados como infraestructuras científico-técnicas singulares.

3.4. Técnicas de caracterización

Desde que M. Laue, a principios del siglo XX, realizó los primeros diagramas de difracción de rayos X, se conoce la disposición de los átomos en el interior de muchos materiales cristalinos. Sin embargo, hasta hace muy pocos años no se ha podido conseguir difracción que provenga exclusivamente de la última capa atómica de un material. La dificultad se debe a que en la superficie hay varios millones de veces menos átomos que en el interior y, por tanto, las técnicas experimentales no tenían suficiente sensibilidad como para obtener una señal clara y exclusiva de la superficie.

El estudio experimental de las superficies a nivel atómico comenzó en los años setenta mediante técnicas normalmente basadas en el uso de electrones o iones, ya que al no penetrar mucho en los materiales ofrecen al investigador una información esencialmente superficial. El hecho de que estas técnicas surgiesen en los años setenta no es fruto del azar, sino que hubo que esperar a disponer de tecnologías avanzadas de ultra alto vacío (UHV) para poder confinar, enviar y detectar electrones sin que fuesen aniquilados por el gas atmosférico. De nuevo, nos encontramos ante avances científicos que vienen motivados por desarrollos tecnológicos.

Las técnicas de caracterización, al igual que las de fabricación, se pueden clasificar según el tipo de sonda que utilicen. Así se pueden dividir en las que envían fotones (como la fotoemisión, la difracción o el Raman), electrones (como el Auger) o iones (como la dispersión de iones). La sonda interacciona con la superficie y como fruto de esa interacción se recogen los electrones, iones o fotones resultantes del proceso. Estas técnicas son tantas y tan especializadas que una descripción profunda de las mismas excede las posibilidades de este libro. Durante los últimos años se han perfeccionado, de manera que hoy pueden llegar a detectar del orden de una milésima de monocapa, es decir, aproximadamente unos 1012 átomos por cm2. Aunque este número pudiese parecer alto, debemos tener en cuenta que en 1 cm3 de un material hay aproximadamente 1023 átomos y que, en realidad, una milésima de monocapa equivale a unos pocos átomos desperdigados sobre una superficie.

En los últimos años se ha producido un avance importante al desarrollarse una serie de técnicas que combinan la caracterización con la microscopía, pues esta última sólo nos informa sobre la forma de los objetos, pero no sobre su composición química; es decir, no nos dice de qué están hechos. Actualmente existen microscopios de fotoemisión, o microscopios Raman, que nos indican dónde se encuentra cada elemento químico sobre la topografía de un material. Un ejemplo lo tenemos en la Figura 3.5 donde se puede apreciar que la micropalanca de AFM está fabricada de silicio y no contiene nada de carbono.

FIGURA 3.5. Imágenes obtenidas mediante microscopía electrónica de barrido (SEM) de una punta de AFM. La imagen de la izquierda es la topografía, las otras dos son imágenes realizadas recogiendo exclusivamente la señal que proviene del carbono (imagen central) y del silicio (imagen de la derecha).

Muchos son los desarrollos tecnológicos que han ampliado el ámbito de aplicación para el que fueron creados, como es el caso de las palancas de AFM. El uso de estas palancas ha saltado desde el mundo de los SPMs al de los detectores ultrasensibles. Es decir, desde el mundo de la microscopía al de los sensores, pues al depositar algo sobre ellas se deforman ligeramente o cambian sus propiedades mecánicas de manera que se produce un ligero movimiento. Estos movimientos se detectan de una manera muy sencilla: mediante la reflexión de un haz de luz láser sobre su superficie. Si la palanca se comba hacia arriba, la reflexión del láser se desplazará de igual manera. Es como si sobre el extremo de un trampolín se colocase alguien con mucho peso, la plataforma se combaría más que si se colocase alguien más liviano. Midiendo la desviación de la reflexión de un láser en el extremo del trampolín y su constante elástica, podríamos conocer el peso del saltador. En realidad en el mundo nanométrico no se estima el peso sino la interacción entre el objeto y la palanca. Al adsorberse una molécula o nanopartícula se modifica la tensión interna y, como consecuencia, la palanca se comba. Esta estrategia, simple pero muy efectiva, permite detectar cantidades muy pequeñas de una sustancia, como veremos en el Capítulo 7.

Además de estas técnicas de observación específicas de la nanotecnología, cabe citar en este apartado las grandes instalaciones científicas. Los grandes radiotelescopios o los aceleradores de partículas son algunas de las más conocidas por su impacto mediático. Sin embargo, esta categoría es mucho más amplia y también engloba a los aceleradores de iones, los reactores de neutrones y los sincrotrones, que pueden considerarse como un nuevo tipo de microscopios-espectrógrafos gigantes. Podemos definir una gran instalación como un proyecto interdisciplinar y de coste muy elevado, tanto que no es asumible por un solo país o grupo de investigación. Aunque estas instalaciones no se usan exclusivamente para investigaciones derivadas de la nanociencia, éste es sin duda uno de los usos prioritarios y en claro auge. Estas máquinas ofrecen una cantidad ingente de información sobre la estructura de la materia. De entre todas ellas, las que más aplicaciones tienen en nanociencia son las llamadas instalaciones para la producción de radiación sincrotrón (conocidas a secas como sincrotrones). Se puede decir que son herramientas kilométricas para estudiar objetos nanométricos. Por ejemplo, el sincrotrón europeo, llamado ESRF (European Synchrotron Radiation Facility), situado en Grenoble (Francia), tiene una longitud de más de un kilómetro y en su interior contiene más de cincuenta laboratorios para realizar experimentos durante las veinticuatro horas del día. El edificio que lo alberga es mayor que un campo de fútbol. El sincrotrón puede considerarse una fuente de luz enorme y sofisticada. Enorme porque requiere de un acelerador de electrones de grandes dimensiones. Sofisticada porque a través de una compleja instrumentación puede generar luz con alta intensidad de cualquier longitud de onda dentro de un amplio espectro, desde el infrarrojo hasta los rayos gamma. Aunque estas máquinas pueden producir radiación de cualquier energía, la mayor parte de ellas se centran en la producción de rayos X, radiación que es muy difícil de producir por otras técnicas.

La diferencia entre los sincrotrones y los aceleradores de partículas, que son aún más grandes, como el CERN (Centro Europeo de Investigación Nuclear) en Ginebra, es que éstos hacen colisionar las partículas entre sí para conocer su estructura interna, mientras que los sincrotrones intentan que los electrones giren indefinidamente, o por lo menos, el mayor tiempo posible. El motivo es que las partículas cargadas, como los electrones, al describir trayectorias circulares emiten radiación electromagnética que puede ser utilizada por científicos de muy diversas áreas para realizar experimentos. Durante el año 2012 el sincrotrón español, llamado ALBA y situado en Cerdanyola del Vallès (Barcelona), comenzó su fase de explotación abriendo sus puertas a usuarios de todo el mundo. ALBA es otra de las instalaciones científico-técnicas singulares que se han puesto en marcha en nuestro país. De las siete líneas con las que ha arrancado, más de la mitad están de alguna manera relacionadas con la nanociencia.

3.5. Manipulación en la nanoescala

Al poco tiempo de que se comenzaran a obtener imágenes utilizando el microscopio STM para ver cómo se disponían los átomos en las superficies de los materiales, surgió una nueva idea. Como hemos dicho, la punta se acerca mucho al objeto en estudio, tanto que se establece una pequeña interacción entre ambos. Pues bien, los investigadores comenzaron a preguntarse por qué no utilizar esas pequeñas fuerzas que se establecen entre la punta (que acaba en un solo átomo) y la muestra para modificar las posiciones de los átomos que forman ésta última. Es decir, transformar el microscopio en una herramienta para modelar la materia, en los dedos que nos permitan construir un puzle en la nanoescala. Habíamos dicho anteriormente que ver un átomo con un microscopio SPM requiere una amplificación similar a la que se necesita para observar cómo son los tornillos de la Torre Eiffel desde la Luna. Pues bien, ahora vamos a dar un paso más en lo que se llama construcción ascendente al utilizar estos microscopios, no sólo para observar cómo son los tornillos, sino también para apretarlos y aflojarlos a conveniencia.

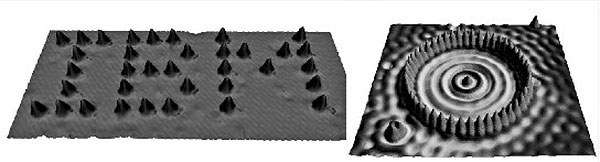

Los primeros en lograr esta hazaña fueron investigadores de la multinacional IBM, en Almaden (EE.UU.), que sorprendieron al mundo en el año 1991 escribiendo con átomos el logotipo de su compañía. El grupo dirigido por D. Eigler fue capaz de colocar 35 átomos de xenón sobre una superficie de níquel. Más tarde, este mismo grupo creó los llamados «corrales cuánticos», átomos colocados formando figuras geométricas cerradas como si fuesen cercas (ver Figura 3.6). Estos experimentos abrieron la puerta a la manipulación atómica y a soñar que verdaderamente era posible cambiar de posición un solo átomo, por ejemplo para escribir con ellos, tal como Feynman había predicho treinta años antes. Desde ese momento, numerosos grupos de investigación fueron aprendiendo y dominando los mecanismos para la manipulación atómica, hasta el punto que escribir con átomos el logotipo de un instituto de investigación o de una universidad ha llegado a ser rutinario cuando se trabaja con un STM a bajas temperaturas.

FIGURA 3.6. Manipulación de átomos mediante STM. La fotografía de la izquierda fue un hito en la historia del STM, ya que por primera vez se manipularon átomos individuales con esta técnica. Para realizar la imagen de la derecha se colocaron 48 átomos formando una estructura circular. Cuando se cierra el círculo atómico, en el interior se forman unos anillos concéntricos que corresponden a interferencias de ondas electrónicas. Imágenes creadas por IBM Research Corporation. <http://researcher-ibm.com/researcher/view_project.php?id=4245>.

Debemos recordar que los inventores del STM, G. Binnig y H. Rohrer, estaban trabajando también para la empresa IBM, en Zúrich (Suiza). Es asombroso cómo en esa época las grandes compañías multinacionales invertían en investigación básica contribuyendo de manera decisiva al avance de la ciencia fundamental. Actualmente este tipo de investigación básica ha desaparecido de las empresas, debido a que la mayor competitividad impuesta por la globalización hace que los recursos se dediquen mayoritariamente a realizar investigaciones mucho más aplicadas.

La difusión de imágenes tan espectaculares, que mostraban la capacidad para interaccionar con los átomos, consiguió crear un ambiente científico propicio para la especulación. Así se comenzó a hablar de escritura atómica y muchos grupos comenzaron a estudiar cómo se podría utilizar esta herramienta para obtener la máxima capacidad de integración posible. Este tipo de escritura permitiría llegar al límite de la miniaturización del almacenamiento magnético actual: por ejemplo, el bit más pequeño que pudiésemos imaginar consistiría en un solo átomo, en el que colocando su «espín» hacia arriba o hacia abajo mediante la punta, almacenase un valor de 1 o 0. El espín es una propiedad cuántica del electrón que puede asociarse a una rotación del mismo sobre su eje y por tanto tiene dos valores izquierda-derecha o bien arriba-abajo. Esta propiedad está en el origen del magnetismo atómico. Otros investigadores estudiaron la posibilidad de construir el cable conductor más pequeño del mundo. Combinando ambas ideas se podrían fabricar los dispositivos más pequeños imaginables: información almacenada digitalmente utilizando un bit por átomo, cables monoatómicos y, por qué no, para realizar la conexión se podrían utilizar nanotubos de carbono que actuarían como material semiconductor.

Sin embargo, esta metodología de ensueño, que consiste en la fabricación de estructuras átomo a átomo, presenta varios problemas prácticos para llegar a convertirse en una tecnología real. Si miramos los seis preceptos del Capítulo 2, veremos que no cumple varios de ellos. En primer lugar se trata de un método secuencial y terriblemente complejo en el que los átomos se colocan formando estructuras estables a temperaturas muy bajas, del orden de unos 4K (aproximadamente −270 °C). Además, deben estar dentro de sistemas de ultra alto vacío (como el que se muestra en la Figura 3.2), con presiones cercanas a las que uno encuentra en el espacio interplanetario. De lo contrario la capa atómica que contiene la información se contaminaría con las moléculas que existen en nuestra atmósfera y se perdería la información. Además, estos nanocables atómicos no pueden transportar corrientes eléctricas, ya que el calor disipado los movería de sitio, alterando de nuevo la información o «rompiendo» el cable. Estos requerimientos técnicos, de vacío y de temperaturas muy bajas, hacen que esta solución no sea la más adecuada para la nanotecnología. Sin embargo, su falta de aplicabilidad no quita mérito a unos experimentos de los que la ciencia ha aprendido mucho sobre la materia a escala atómica y que han sido la base de muchos otros.

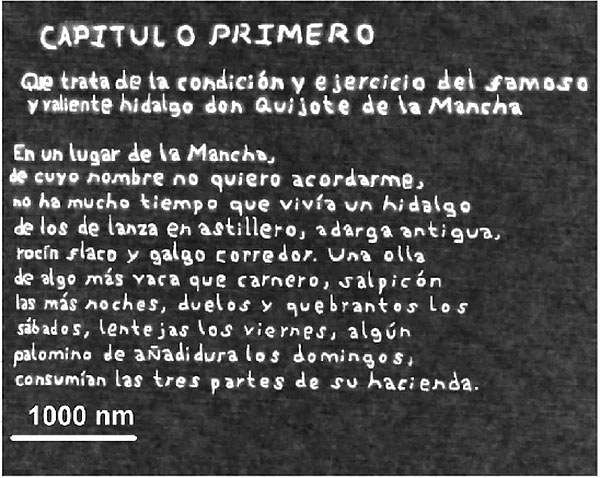

Sin embargo, aumentando un poco el tamaño de la punta y renunciando a manipular un sólo átomo, se pueden conseguir sistemas nanométricos estables, duraderos y baratos, que realmente tengan aplicaciones nanotecnológicas. Todos estos métodos explotan la idea de localidad, es decir la capacidad de la punta para actuar en un punto concreto de una superficie con el objeto de modificarla o estudiarla. Por ejemplo, si bajo la punta creamos un diminuto cuello o menisco de agua (unos nanómetros de ancho) y aplicamos un pequeño voltaje, podemos oxidar localmente esa zona de la superficie. Si mientras llevamos a cabo esta oxidación movemos la punta podríamos llegar a escribir sobre la superficie. Es como si sobre un «papel» de silicio llegásemos a escribir con la punta del AFM trazos hechos de óxido de silicio. En la Figura 3.7 tenemos un fragmento del Quijote escrito con esta técnica por un grupo de investigación español. Con esta capacidad de amplificación podríamos conseguir escribir todo el Quijote en un área equivalente al de la sección de seis pelos humanos. Debemos pensar que, a diferencia de la Figura 3.6, donde cada punto es un átomo, aquí los trazos que forman las letras tienen un ancho de unos 10 nm y, por tanto, una letra está formada por unos 100 000 átomos.

FIGURA 3.7. Mediante el método de oxidación local y empleando un AFM, los investigadores lograron escribir un fragmento de el Quijote utilizando letras con un «tamaño de fuente» de unos 10 nm. Gentileza de R. García (ICMM-CSIC).