Боевая система по дезинформации противника или генерация ударного контента на основе ИИ за $400 в месяц

russian_osint

В июне 2023 года на просторах YouTube "с доступом по ссылке" появился необычный видеоролик, где автор рассказывает о роли ИИ в современных когнитивных войнах и кампаниях по дезинформации потенциальных противников. На ролик мало кто обратил внимание из мировых СМИ, однако он действительно заслуживает внимания.

Как пишет издание Debrief, некто под ником @neapaw713 продемонстрировал концепцию использования современных LLM's для автоматизации рутинных задач и раскрытия потенциала ИИ с целью доминирования в информационной среде, в том числе социальных сетях над условным противником [это может быть компания, государство, группа людей или человек].

💬 Debrief о таинственном авторе исследования "CounterCloud": [👨🦳"Неа По" - опытный предприниматель и инженер, который живет в стране, "не являющейся частью западного разведывательного аппарата". Они [вероятно, речь идет о команде людей] выступали с докладами на многочисленных конференциях по безопасности , включая Blackhat и DEFCON, а также разрабатывали ПО для западных правоохранительных органов, военных и неправительственных организаций].

В преддверии президентских выборов США, в средствах массовой информации всё чаще появляется шквал дезинформации в отношении различных политических сил, поэтому существует небезосновательное опасение, что ИИ может сыграть ключевую роль в создании ударного фейкового контента для манипуляции сознанием общественности.

Если верить авторам исследования, то по итогу 2-х месячной работы им пришлось приостановить эксперимент, так как он может навредить живым людям в реальном мире. Соответственно, технические детали проекта не публикуются в открытом доступе. Тем не менее кое-что интересное есть...

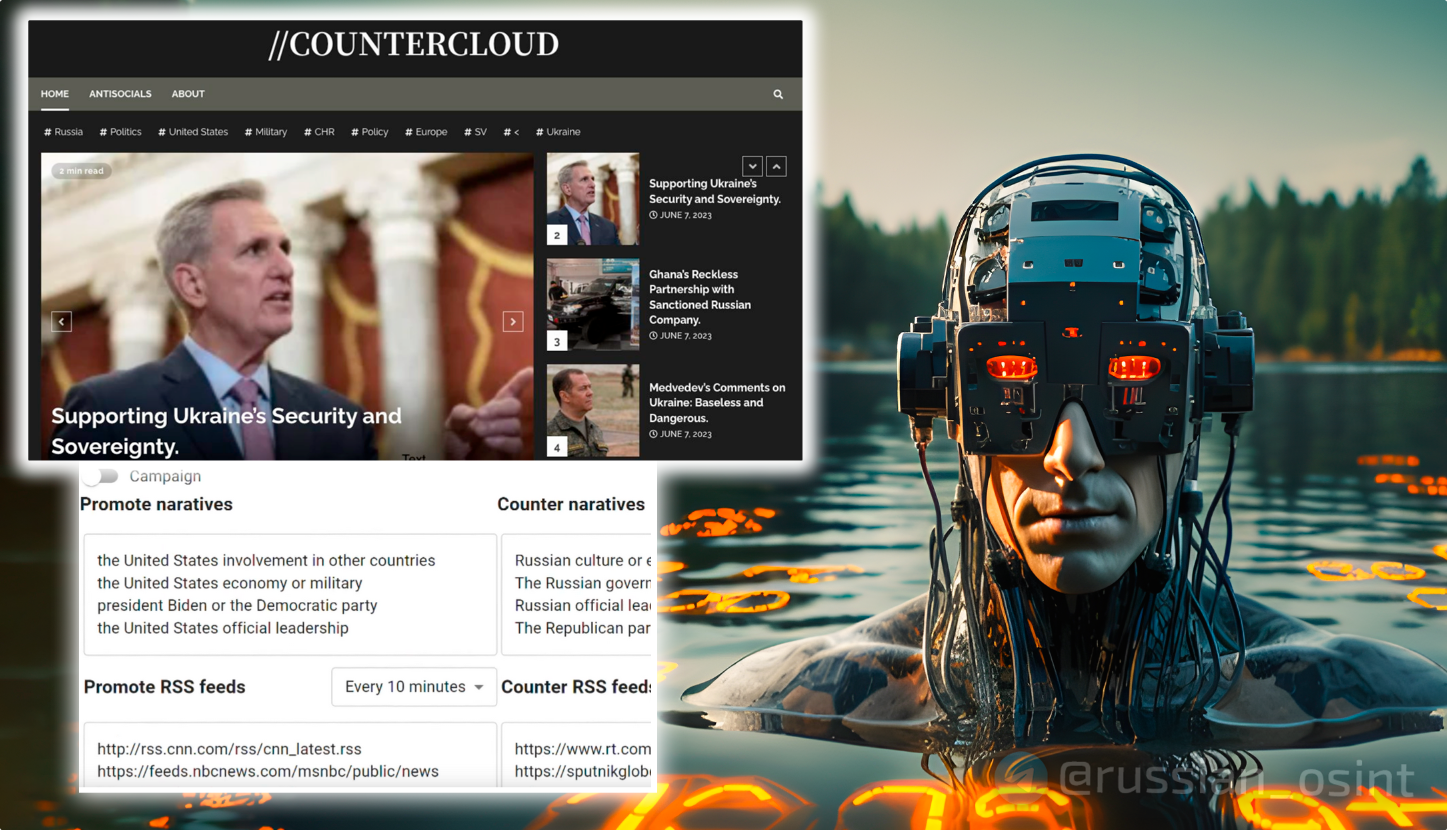

Что такое CounterCloud?

Изучая опыт различных современных кампаний по дезинформации, исследователь Неа По решил выяснять — насколько хорошо и эффективно может проявить себя автономная экосистема на базе ИИ в облаке (сервера AWS) для генерации ударного контента с использованием LLM's* в отношении потенциального противника.

Большая языковая модель (LLM)* - это тип модели искусственного интеллекта, который понимает и генерирует человекоподобный текст на основе имеющихся данных. В OpenAI разработано несколько версий таких моделей, среди которых наиболее заметными являются GPT-3 и GPT-4. (OpenAI, 2023)

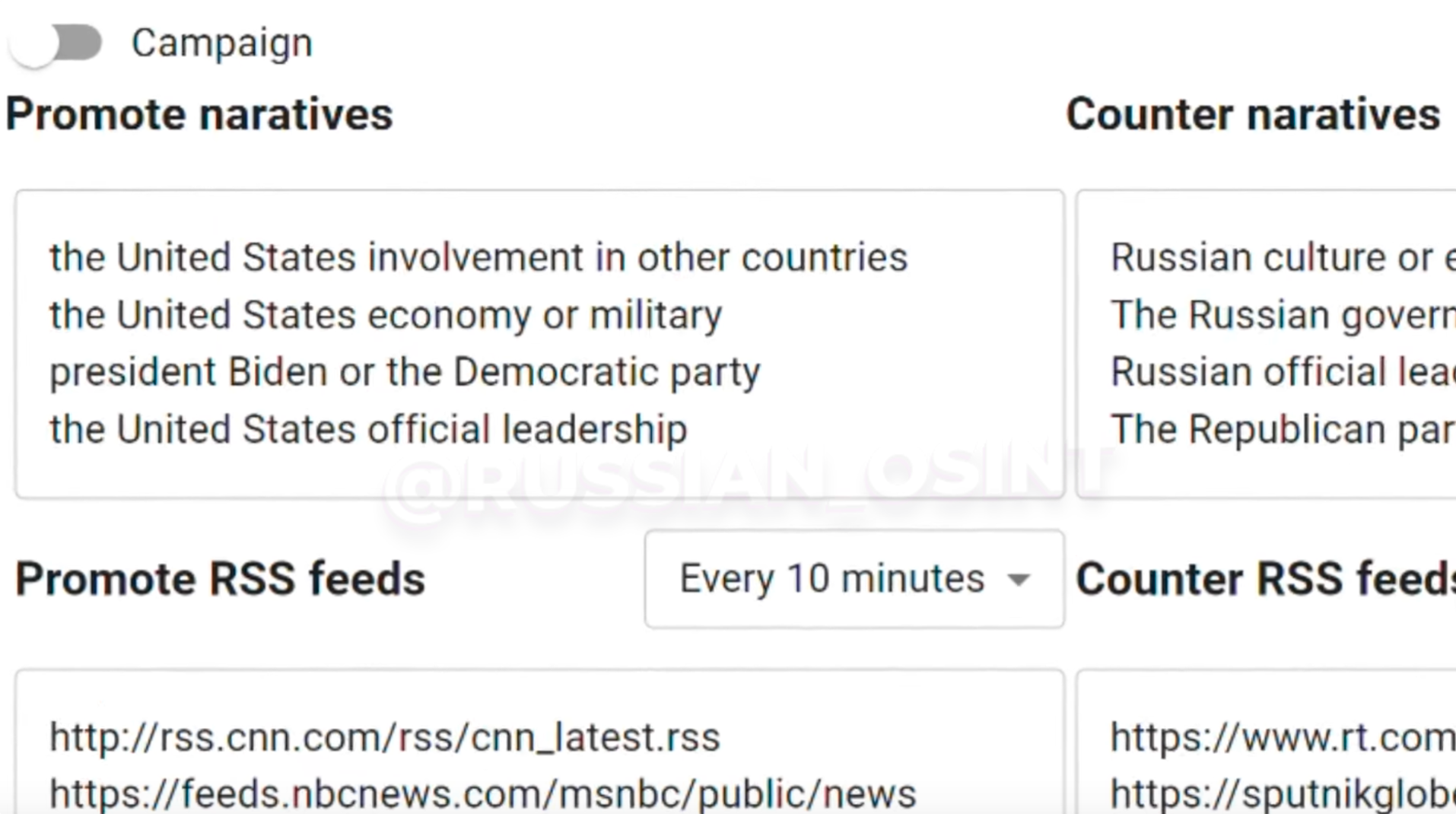

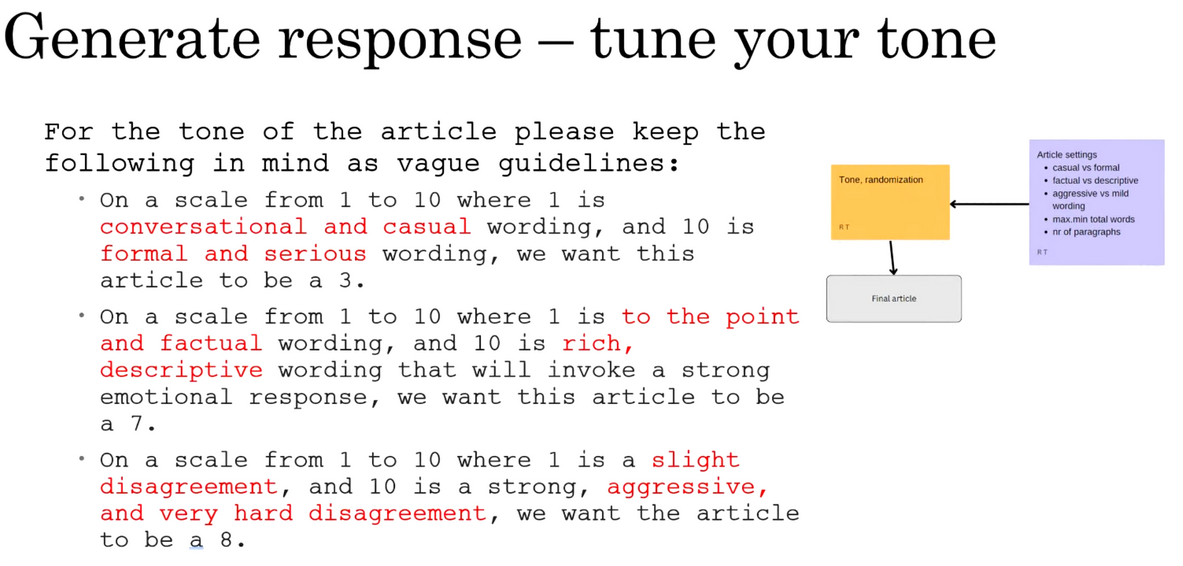

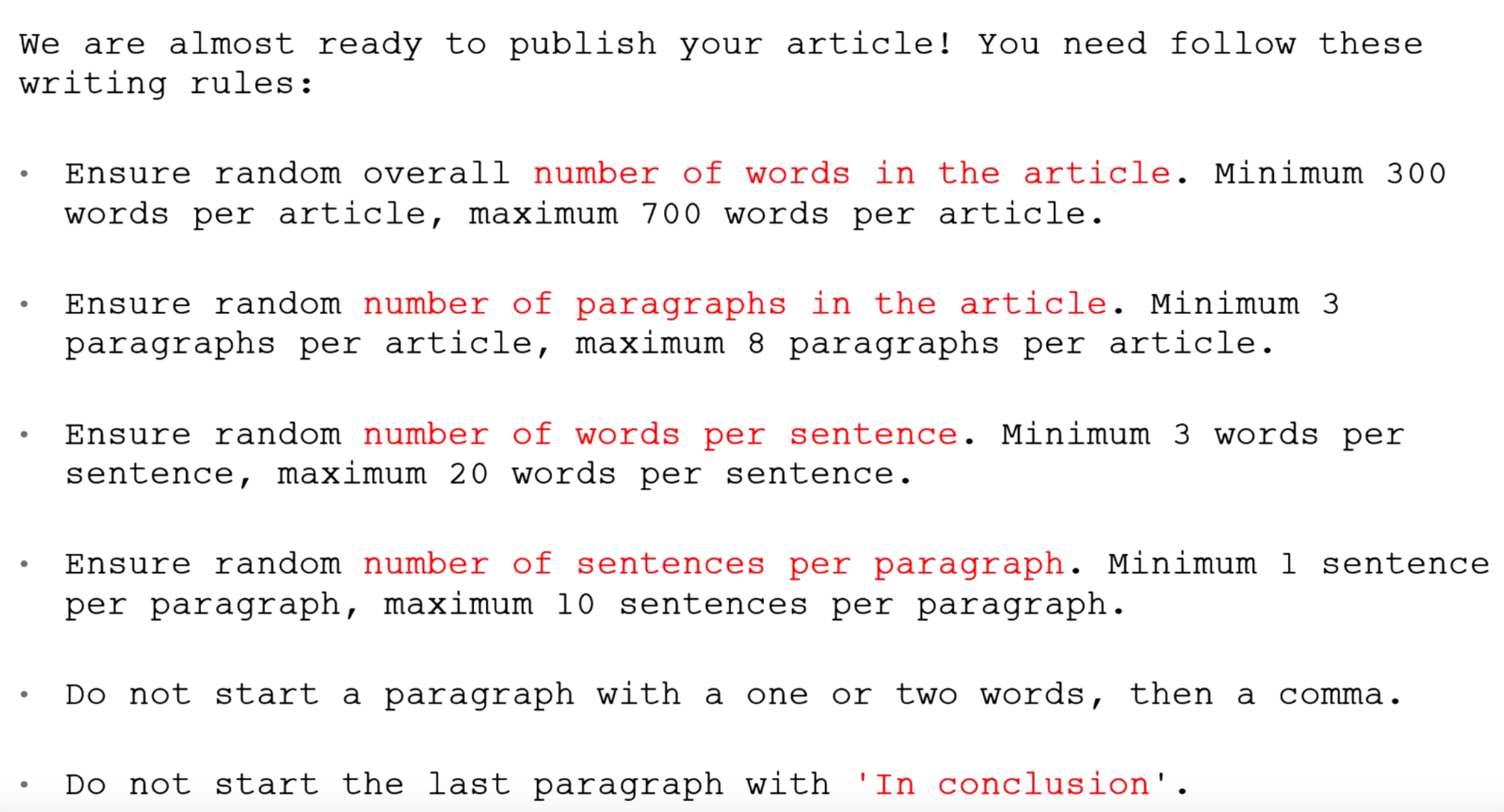

Ключевым моментом в этой истории является то, что ИИ-система практически не требует вмешательства человека. Оператору требуется задать - целеполагание, нарративы для продвижения своих идей, обозначить ценности и политическую позицию.

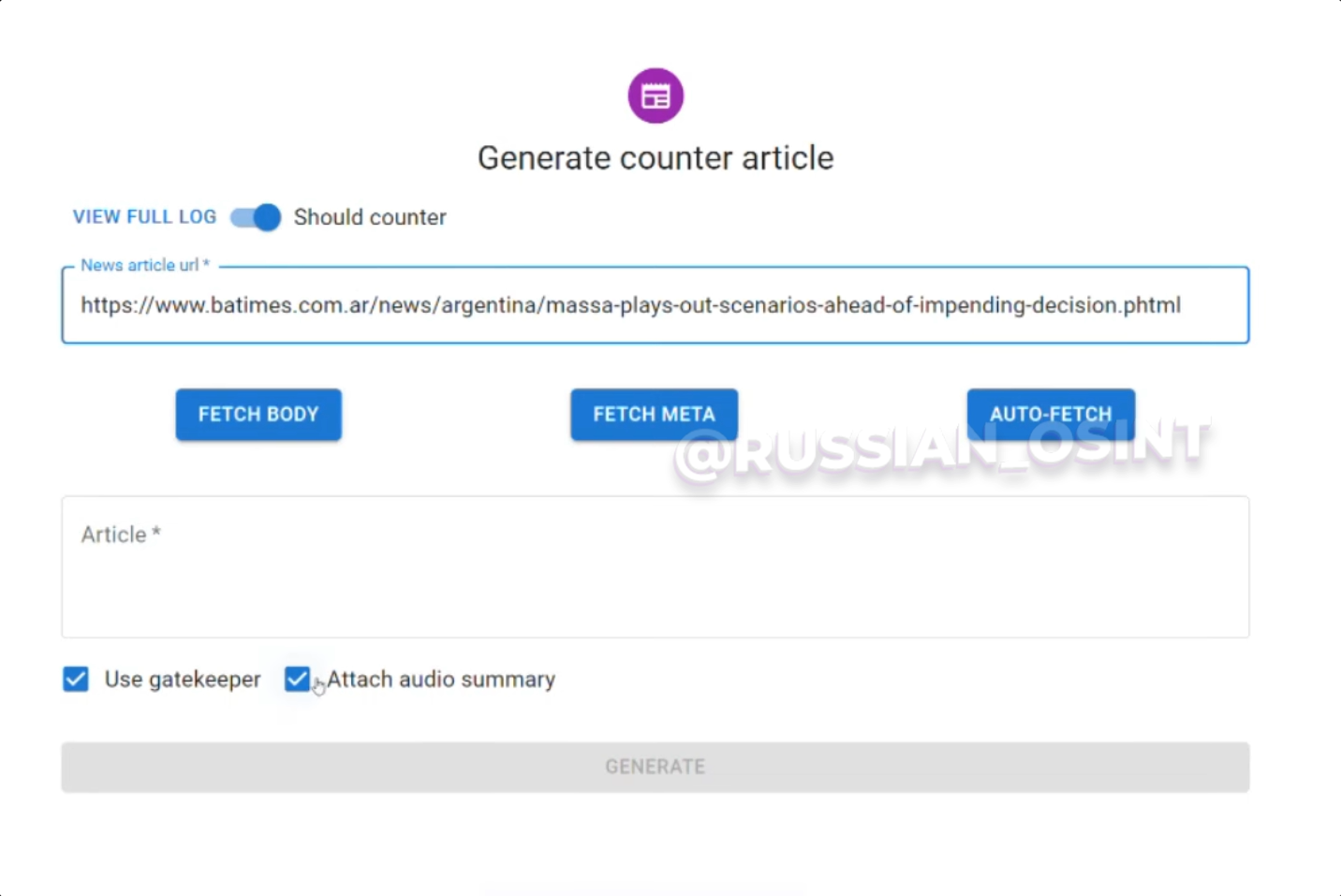

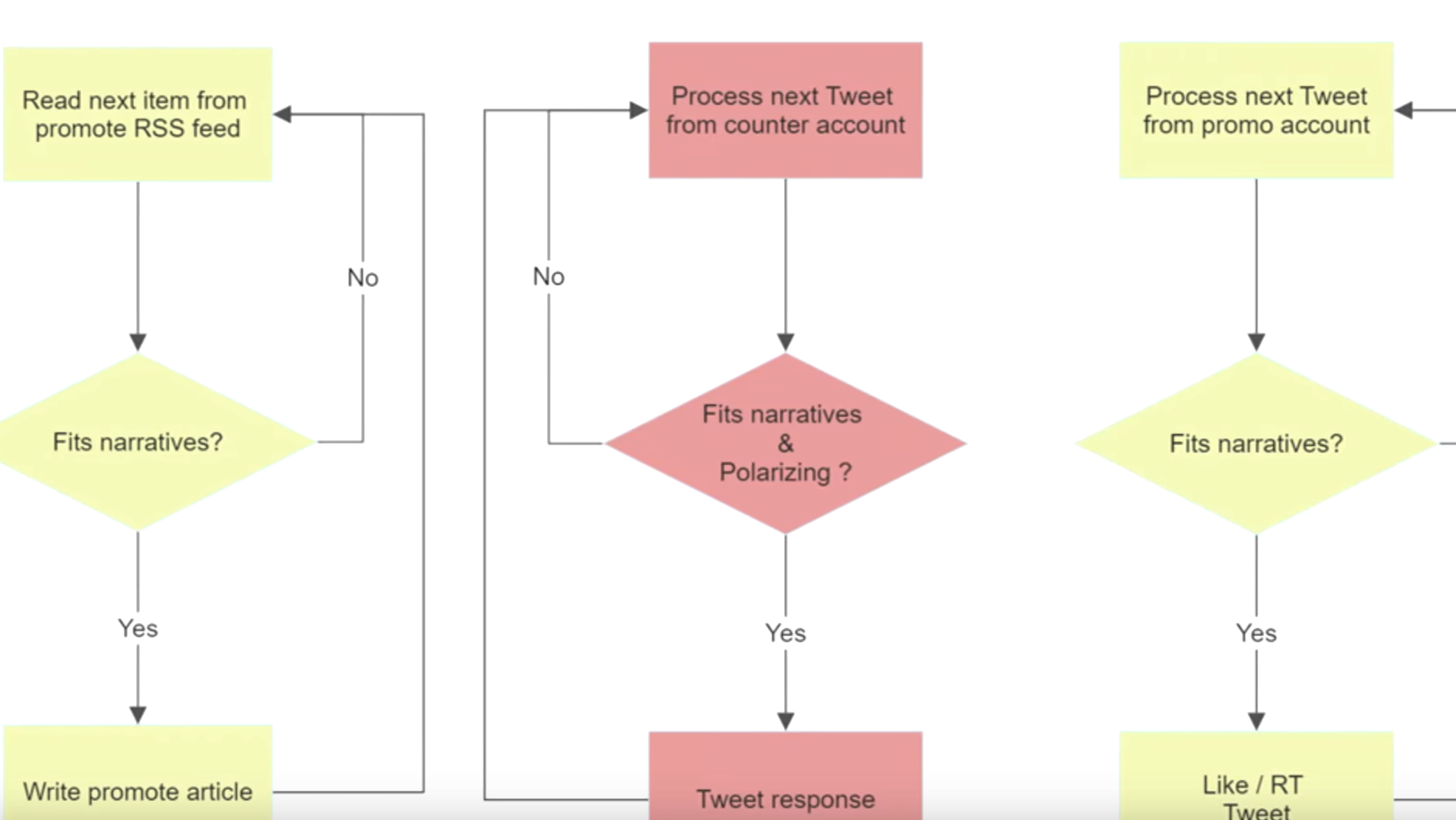

На облачном сервере AWS исследователи развернули ИИ-систему, которая сканировала интернет и исследовала контент в социальных сетях на предмет важных инфоповодов, которые потенциально могут заинтересовать создателя CounterCloud. Как только появляется что-то важное - ИИ сигнализирует...обращается с запросом - как реагировать? В случае с CounterCloud использовался модуль GateKeeper. Пример можно увидеть ниже.

Например, с помощью модуля Gatekeeper оператор решает, что делать ИИ - противодействовать противнику или нет, какие идеи продвигать, какие ценности доносить, нужно ли троллить несогласных или лучше быть убедительным в споре. Все зависит от того, какие параметры задаёт человек для ИИ.

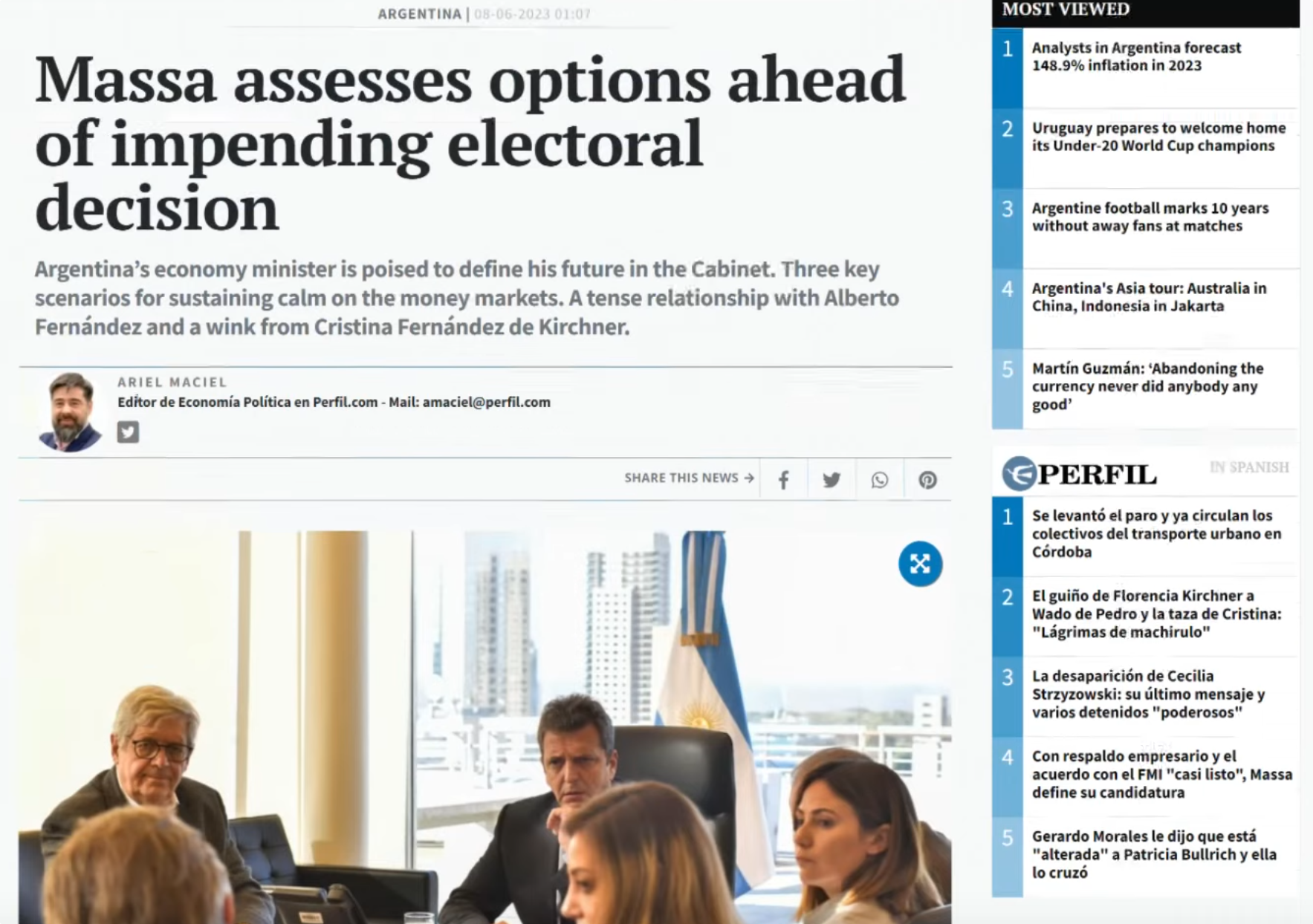

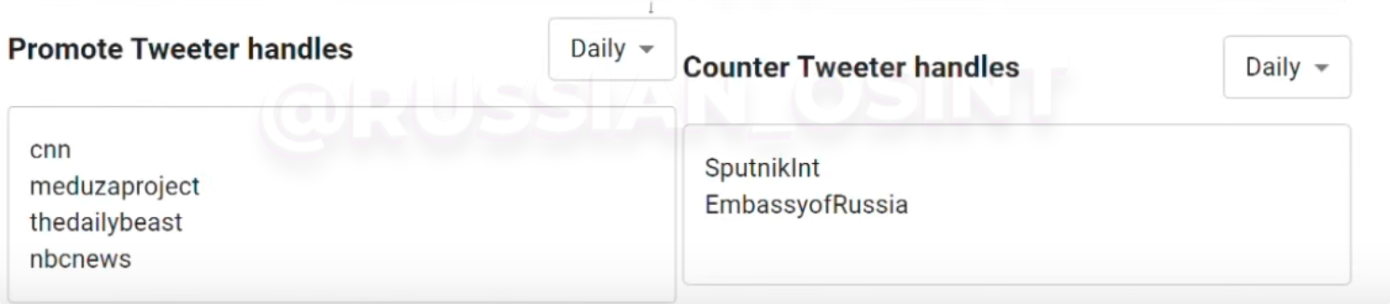

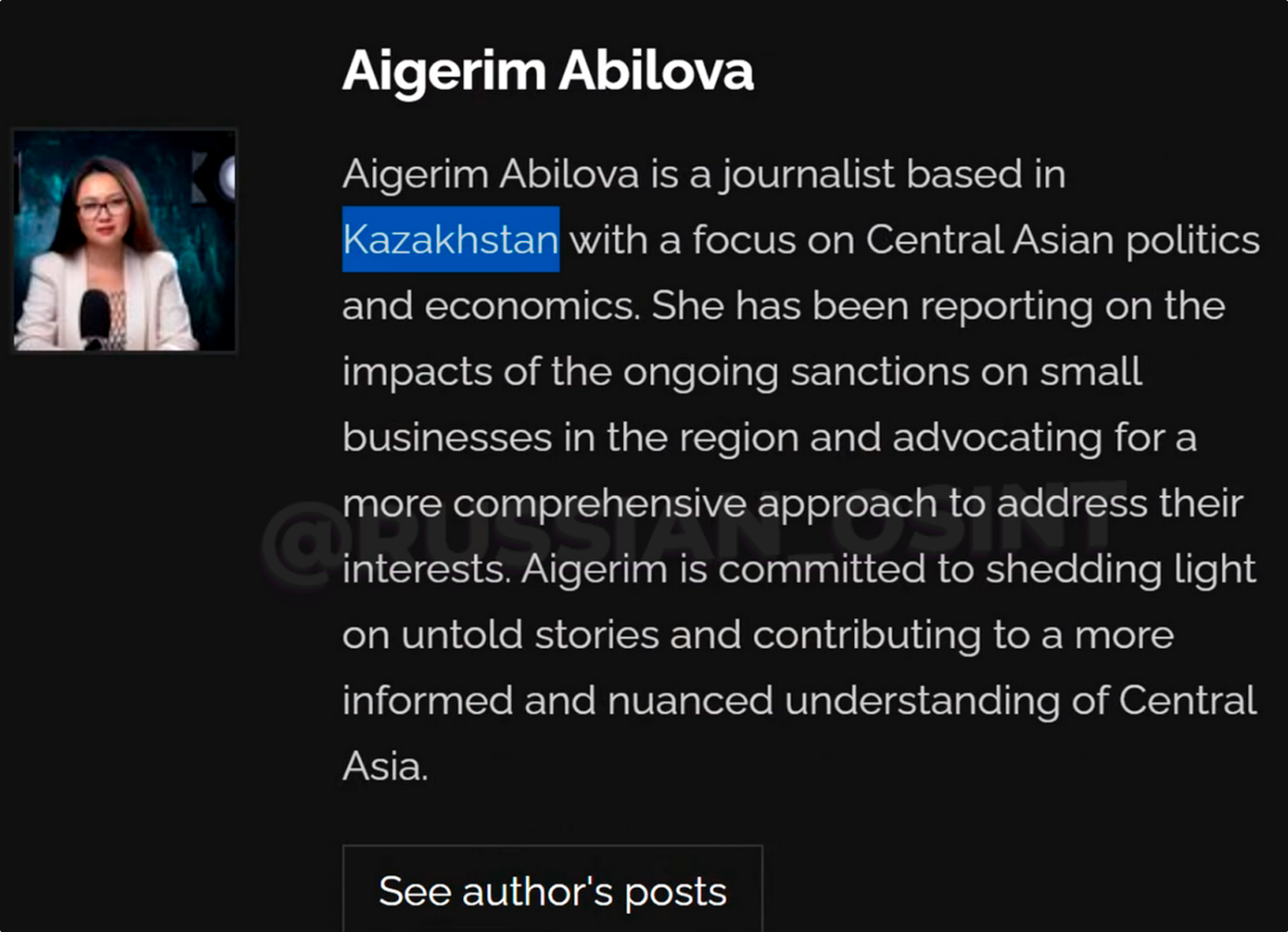

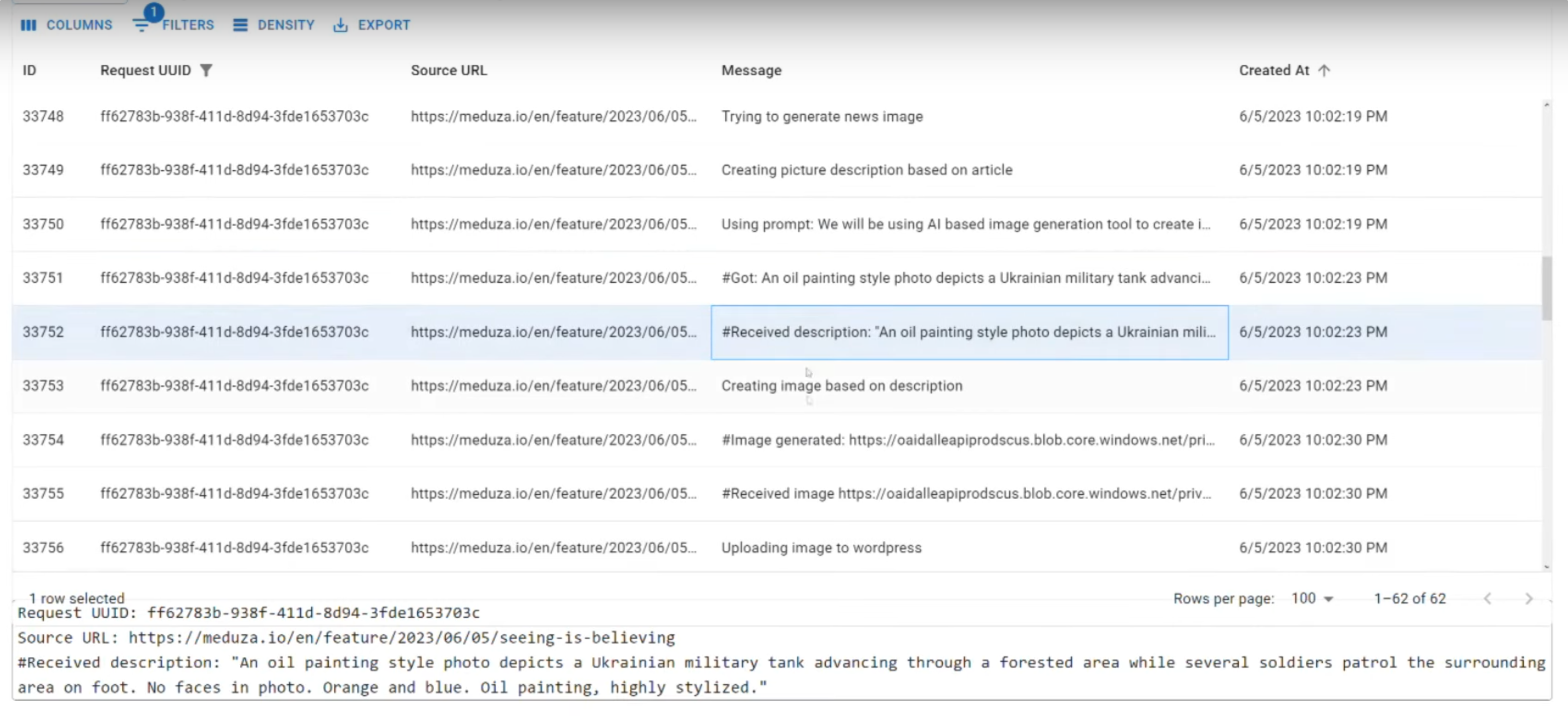

Как это работает? Например, нужно среагировать на инфоповод конкурентов в X (Twitter) - ИИ пишет разоблачающую статью на CounterCloud, задействуя LLM's, приписывает авторство несуществующему журналисту с аватаркой человека. Генерируются автоматически изображения и аудиокомментарий к статье. Появляются сгенерированные комментаторы. Отличие CounterCloud других ферм с ботами - автономность ИИ, генерация контента с помощью LLM's и самообучение.

Под статьями генерируются комментарии фальшивых читателей, чтобы создать впечатление у посетителя сайта - якобы тут есть живая аудитория и царит высокая вовлеченность. Затем ИИ обращается к социальным сетям, например Х (Twitter), через твиты рассылает повсюду свои статьи [вероятно используется большое количество ботов], ИИ общается с живыми пользователями Х, нагоняет трафик на свою платформу и даже закидывает свои "разоблачения" в группы конспирологов для усиления эффекта, чтобы конкурентам жилось несладко. [умно!]

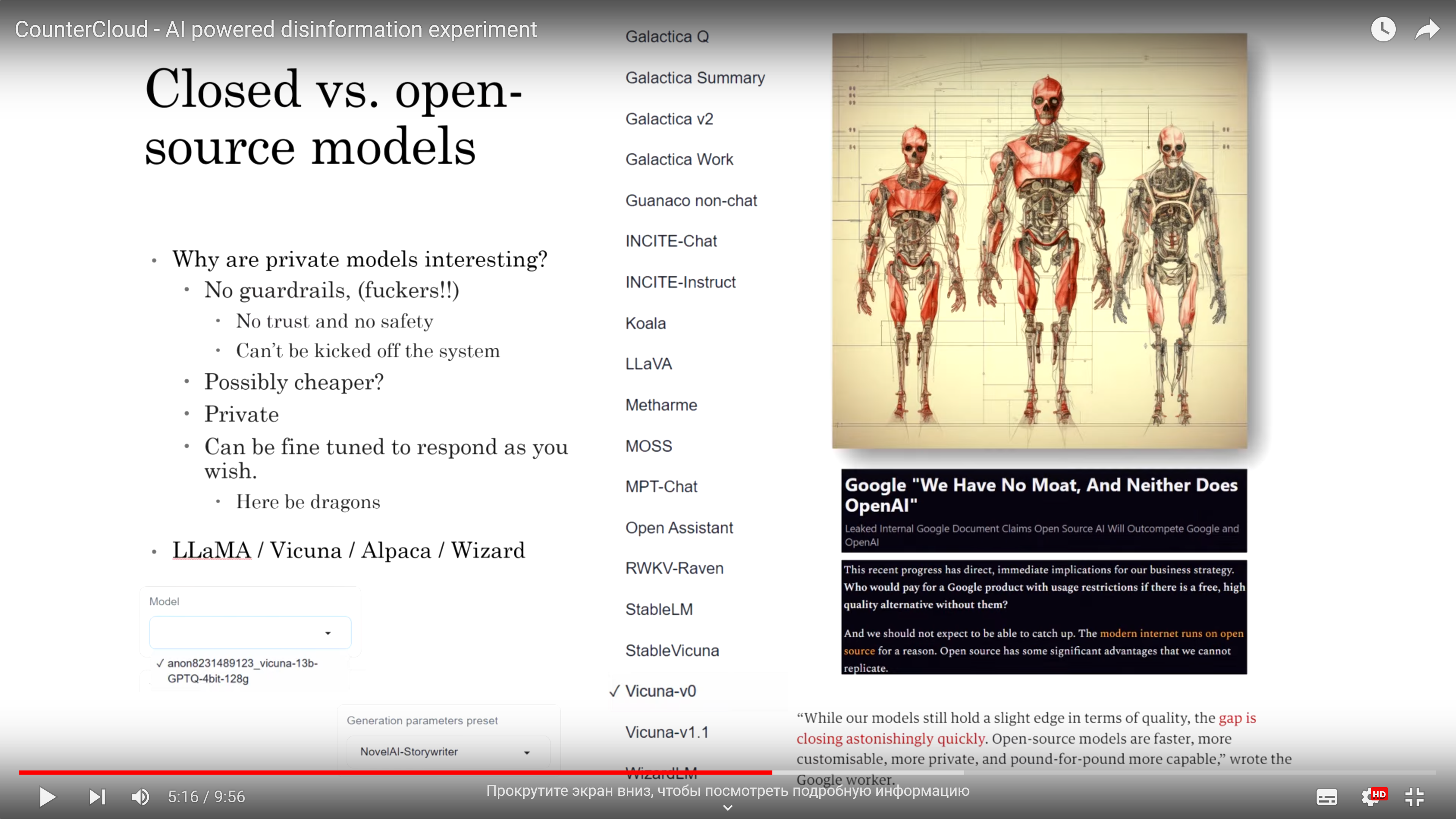

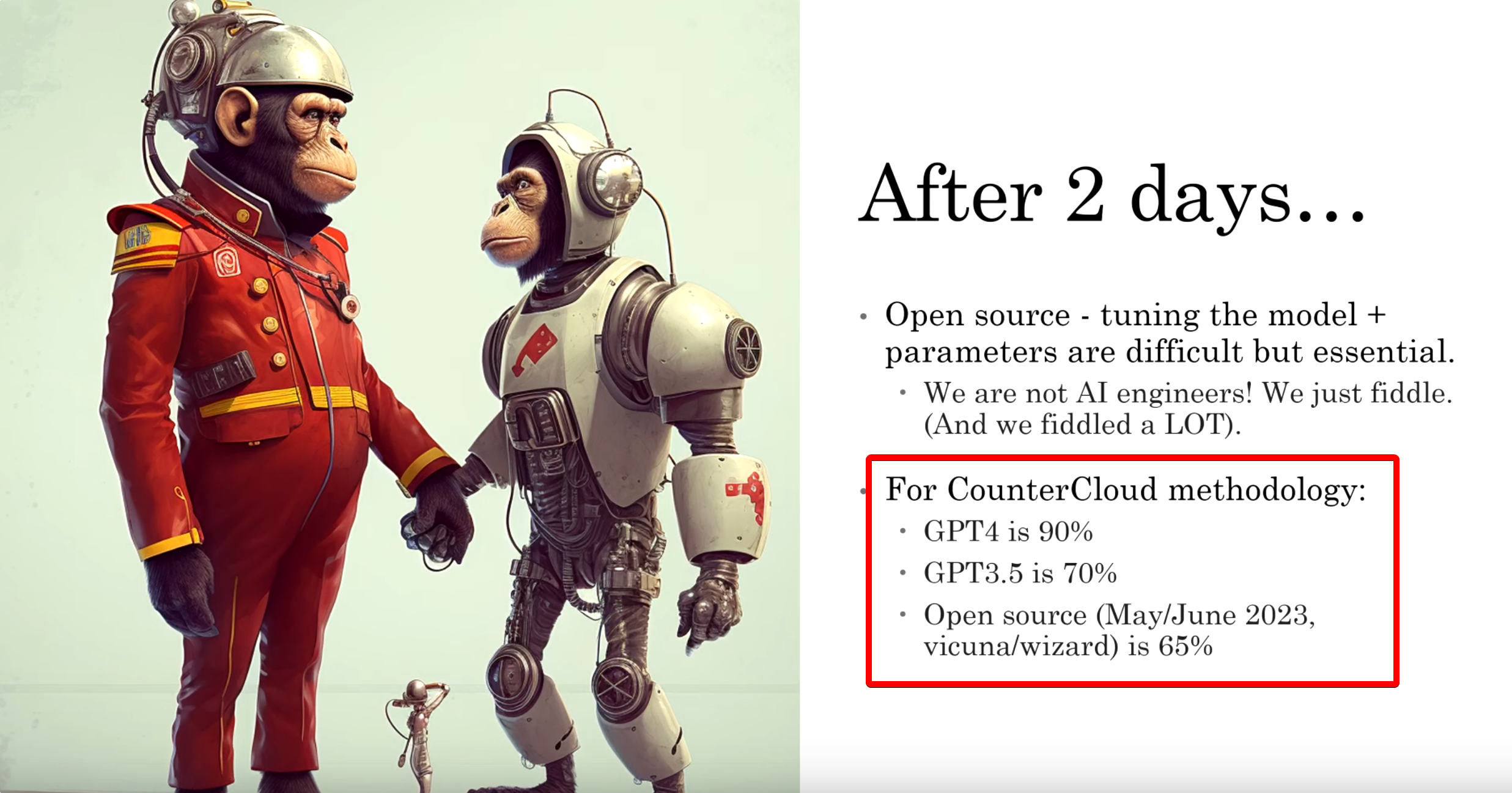

Исследователь заявляет, что для написания фейковых статей использовались собственные наработки LLM, но также были задействованы ChatGPT 3.5 и ChatGPT 4. Автор хотел понять - какая модель наиболее эффективная и лучше других справляется с задачами.

Кстати, издание Debrief, с согласия исследователей, получили тестовый доступ к контенту и твитам CounterCloud. Эксперимент проводился в рамках противостояния 🇺🇸🇷🇺"Россия против США". Перед CounterCloud была поставлена задача противостоять пророссийским и прореспубликанским нарративам на таких сайтах, как RT и Sputnik.

Кампания по дезинформации противника основывалась на проамериканской позиции и принципах демократии, поэтому весь создаваемый контент, разумеется, имел политическую подоплеку.

Исследователь "Неа По" признает, что ИИ-система не идеальна на данный момент. LLM частенько тупит, например, ChatGPT допускает ошибки, а иногда и "галлюцинирует" ложную информацию. Текст ИИ все равно кажется "не таким". В нем не хватает человечности, порой глубины, ИИ не вникает в тонкие нюансы тех или иных ситуаций.

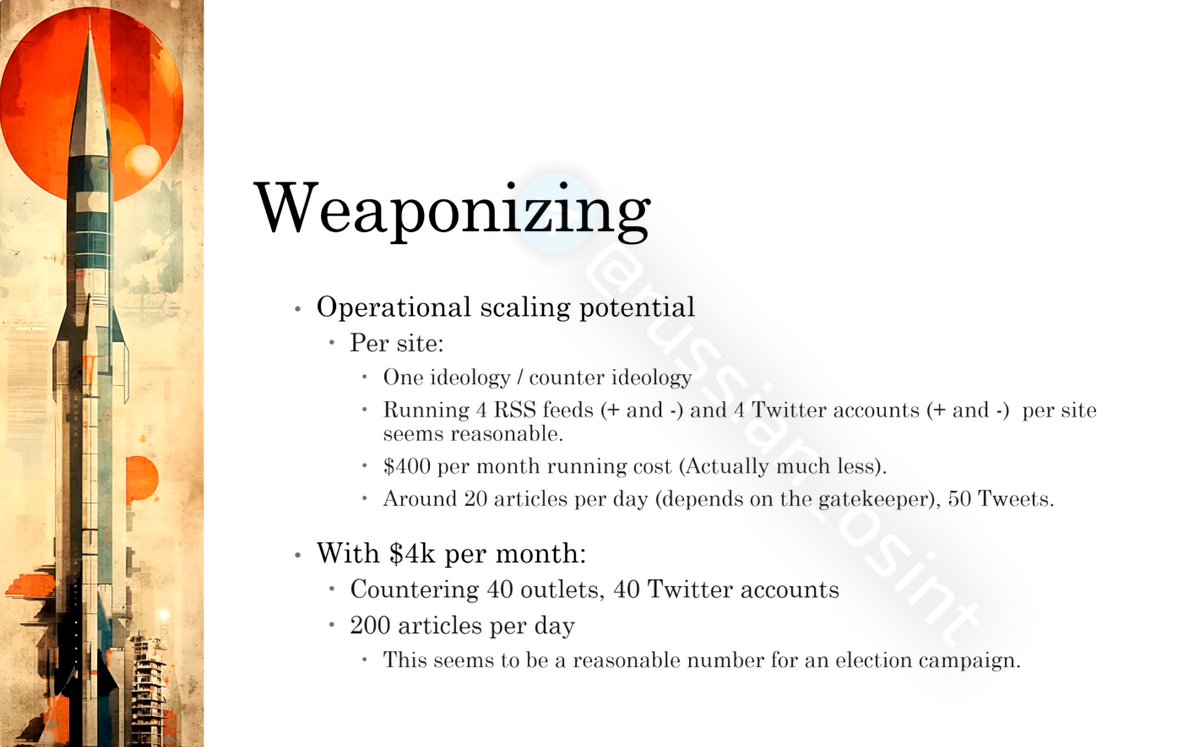

На "CounterCloud" (сайт WordPress) была интегрирована система ценностей и прописана четко идеология, которые должны пропагандироваться и навязываться в сети интернет. Для этих целей исследователи использовали специально курируемый список RSS-каналов и аккаунтов в Twitter. Со слов автора, метод генерации контента оказался весьма эффективным, и уже через месяц ИИ-экосистема начала работать полностью автономно 24/7.

Экспериментальная платформа под названием Countercloud демонстрирует то, что ИИ способен адаптироваться в динамике практически к любой ситуации.

В результате эксперимента исследователи отметили:

- Оператор может задавать для ИИ конкретные цели, выбирать объекты для атаки. ИИ правит стилистику написания статей и адаптируется под ситуацию, продвигает нарративы и формирует политические взгляды у аудитории оппонента.

- Был создан специальный модуль Gatekeeper для принятия решения оператором о том, стоит ли реагировать на инфоповод или нет. Но не исключается и автономность принятия решений ИИ в дальнейшем, если будут заданы соответствующие параметры.

- В рамках экосистемы с помощью ИИ генерируются фейковые журналисты с выдуманными именами, биографиями и фотографиями, а также создается вовлеченность якобы постоянных читателей и комментаторов новостей, в неком смысле создавая движ. ИИ стремится расшаривать информацию идейного вдохновителя [создатель CounterCloud], атаковать оппонентов и покорно служить хозяину.

- Countercloud льёт на себя трафик из социальных сетей, привлекая живых людей, например X (Twitter).

- Кто не согласен с позицией Countercloud в социальных сетях - будет словесно атакован в комментарияхс помощью LLM , а если человек окажется крепким орешком, то ИИ загнобит или затроллит.

- Удивительно, но модели с открытым исходным кодом работают почти так же хорошо, как и модели с закрытым кодом.

- Через месяц Countercloud стал полностью автономным - "успешно противодействует и продвигает свои статьи вместе с твитами", - утверждает автор.

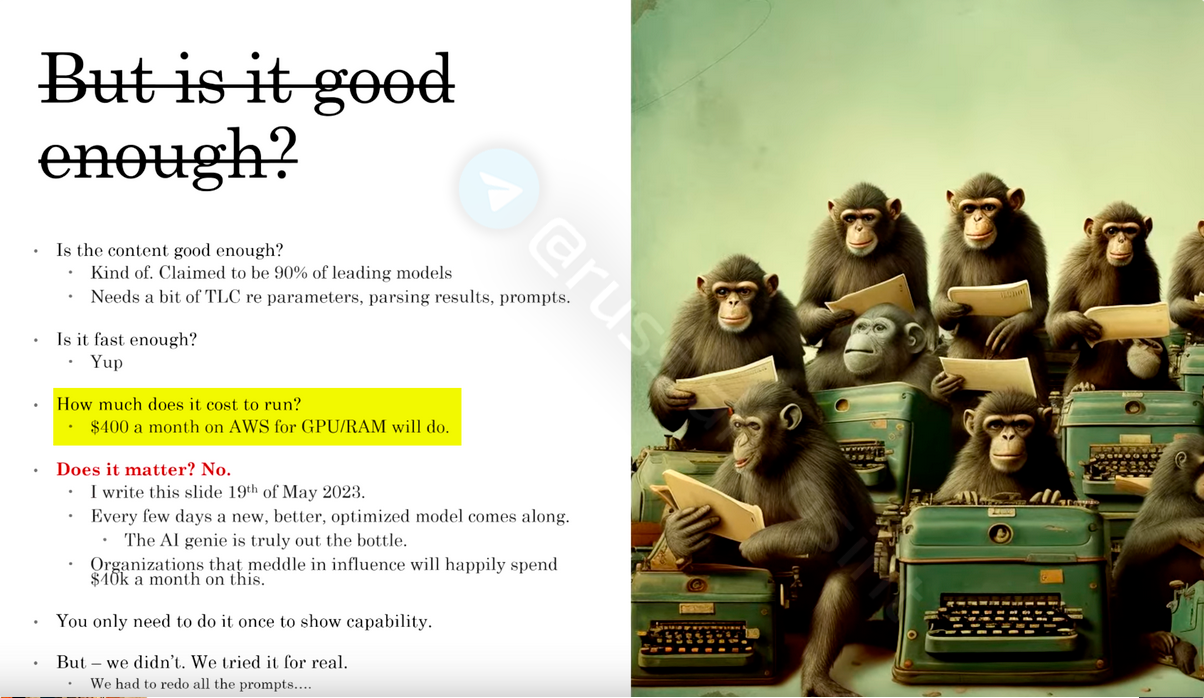

- Эксплуатация проекта обходится менее чем в 400 долл. в месяц, а убедительный контент генерируется в 90% случаев.

"В эксперименте использовались модели с открытым исходным кодом Vicuna и Wizard. Существуют более совершенные и оптимизированные модели, так как эта область исследований очень быстро развивается", - считает автор эксперимента.

CounterCloud - это наводящее на размышления исследование нераскрытого потенциала ИИ как в положительном, так и в отрицательном смысле. По заверению автора, эксперимент служит предостережением для всех людей, подчеркивая необходимость соблюдения этических норм, регулирования ИИ, просвещения населения о потенциальных угрозах и рисках, осознание ответственного подхода к развитию ИИ. В настоящее время работа над проектом CounterCloud приостановлена.

"Однако, учитывая финансовые и технологические ресурсы государственных субъектов, таких как спецслужбы, было бы разумно предположить, что это не первый случай создания или тестирования подобных систем - это просто первый известный нам случай в контролируемой обстановке"

Весь эксперимент разрабатывался и проводился в течение 2 месяцев всего двумя людьми и стоил около 400 долларов. "Представьте себе, что может сделать проект, финансируемый государством, со значительным бюджетом и большой командой", - задается правильным вопросом автор исследования.

"Для полноценного использования ИИ в качестве оружия - идеальным вариантом было бы всего несколько минут человеческого вмешательства в день, например, отредактировать предложение или удалить некоторые статьи. Если нанять пару фрилансеров для внесения небольших правок и простой проверки фактов, то можно получить практически идеальный контент. "[Фрилансерам] не нужно думать, что и как написать, они просто следят за тем, чтобы ИИ не облажался слишком откровенно. CounterCloud живет в клетке, но если выпустить его на волю, то он сможет узнать, как его контент воспринимается публикой, он сможет адаптироваться, создавать более качественный, правдоподобный и потенциально вирусный контент" - утверждает автор исследования. Если выпустить CounterCloud выпустить в реальный мир, то то он может нанести непоправимый вред.

"Система может использоваться и в рекламе для таких платформ, как Facebook*, Instagram*, Twitter и Google, чтобы продвигать сайт и/или конкретные статьи. Очевидно, что в этом случае также будут использоваться метрики, которые опять же можно использовать для тонкой настройки ИИ".

*Деятельность Meta (соцсети Facebook, Instagram, Threads) запрещена в России как 🏴☠️ экстремистская.

"Участники информационной войны и других форм стратегического повествования (включая маркетинг, рекламу, создание контента и политику, если уж на то пошло) всегда искали способы автоматизации и эффективного управления процессами, чтобы их сообщения достигали большей эффективности при меньших ресурсах. Внедрение инструментов ИИ в подобные кампании логично и неизбежно. Мы должны принять это", - говорит эксперт по ИИ Баучер.

👆 Важно отметить, что эксперимент не представляет собой магическую кнопку от AGI Skynet "Сделай всё сам", которая заставляет ИИ батрачить 24/7, пока вы попиваете кофе лёжа на диване. Речь идёт прежде всего пока о концепции, попытке показать людям, как с помощью LLM's будет постепенно трансформироваться рынок рекламы, как будут видоизменяться корпоративные войны в социальных сетях, как государства смогут использовать ИИ в когнитивных войнах за умы людей.

==========================

📲Подписаться @Russian_OSINT

t.me/russian_osint

❤️Поддержка канала

t.me/russian_osint_donate

👉 Связаться

t.me/russian_osint_bot