Побудова експертної мережі за допомогою нейромережних технологій (типу диплом)

Yukhym ShulhaПри виконанні певних речей ми не задумуємось про те як це правильно виконати, це може бути будь що управління автомобілем чи відповідь на дзвінок у смартфоні, цим діям ми навчилися і тепер їх виконання знаходиться за межами нашої концентрації. Саме робота людського мозку завжди є прикладом для наслідуванням і доказом того є створення штучного інтелекту(ШІ). Хоча який сенс, яка реального його користь у реальному житті, та й справді декілька років тому ці питання ділили суспільство на два табори: прихильників і противників. Проте зараз ми бачимо реальні докази того що ШІ не просто має право на життя, але є іще вагомим помічником у житті людини. Але давайте ще понизимо планку і обговоримо лише частинку штучного інтелекту, а назва цій частинці експертна система.

Експертна система являє собою концентрацію знань у певній області і завдяки цим знанням може виконувати роль експерта у певних сферах або діях.

Ось схематичне зображення роботи такої системи, проаналізувавши її можна зробити висновок, що її робота дуже схожа на роботу людини при виконанні певного завдання. І це дійсно так адже в її основі лежить нейронна мережа, але про неї поговоримо пізніше, зараз необхідно розібрати що ж аналізуватиме система у нашому випадку.

У конкретно нашому завданні експертна система аналізуватиме дані отримані при проходженні людиною процедури під назвою електроенцефалограма, доволі знайома процедура таїнство розшифрування якої відоме лише невеликому колу людей. Давайте розбиратися що до чого.

Ось так виглядає табличка яка пояснює шлях розшифрування невідомих графів. Досить складно, чи не так?! Проте в нас мета розібратися з цими поняттями. У ході опису записів електроенцефалограм (ЕЕГ) відокремлюють морфологічні компоненти, а саме: ритми, ознаки епілептиморфної активності, часові та топографічні характеристики. А тепер розберемо кожен з цим термінів.

1.Ритм

Під поняттям "ритм'' на ЕЕГ мають на увазі визначений тип електричної активності, що відповідає певному стану мозку і зв'язаний із церебральними механізмами. У клінічних дослідженнях відокремлюють чотири типи ритмів частоти, що послідовно збільшується: дельта-, тета-, альфа- і бета-ритми.

1.1 Альфа ритм

Альфа-ритм із частотою 8--13 Гц та амплітудою до 100 мкВ є основний для попереднього виявлення відхилень від норми, він реєструється у 85--95% здорових дорослих у спокійному стані із закритими очима. Регулярно спостерігаються спонтанні змінювання амплітуди -ритму, так звані модуляції або веретена як збільшення і зменшення амплітуди хвиль протяжністю 1--8 с. При підвищенні рівня функціональної активності мозку амплітуда і відсоток -ритму в ЕЕГ зменшується аж до повного зникнення (депривація -ритму). При повторному виникненні одного і того самого стимула реакція депривації поступово слабне і через деякий час практично повністю зникає. Швидкість згасання реакції залежить від суб'єктивної значимості стимулу, а також від внутрішнього стану організму, у зв'язку з чим вона може слугувати індикатором стану мозку.

1.2 Бета ритм

Бета-ритм із частотою 14--60 Гц та амплітудою до 15 мкВ є ведучий ритм людини, що не спить. -ритм зв'язаний із соматичними, сенсорними корковими механізмами і дає реакцію на рухову активацію або тактильну стимуляцію. Розрізняють два діапазони -ритму: із частотою 14--18 Гц і із частотою 18--40 Гц. Зазвичай -ритм виражений досить слабо (3--7 мкВ) і може маскуватися шумами і ЕМГ.

1.3 Повільні ритми

Повільні ритми: тета-ритм із частотою 4--6 Гц і дельта-ритм із частотою 0ю5--3 Гц мають амплітуду 40--300 мкВ і у нормальному стані є характерні для деяких стадій сна. і коливання можуть траплятися у невеликій кількості і за амплітуди, що не перевищує амплітуду -ритму, на ЕЕГ дорослої людини, що не спить. У цьому разі вони вказують на деяке зниження рівня функціональної активності мозку. Патологічними вважають ЕЕГ, що містять і - коливання, які перевищують за амплітудою 40 мкВ і які займають понад 15% загального часу реєстрації.

1.4 Частотний аналіз

Частотний аналіз ЕЕГ. Частотний або спектральний, аналіз є база більшості сучасних обчислювальних досліджень ЕЕГ. Сутність його полягає у розкладанні сигнала , що виміряний на певному інтервалі із заданою частотою дискретизації , у послідовність синусоїдальних складових , де , кожна із яких характеризується амплітудою і . Результат такого розкладання подається у вигляді амплітудно-частотної і фазо-частотної характеристик і похідних від них.

А ілюстрація що наведена нижче показує який графік з якої частини мозку взятий. Все ж таки це справді не просто.

2. Епілептиморфна активність

Наявність при епілепсії характерних електрографічних феноменів і певних кореляцій між типами епілептичних припадків і їх електроенцефалографічні паттернами зробило електроенцефалографію методом, не замінним при діагностиці епілепсії, більш точної кваліфікації типу епілептичних припадків, встановлення прогнозу захворювання в контролі за лікуванням хворих.

У зв'язку з цим виникає ще одне можливий і вельми важливий аспект використання ЕЕГ, а саме для виділення осіб з підвищеним ризиком захворювання на епілепсію.

3.Часові та топографічні характеристики

Певною мірою можна замінити аналіз спектру кожного каналу ЕЕГ аналізом топографічних карт розподілу потужності по смугах спектра по поверхні голови. Часто будують похідні від цих величин канонограми (відношення сум потужностей в різних діапазонах частот, наприклад α + β / δ + θ) або ж розподілу амплітуд деяких феноменів в ЕЕГ, в першу чергу епілептиформної активності. Для досліджень функціонування мозку топографічні карти розподілу потужностей або інших величин можуть суміщатися із функціональними зонами кори головного мозку.

Розібравшись з медичними аспектами нашої задачі перейдемо саме до комп'ютерної складової завдання. І перш за все потрібно розібратися більш детально з питанням, яке звучить так: "З чого складається експертна мережа та яким чином вона функціонує?". Давайте розбиратися)

Так як, що таке експертна ми розібралися, то перш за все потрібно пояснити що знаходиться "під капотом". А там ми знайдемо нейронну мережу. Нейронна мережа це відображення роботи головного мозку людини у математичних моделях та у програмному вигляді.

Так як у роботі головного мозку лежать нейрони, то у комп'ютерного мозку основою є персептрони. Персептрон це математична або комп'ютерна модель сприйняття інформації мозком. Виглядає він наступним чином:

Схема його роботи дуже схожа на роботу нейрона, тобто на один із входів приходить певний сигнал, всередині він оброблюється та передає результат на наступний рівень для подальшої обробки або видає кінцевий результат і дія виконується.

Щоб отримати результат певної дії треба спочатку навчитися виконувати цю дію як людині так і штучній мережі. а відбувається це теж за певним алгоритмом.

З ілюстрації ми можемо побачити, що отримана інформація розподіляється по мережі на основі певного прикладу, де відбувається обчислення результату, наступним кроком є розрахунок похибки яка можлива при виконанні обчислення, якщо вона незначна то система вважається навченою, якщо похибка велика, то відбувається корегування певних елементів та повернення на повторне розрахування до тих пір поки похибка не стане допустимою. Треба зазначити, що похибки може взагалі не бути проте це не означає, що система адекватна, адже на певному етапі може дійсно не бути помилок і система показуватиме правильні результати, а от при моделюванні майбутнього процесу система видаватиме зовсім неправдиві показники, тому похибки це нормально.

Порівняння роботи нейронної мережі із людиною. Це порівняння показує, що результати дійсно схожі, і фінальні результати однакові не зважаючи на помилки на 1 і 2 ітераціях відповідей у нейронній мережі. Одна з причин таких результатів це певні правила за якими відбувається навчання у "штучного мозку" .

Розглянемо три основні парадигми навчання

- Навчання з вчителем один із способів машинного навчання, в ході якого випробувана система примусово навчається за допомогою наявної множини прикладів «стимул-реакція» з метою визначення «реакції» для «стимулів», які не належать наявній множини прикладів. З точки зору кібернетики, є одним із видів кібернетичного експерименту.

- Навчання без вчителя один із способів машинного навчання, при вирішенні яких випробовувана система спонтанно навчається виконувати поставлене завдання, без втручання збоку експериментатора. З точки зору кібернетики так само є одним із видів кібернетичного експерименту. Навчання без вчителя часто протиставляється навчанню з вчителем коли ля кожного об'єкта, що навчається примусово задається "правильна відповідь", і потрібно знайти залежність між стимулами та реакціями системи.

- Змішане навчання або навчання з підкріпленням є проміжним варіантом двох попередніх парадигм . Замість «вчителя» в схему навчання вводиться блок «критика» , який відслідковує реакцію середовища на вхідний сигнал і опираючись на неї визначає евристичну похибку, яку покладено в процес навчання мережі. Вказані парадигми базуються на відповідних правилах навчання, які визначають основні особливості їх застосування

А тепер основні правила її навчання

- Правило корекції за помилкою. При навчанні з вчителем для кожного вхідного прикладу заданий бажаний вихід d. Реальний вихід мережі у може не збігатися з бажаним. Являє собою такий метод навчання, при якому вага зв'язку не змінюється до тих пір, поки поточна реакція перцептрона залишається правильною. При появі неправильної реакції вага змінюється на одиницю, а знак (+/-) визначається протилежним від знаку помилки. Навчання має місце тільки у разі, коли перцептрон помиляється. Відомі різні модифікації цього алгоритму навчання: метод корекції помилок без квантування, метод корекції помилок з квантуванням, метод корекції помилок з випадковим знаком підкріплення, метод корекції помилок з випадковими збуреннями.

- Правило навчання Больцмана є стохастичним правилом навчання(там де використовується одна або більше випадкових величин), яке виходить з інформаційних теоретичних і термодинамічних принципів. Метою навчання Больцмана є таке налаштування вагових коефіцієнтів, при якому стани видимих нейронів задовольняють бажаний розподіл вірогідності. Навчання Больцмана може розглядатися як спеціальний випадок корекції за помилкою, в якому під помилкою розуміється розбіжність кореляцій полягань в двох режимах.

- Дельта правило. Метод навчання персиптрону за принципом градієнтного спуску по поверхні помилки. Дельта правило розвинулося із правил Хебба. Його подальший розвиток привів до створення методу зворотного поширення помилки. Перше правило Хебба — Якщо сигнал перцептрона невірний, і дорівнює нулю, то необхідно збільшити ваги тих входів, на які була подана одиниця. Друге правило Хебба — Якщо сигнал перцептрона невірний і дорівнює одиниці, то необхідно зменшити вагу тих входів, на які була подана одиниця.

- Навчання методом змагання. На відміну від навчання Хебба, в якому безліч вихідних нейронів можуть збуджуватися одночасно, при навчанні змагання вихідні нейрони змагаються між собою за активізацію. Це явище відоме як правило «переможець бере все». Подібне навчання має місце в біологічних нейронних мережах. Навчання за допомогою змагання дозволяє кластеризувати вхідні дані: подібні приклади групуються мережею відповідно до кореляцій і подаються одним елементом. При навчанні модифікуються тільки ваги нейрона, що «переміг». Ефект цього правила досягається за рахунок такої зміни збереженого в мережі зразка (вектора вагів зв’язків нейрона, що «переміг»), при якому він стає трохи ближчим до вхідного прикладу.

Таким чином ми дійшли майже до фіналу цього трактату. Залишилося розібратися як ці правила втілюються в життя.

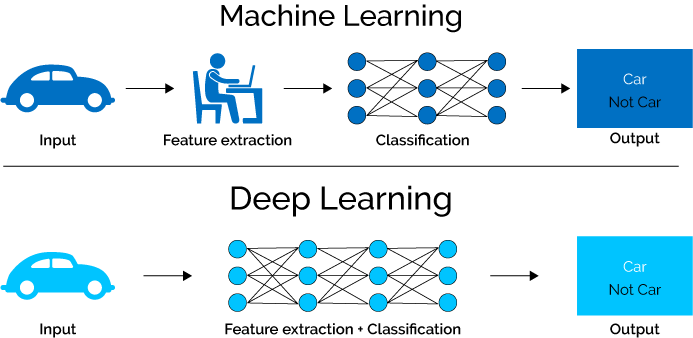

А втілюються вони у життя за допомогою так званого машинного навчання. Машинне навчання це використання алгоритмів аналізу даних, отриманих висновків і виносу рішення або передбачення щодо чого-небудь. Тобто замість створення програм вручну за допомогою спеціального набору команд для виконання певного завдання машину навчають за допомогою великої кількості даних і алгоритмів, які дають їй можливість навчитися виконувати це завдання.

Разом із машинним навчанням завжди чути глибинне навчання, то що ж воно таке. Глибинне навчання являє собою підрозділ машинного навчання з використанням нейронних мереж. Проте є відмінності між нейронними системами самостійними та тими які працюють у глибинному навчання. В нейронної мережі, яка використовується в глибинному навчанні, більше прихованих шарів. Ці шари розташовані між першим, або вхідним і останнім, вихідним, шаром нейронів. При цьому зовсім не обов'язково пов'язувати всі нейрони на різних рівнях між собою.

Як було сказано вище глибинне навчання є частиною машинного навчання і їх зв'язок найкраще проілюструвати наступною картинкою.

Підводячи підсумок можна сказати, що такі системи можуть значно полегшити життя не тільки медикам, а взагалі людству, проте їх впровадження на данному етапі має свої труднощі, однак кількість експериментів зростає, що в свою чергу через певну кількість часу дасть свої результати і в найближчому майбутньому є великі шанси побачити такі системи не в якості експерименту, а вже в реальній роботі.