Тикет

1. Первый вопрос о правильном закрытии пагинации в robots.txt - как правильно закрыть от индекса пагинацию в нашем случае?

Сайтмап у нас не по дефолтному адресу: https://teleggid.com/sitemap_lisa_zayac.xml

Использовали недефолтный адрес и убрали ссылку на сайтмап из robots осознанно: нашли информацию о том, как при помощи сайтмапа парсят информацию с сайта и решили поменять название файла

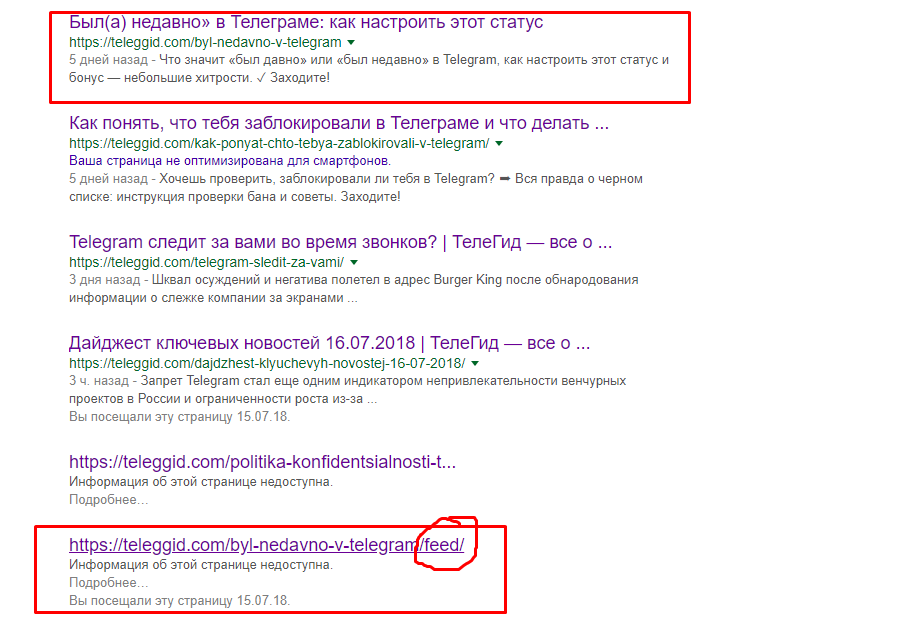

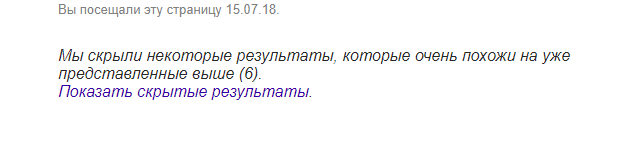

2. В основной поисковой выдаче гугла есть только те страницы, которые мы действительно и хотели показывать, однако есть еще "скрытые результаты", в которых выдаются закрытые в robots.txt страницы:

Проверяли через site:https://teleggid.com/

Подскажите, что делать в данной ситуации, норма ли это?

3. Также в поисковой выдаче в скрытых результатах мы заметили дублирование страниц с /feed в конце (директива /feed закрыта в robots.txt):