POST/GET

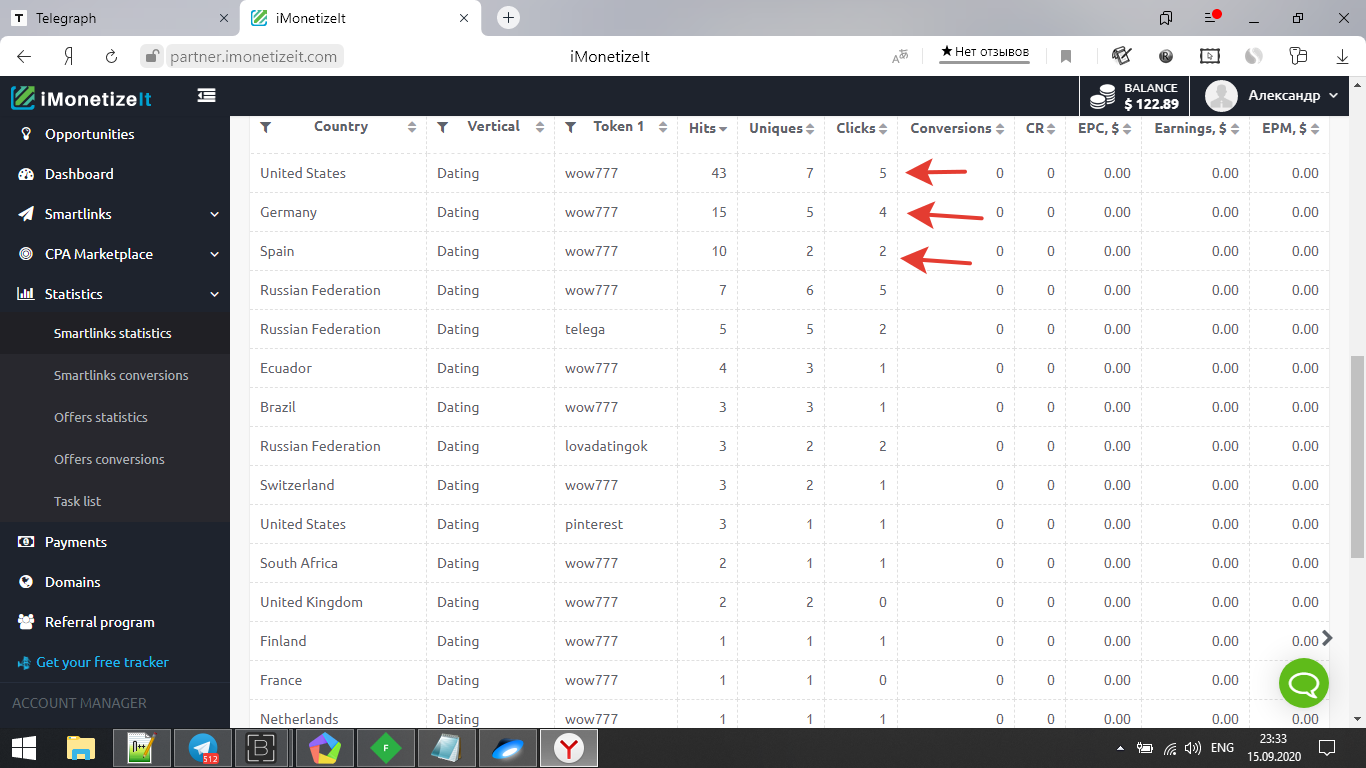

@fradykrugerВсем салют! Решил вот первый минимануальчик запилить про беспл.арбитраж.А конкретно добыча трафа из прил посредством перехвата пост\гет запросов и автоматизации в басе.Сразу оговорюсь.С данной прилы нечего не поимел,трафик там подвыжат судя по уникам.Стата ниже.Но опыт-дороже денег!))

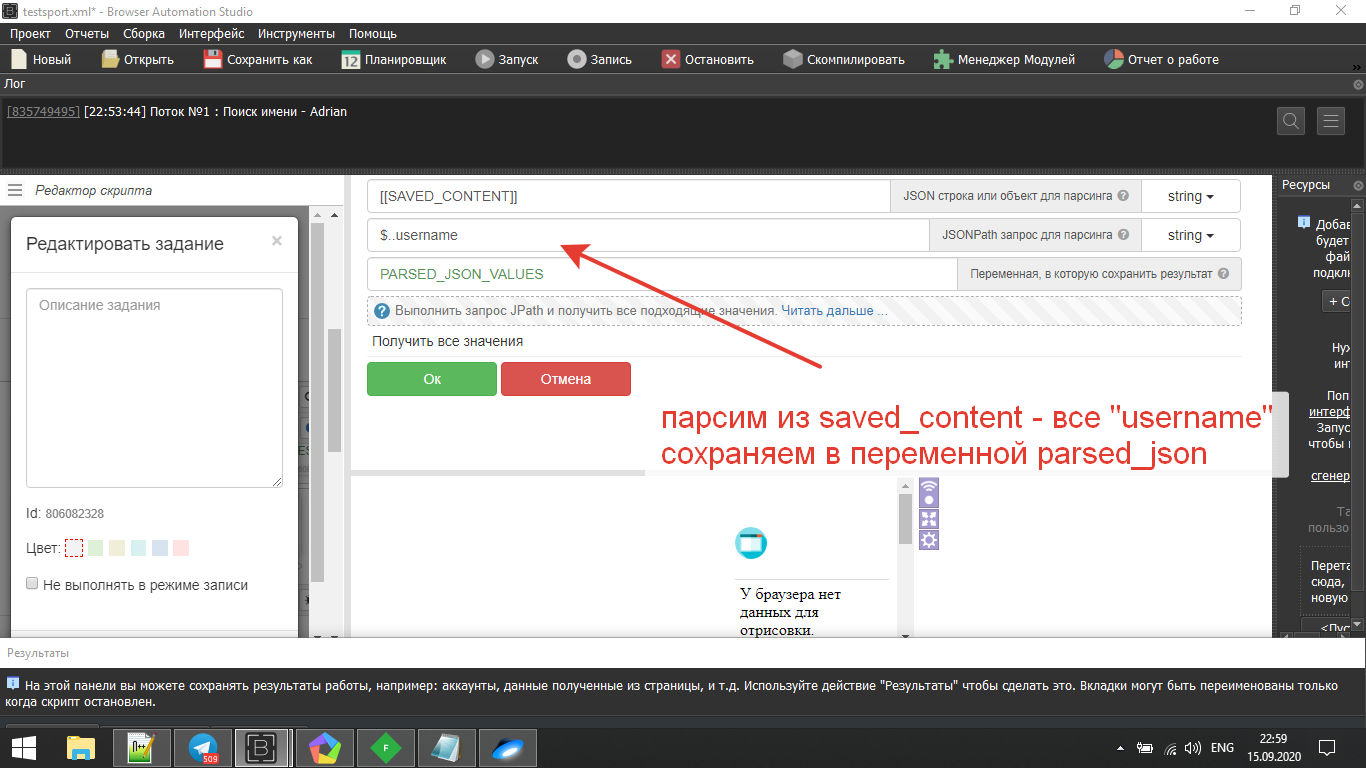

Про то как настраивать перехват запросов есть как минимум два мануала на зенофоруме,курите их.)По басу тоже есть уроки на ютубе,сам в основном научился по видосам,но бывало не находил инфу и пробовал методом тыка.Например я раньше парсил данные регулярками,а сейчас json-ом.Это намного проще и удобнее.

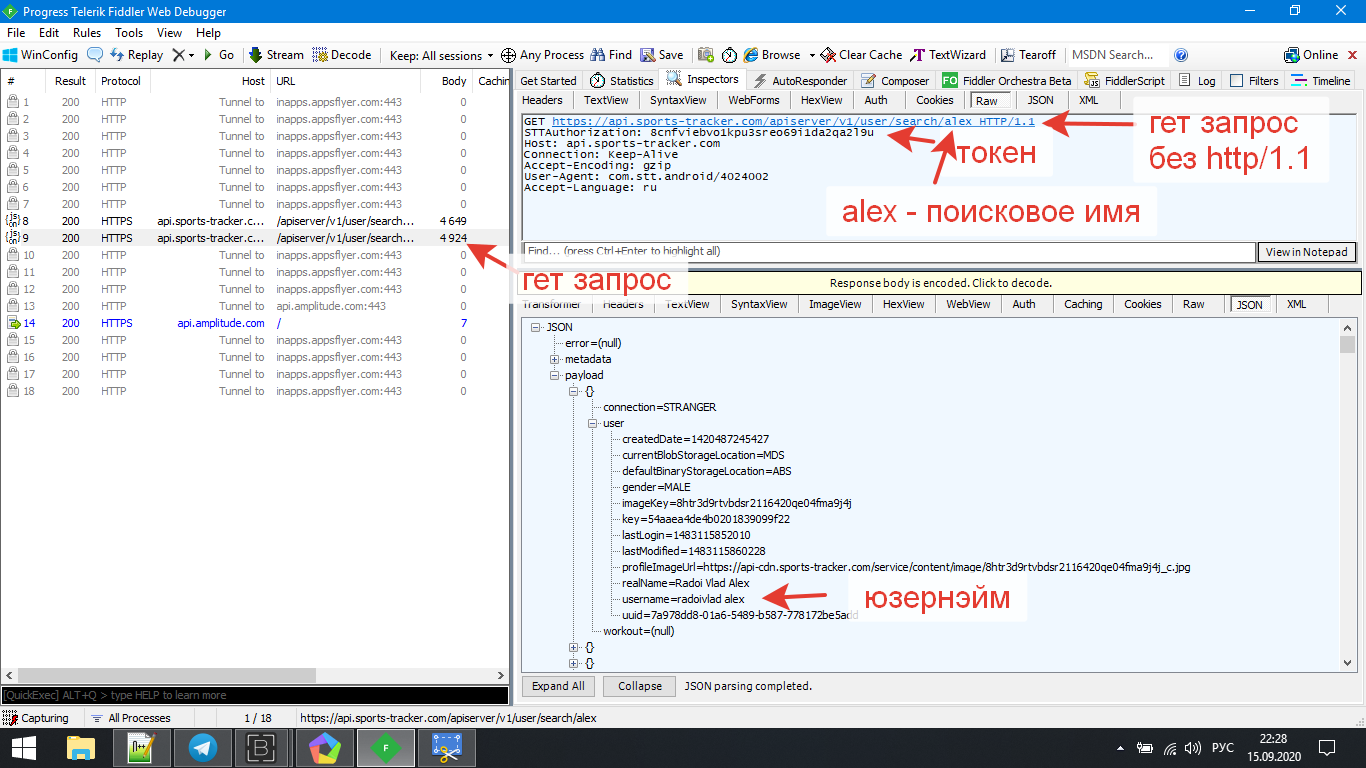

Ближе к делу.Решил я протестить аналоги "strava" Есть кстати мануал по ней. В итоге остановился на приле sports tracker,ибо запросы без проблем ловились.

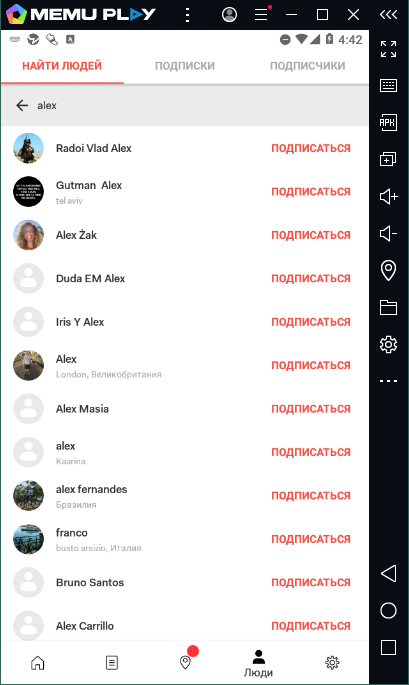

Мой анализ прилы показал:Есть регистрация,фото профиля,есть взаимодействие с аудиторией путем подписок(мгновенно приходит уведомление),линки можно ставить в статус,но будут некликабельны,Есть ограничение на подписки в сутки - 14 штук(об этом позже),и прила использует вместо ID - Username,что усложняло задачу,ибо аккаунты придется парсить.

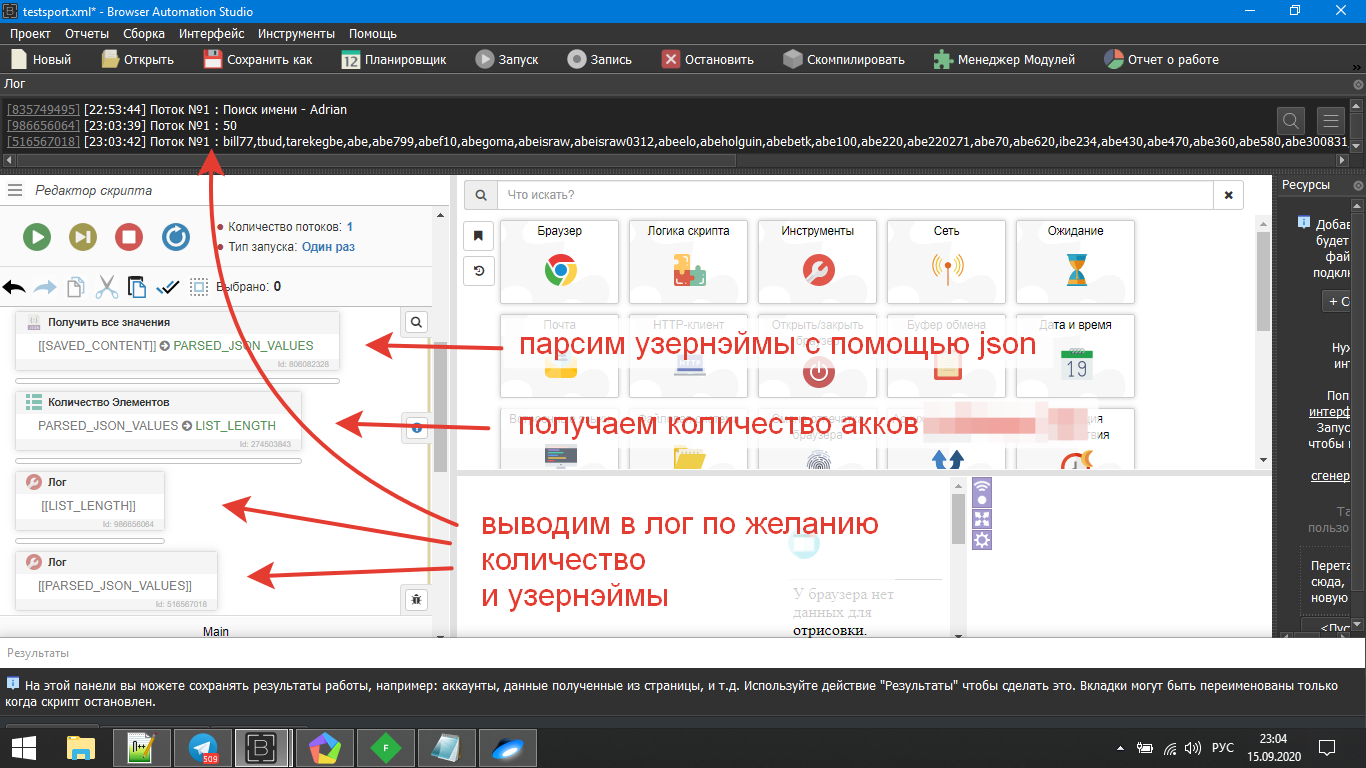

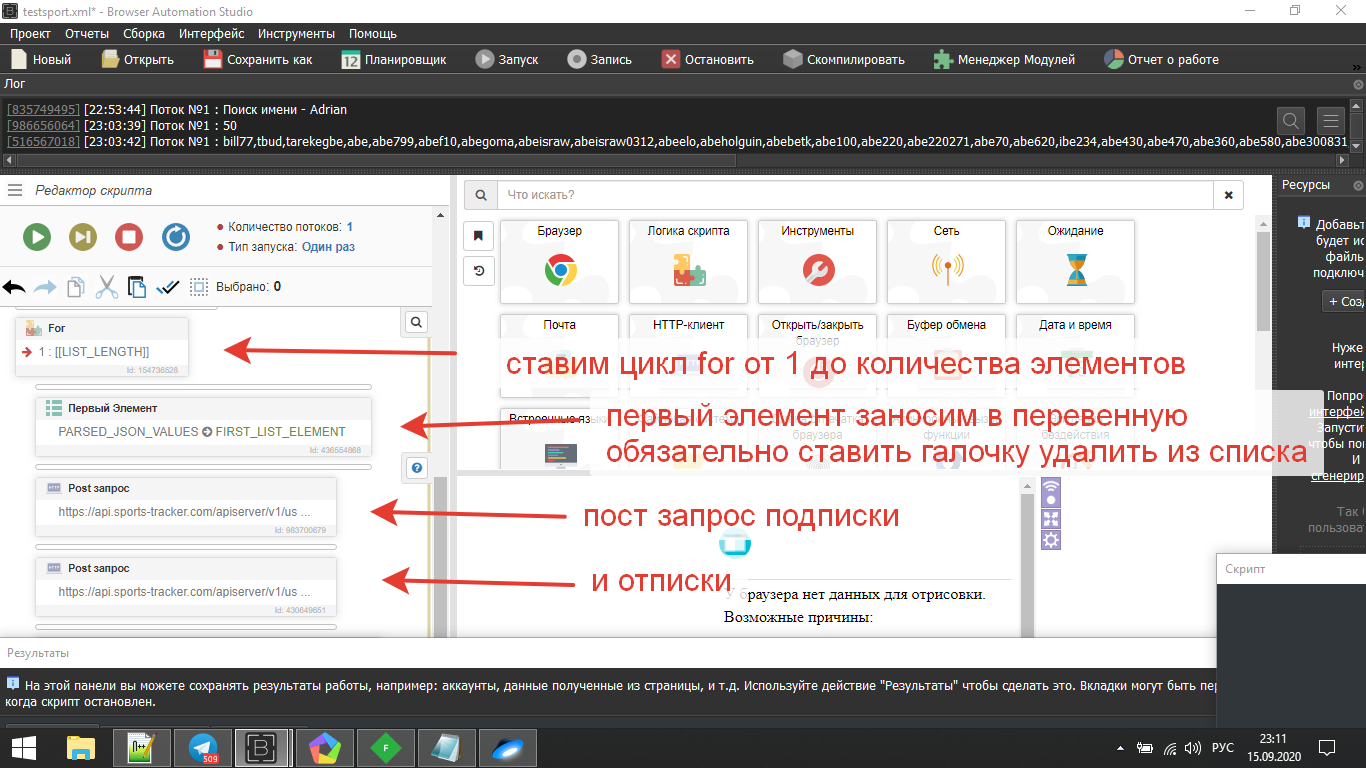

Но и с парсингом было не всё так просто. Вводишь в поиск имя,и прила выдаёт максимум 50 акков и нечего с этим неподелать.

.

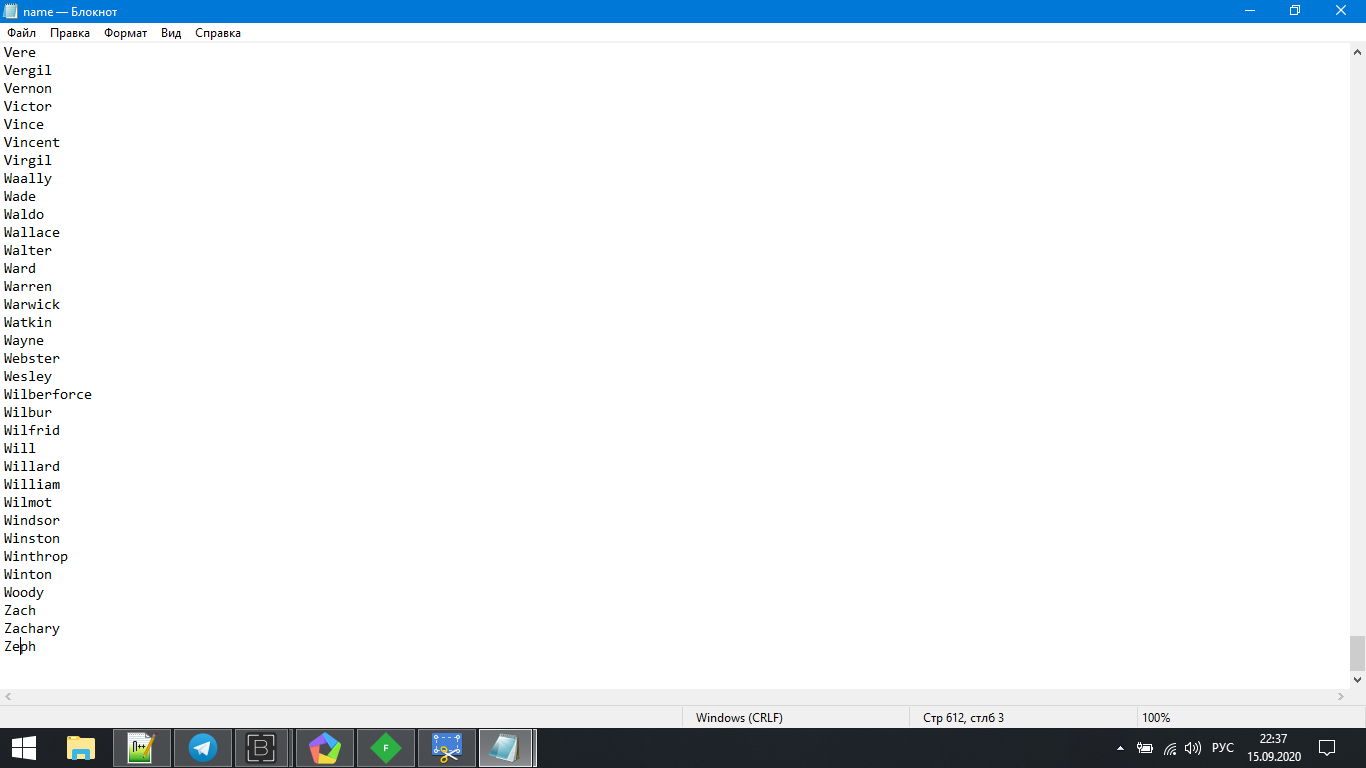

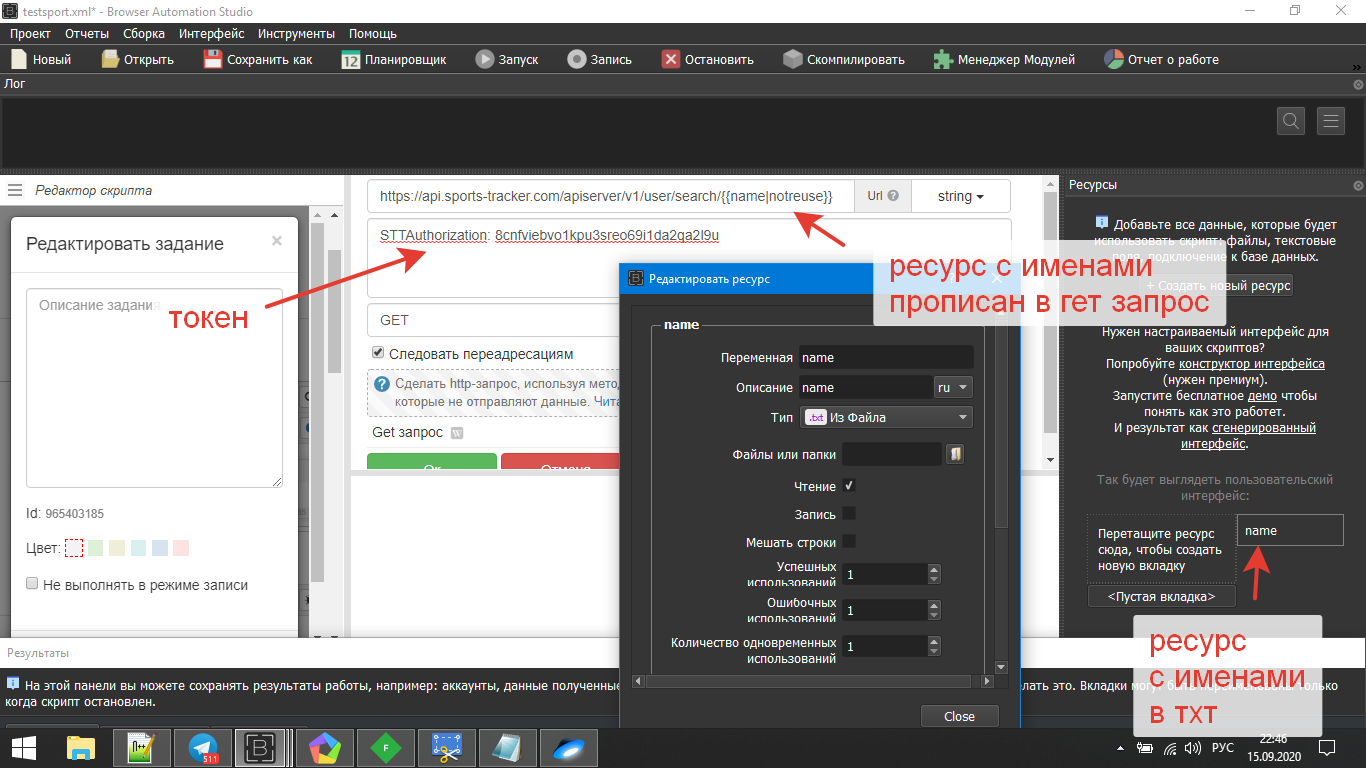

Было принято решение для начала спарсить англ.мужские имена.В тхт было проблемно найти.Нашел сайт с именами.Написал простенький парсер на басе получил 600 имен в тхт.Далее в BASe это будет наш ресурс для парсинга.

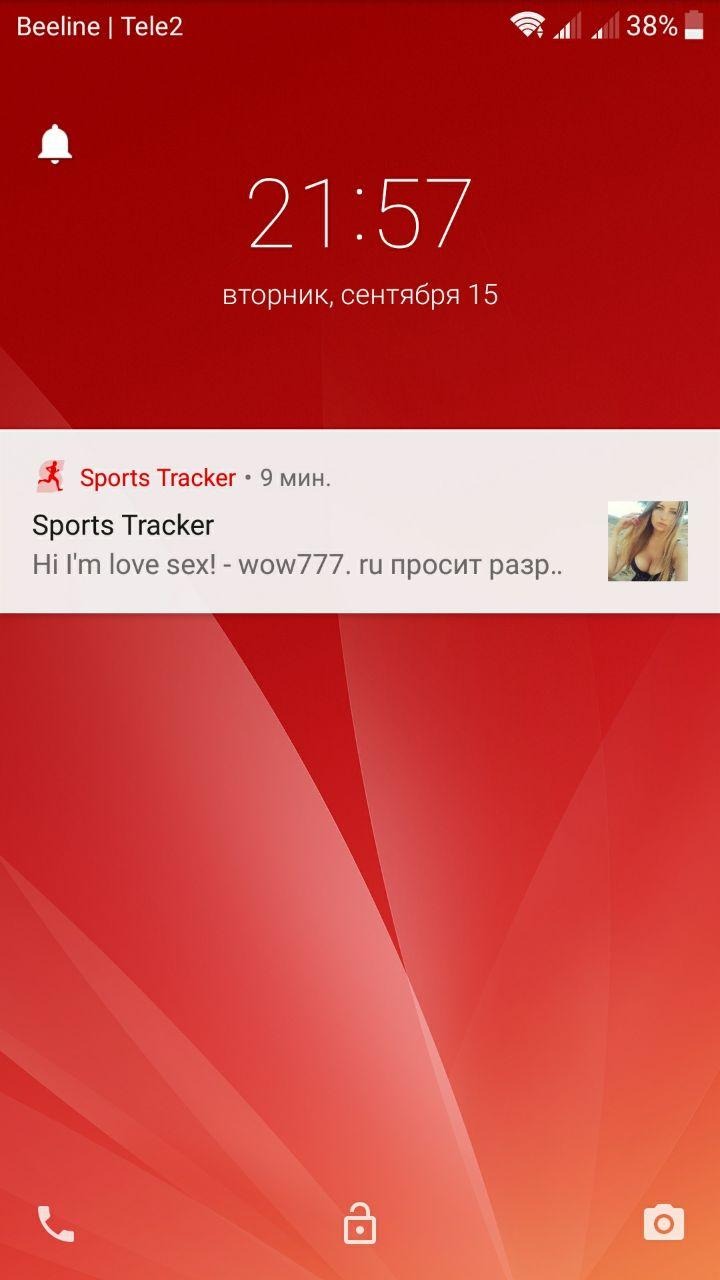

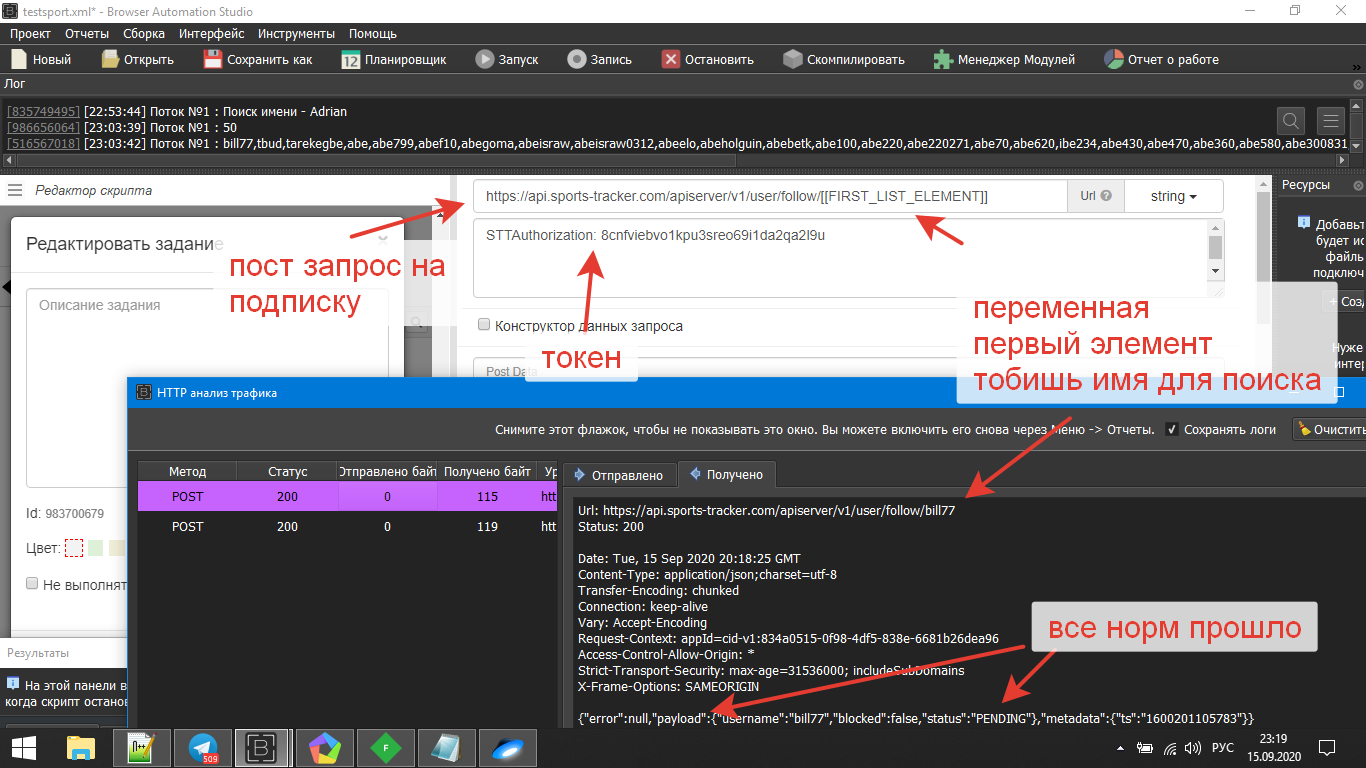

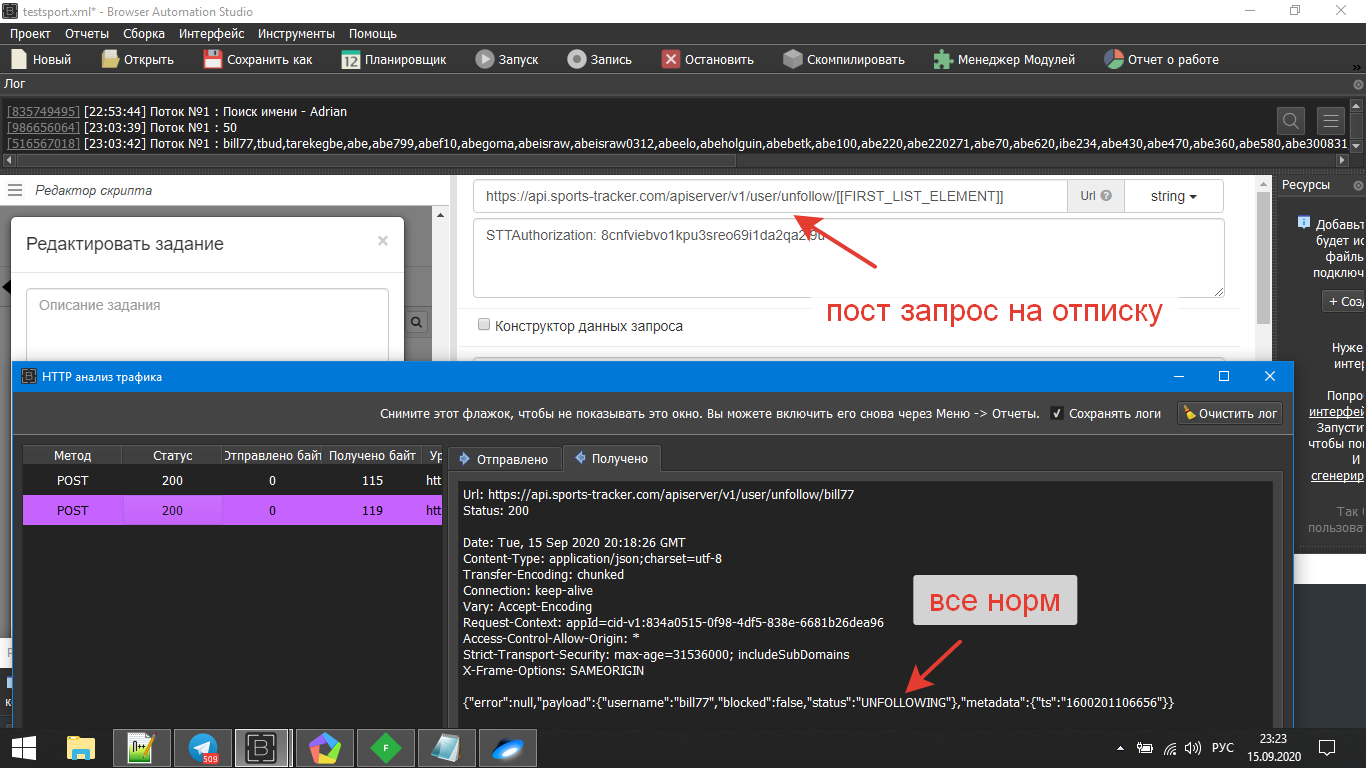

Пришел на ум такой вариант работы : подписка - отписка,и так по кругу.Но дело в том,что когда я подписался-отписался юзеру приходит уведомление,но перейдя по нему он не попадает на мою анкету,ибо я отписался.В уведомлении не виден мой статус с линкой,но видно имя.Вот как раз в имя я и запихнул линку.Выглядело это так...

Видно фотку сисей,короткое крео и линку.Ну хоть так...Кстати на ру домен не советую лить бурж траф.Поэтому у меня было так мало хитов.

Итак начнем по фидлеру и басу...

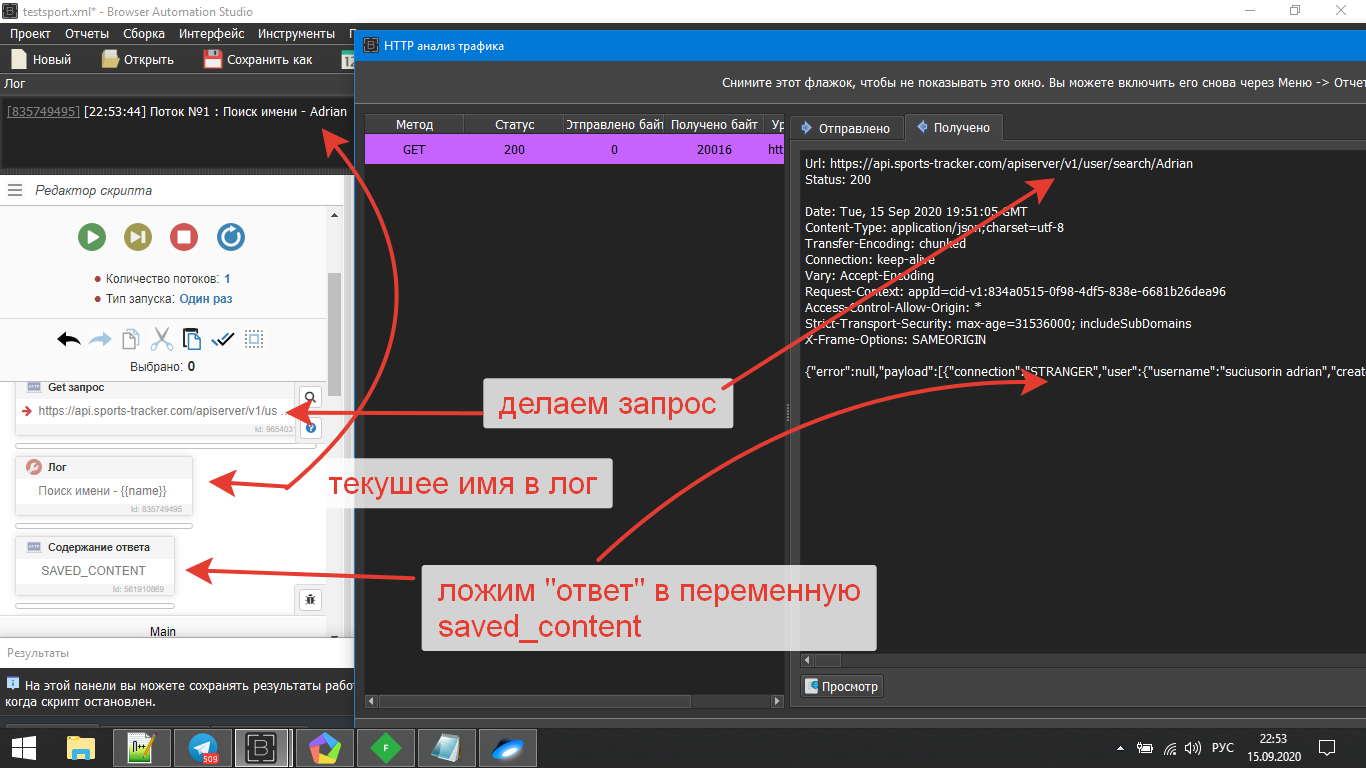

Берем гет запрос на поиск и токен.Прописываем в http клиенте в басе.Так же добавляем ресурс с нашими именами в тхт (одна строка один раз) и ставим его после search/ убираем галочку повторное использование!

Вот в принципе и всё! Логика скрипта:берёт имя из ресурса,парсит до 50 ти акков,отрабатывает их на подписку - отписку,далее берет новое имя и так пока все имена не отработает.Хз может что-то упустил.Ну не обессудьте :d