Многозначительный финал истории AlphaGo

Андрей СебрантНа днях в истории алгоритмов, обучающихся игре в го, была поставлена несколько неожиданная, но очень элегантная точка. Мне кажется важным посмотреть на всю историю целиком. Она красива и даже поучительна. Но текст становится не заметкой, а лонгридом ;)

Начнем издалека:

1989 год. IBM принимает решение создать шахматный компьютер, в перспективе способный обыграть человека. Нанимаются разработчики лучших шахматных программ того времени и начинается разработка специализированного шахматного процессора.

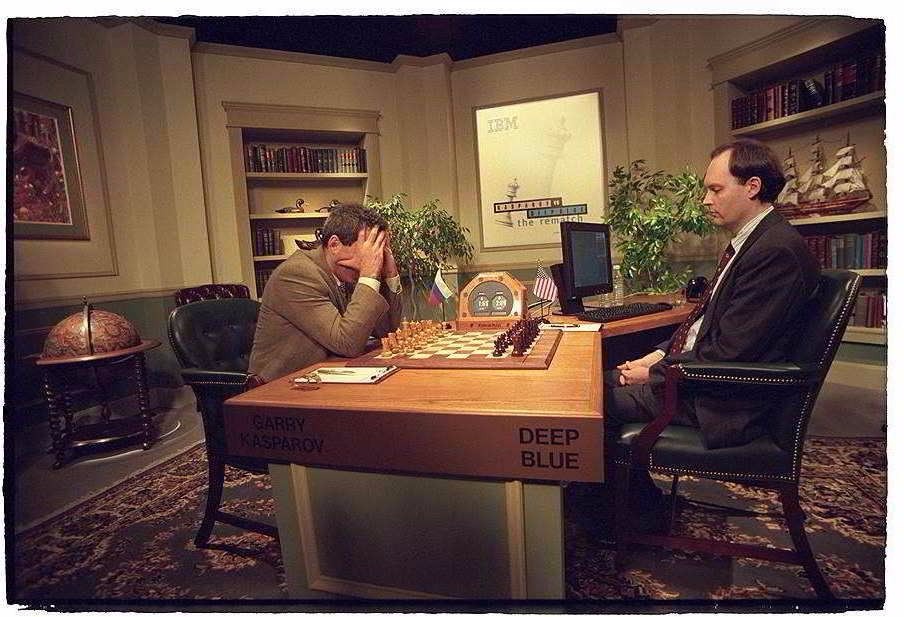

1995 год. Закончена разработка шахматного процессора, создана первая работоспособная версия машины Deep Blue. Deep Blue One играет с Каспаровым и продувает ему 2:4. По итогам игры с живым чемпионом вносятся изменения в конструкцию микропроцессора.

1997 год. Группа гроссмейстеров принимает участие в совершенствовании софта Deep Blue, корректируя позиционные факторы. в мае Deep Blue Two выигрывает у Каспарова 3,5:2,5.

Deep Blue демонстрировал, во-первых, возможности аппаратной базы: мощная многопроцессорная специализированная архитектура и несколько этапов анализа позиции позволяли перебором просчитывать практически все дерево возможных ходов и выбирать очередной ход машины на основе оценочной функции, построенной людьми и использовавшей внутри коэффициенты, выбранные на основе предложений лучших гроссмейстеров. В начале игры использовались дебютные книги, опять же подготовленные командой гроссмейстеров: во многом Deep Blue был воплощением коллективного разума шахматного сообщества.

(источник - https://www.eff.org/ai/metrics )

Примерно в это время на сцену выяснения отношений между компьютером и человеком и выходит го: как игра, в которой переборами и просчетом вариантов ничего добиться нельзя; этих вариантов слишком много. Потому-то важнейшими категориями при оценке позиции служат категории скорее эстетические и плохо алгоритмизируемые: ее сбалансированность, красота, внутренняя мощь. Но простые оценки показывают, что если вычислительные мощности растут даже быстрее, чем по закону Мура, все равно в ближайшие десятилетия машинам ничего не светит. Интуиция, а не умение просчитать позицию является главным оружием игрока. Подход DeepBlue не сулил победы компьютера в обозримом будущем.

Быстро промотаем в XXI век.

2010 год. В Лондоне основан стартап DeepMind Technologies. Довольно быстро к компании, которая заявляла, что собирается решить проблему интеллекта путем создания самообучающихся интеллектуальных агентов, начал проявлять интерес и прицениваться Фейсбук. Но не договорились, и в 2013 переговоры прекращаются. Зато...

2014 год. Компанию приобретает Гугл (сумма в точности неизвестна, но эксперты сходятся в том, что она составила где-то около полумиллиарда долларов) и переименовывает компанию в Google DeepMind

В этом же году в своих публикациях сотрудники компании описывают архитектуру гибридной нейронной сети, демонстрировавшей хорошую способность к обучению. В компании начинают изучать, как методы глубинного обучения сработают для игры в го, и начинается разработка программы AlphaGo.

А в Wired в мае появляется большая статья философа Алана Левиновица The Mistery of Go, the ancient game that computers still cannot win. В ней подробно обосновывается, со ссылками на экспертов и лучших мастеров го, почему даже десять лет кажется слишком оптимистичной оценкой времени, когда машины догонят людей в игре в го.

…another ten years may prove too optimistic. And while programmers are virtually unanimous in saying computers will eventually top the humans, many in the Go community are skeptical. "The question of whether they'll get there is an open one," says Will Lockhart, director of the Go documentary The Surrounding Game. "Those who are familiar with just how strong professionals really are, they’re not so sure."

2015 год. В октябре AlphaGo играет с трехкратным чемпионом Европы Фань Хуэем и выигрывает 5:0. Сам Фань Хуэй говорит, что матч многое открыл ему и показал дорогу к совершенству; рейтинг его начинает расти. Но европейские игроки традиционно не слишком высоко котируются в мире го.

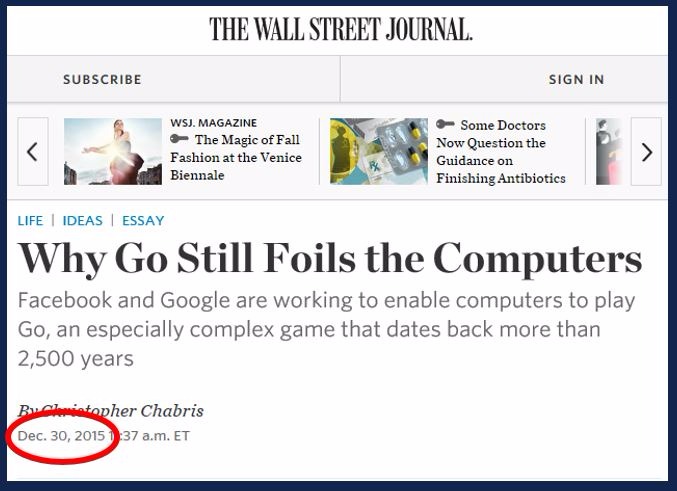

В декабре традиционно тормозной когда дело касается технологий The Wall Street Journal публикует статью Why Go Still Foils the Computers. На этот раз сложность проблем, стоящих на пути к созданию машины, блестяще играющей в го, описывает психолог.

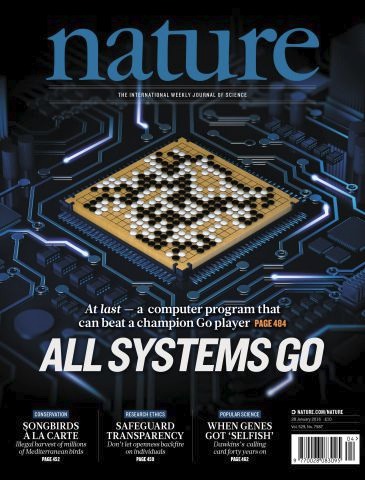

2016 год. В феврале выходит статья в Nature, посвященная AlphaGo

и матчу с Фань Хуэем, вокруг нее поднимается сильный шум в массовой прессе.

В марте AlphaGo играет с корейским обладателем 9 дана в го, мастером Ли Седолем и выигрывает у него 4:1. Позже об этом матче будет снят большой документальный фильм "AlphaGo", который скоро, кстати, покажут в Москве, а в Яндексе будет вечер обсуждений вокруг него.

Текущая версия AlphaGo обучалась на лучших партиях мастеров в го, а потом самосовершенствовалась, играя сама с собой.

В мире го начинается дискуссия о том, насколько хорошо Ли Седоль представил человечество и можно ли обыграть машину. Сам Ли Седоль отмечал во время пресс-конференции сказал, что его поражение — это «поражение Ли Седоля», а не «поражение человечества». Упомянутый выше фильм тоже построен вокруг этой идеи.

2017 год. На саммите о будущем го в мае AlphaGo выигрывает все показательные партии, в том числе три из трех с китайцем Кэ Цзе, который после проигрыша Ли Седоля заявлял, что знает, как обыграть машину.

Создатели AlphaGo по итогам саммита заявляют, что больше программа не будет играть с людьми, и что не планируется выпуск ее версии для широкого пользования. Казалось бы, вопрос закрыт.

Но в октябре DeepMind сообщает, что была разработана еще одна версия программы, принципиально отличающаяся от тех, которые играли с людьми. Эта версия, AlphaGo Zero, вообще не использовала накопленный игроками опыт и записи партий между людьми в процессе обучения. Ей были сообщены только правила, цель - и предоставлена возможность самосовершенствоваться в игре самой с собой. Стартовав с такого нулевого уровня, за трое суток алгоритм сыграл 5 миллионов партий сам с собой. После этого его выпустили поиграть с той версией, которая побеждала сильнейших игроков людей (и использовала их опыт в начале обучения). AlphaGo Zero разгромила прошлые версии со счетом 100:0.

Это многозначительная точка в конце поучительной истории.